Нейронные сети представляют собой параллельные вычислительные устройства, что в основном является попыткой сделать компьютерную модель мозга. Основная цель — разработать систему для выполнения различных вычислительных задач быстрее, чем традиционные системы. Эти задачи включают распознавание и классификацию образов, аппроксимацию, оптимизацию и кластеризацию данных.

Что такое искусственная нейронная сеть?

Искусственная нейронная сеть (ANN) — эффективная вычислительная система, центральная тема которой заимствована из аналогии биологических нейронных сетей. ANN также называются «искусственными нейронными системами» или «параллельными распределенными системами обработки» или «системами соединения». ANN приобретает большой набор блоков, которые связаны по некоторому шаблону для обеспечения связи между блоками. Эти единицы, также называемые узлами или нейронами, являются простыми процессорами, которые работают параллельно.

Каждый нейрон связан с другим нейроном через канал связи. Каждая ссылка на соединение связана с весом, который имеет информацию о входном сигнале. Это наиболее полезная информация для нейронов для решения конкретной проблемы, потому что вес обычно возбуждает или подавляет передаваемый сигнал. Каждый нейрон имеет внутреннее состояние, которое называется сигналом активации. Выходные сигналы, которые вырабатываются после объединения входных сигналов и правила активации, могут отправляться на другие устройства.

Краткая история ANN

История ANN может быть разделена на следующие три эпохи —

ИНН в течение 1940-1960-х годов

Некоторые ключевые события этой эпохи заключаются в следующем —

-

1943 — Предполагается, что концепция нейронной сети началась с работы физиолога Уоррена МакКаллока и математика Уолтера Питтса, когда в 1943 году они смоделировали простую нейронную сеть с использованием электрических цепей, чтобы описать, как нейроны в мозге могут Работа.

-

1949 — в книге Дональда Хебба « Организация поведения» подчеркивается тот факт, что повторная активация одного нейрона другим увеличивает его силу при каждом использовании.

-

1956 — Тейлор ввел ассоциативную сеть памяти.

-

1958 — Розенблатт изобрел метод обучения для модели нейронов МакКаллока и Питтса по имени Перцептрон.

-

1960 — Бернард Уидроу и Марсиан Хофф разработали модели под названием «ADALINE» и «MADALINE».

1943 — Предполагается, что концепция нейронной сети началась с работы физиолога Уоррена МакКаллока и математика Уолтера Питтса, когда в 1943 году они смоделировали простую нейронную сеть с использованием электрических цепей, чтобы описать, как нейроны в мозге могут Работа.

1949 — в книге Дональда Хебба « Организация поведения» подчеркивается тот факт, что повторная активация одного нейрона другим увеличивает его силу при каждом использовании.

1956 — Тейлор ввел ассоциативную сеть памяти.

1958 — Розенблатт изобрел метод обучения для модели нейронов МакКаллока и Питтса по имени Перцептрон.

1960 — Бернард Уидроу и Марсиан Хофф разработали модели под названием «ADALINE» и «MADALINE».

ANN в 1960–1980-х годах

Некоторые ключевые события этой эпохи заключаются в следующем —

-

1961 — Розенблатт предпринял неудачную попытку, но предложил схему «обратного распространения» для многослойных сетей.

-

1964 — Тейлор построил схему «победитель получает все» с запретами среди выходных устройств.

-

1969 — Многослойный персептрон (MLP) был изобретен Минским и Папертом.

-

1971 — Кохонен разработал ассоциативную память.

-

1976 — Стивен Гроссберг и Гейл Карпентер разработали теорию адаптивного резонанса.

1961 — Розенблатт предпринял неудачную попытку, но предложил схему «обратного распространения» для многослойных сетей.

1964 — Тейлор построил схему «победитель получает все» с запретами среди выходных устройств.

1969 — Многослойный персептрон (MLP) был изобретен Минским и Папертом.

1971 — Кохонен разработал ассоциативную память.

1976 — Стивен Гроссберг и Гейл Карпентер разработали теорию адаптивного резонанса.

ИНН с 1980-х до настоящего времени

Некоторые ключевые события этой эпохи заключаются в следующем —

-

1982 — Основным событием стал энергетический подход Хопфилда.

-

1985 — машина Больцмана была разработана Экли, Хинтоном и Сейновским.

-

1986 — Rumelhart, Hinton и Williams представили обобщенное правило дельты.

-

1988 — Kosko разработал двоичную ассоциативную память (BAM), а также дал концепцию нечеткой логики в ANN.

1982 — Основным событием стал энергетический подход Хопфилда.

1985 — машина Больцмана была разработана Экли, Хинтоном и Сейновским.

1986 — Rumelhart, Hinton и Williams представили обобщенное правило дельты.

1988 — Kosko разработал двоичную ассоциативную память (BAM), а также дал концепцию нечеткой логики в ANN.

Исторический обзор показывает, что в этой области достигнут значительный прогресс. Появляются чипы на основе нейронных сетей и разрабатываются приложения для решения сложных задач. Конечно, сегодня это переходный период для технологии нейронных сетей.

Биологический Нейрон

Нервная клетка (нейрон) — это особая биологическая клетка, которая обрабатывает информацию. Согласно оценке, существует огромное количество нейронов, приблизительно 10 11 с многочисленными взаимосвязями, приблизительно 10 15 .

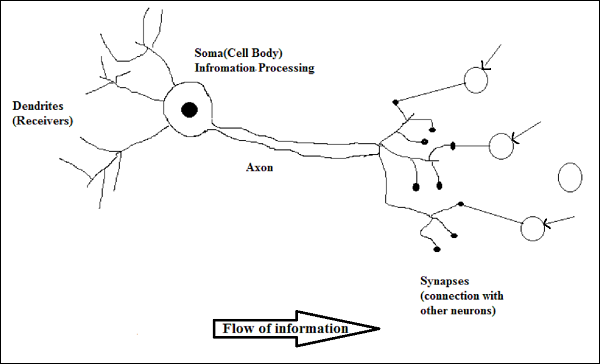

Принципиальная схема

Работа биологического нейрона

Как показано на диаграмме выше, типичный нейрон состоит из следующих четырех частей, с помощью которых мы можем объяснить его работу —

-

Дендриты — это древовидные ветви, отвечающие за получение информации от других нейронов, с которыми она связана. В другом смысле можно сказать, что они похожи на уши нейрона.

-

Сома — это клеточное тело нейрона и отвечает за обработку информации, которую они получили от дендритов.

-

Аксон — это как кабель, по которому нейроны посылают информацию.

-

Синапсы — это связь между аксоном и другими нейронными дендритами.

Дендриты — это древовидные ветви, отвечающие за получение информации от других нейронов, с которыми она связана. В другом смысле можно сказать, что они похожи на уши нейрона.

Сома — это клеточное тело нейрона и отвечает за обработку информации, которую они получили от дендритов.

Аксон — это как кабель, по которому нейроны посылают информацию.

Синапсы — это связь между аксоном и другими нейронными дендритами.

Энн против БНН

Прежде чем взглянуть на различия между искусственной нейронной сетью (ANN) и биологической нейронной сетью (BNN), давайте взглянем на сходства, основанные на терминологии между этими двумя.

| Биологическая Нейронная Сеть (BNN) | Искусственная нейронная сеть (ANN) |

|---|---|

| сома | Узел |

| Дендриты | вход |

| синапс | Веса или Соединения |

| аксон | Выход |

Следующая таблица показывает сравнение между ANN и BNN на основе некоторых упомянутых критериев.

| критерии | BNN | ЭНН |

|---|---|---|

| обработка | Массивно параллельный, медленный, но превосходящий ANN | Параллельно, быстро, но уступает BNN |

| Размер | 10 11 нейронов и 10 15 взаимосвязей | От 10 2 до 10 4 узлов (в основном зависит от типа приложения и сетевого дизайнера) |

| Учусь | Они могут терпеть двусмысленность | Очень точные, структурированные и отформатированные данные необходимы, чтобы терпеть неоднозначность |

| Отказоустойчивость | Производительность ухудшается даже с частичным повреждением | Он способен работать надежно, следовательно, может быть отказоустойчивым |

| Емкость накопителя | Хранит информацию в синапсе | Хранит информацию в постоянных ячейках памяти |

Модель искусственной нейронной сети

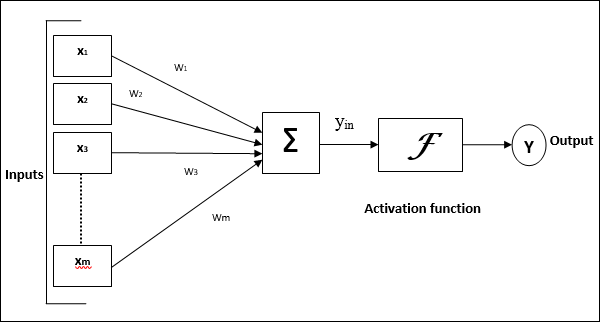

Следующая диаграмма представляет общую модель ANN с последующей ее обработкой.

Для приведенной выше общей модели искусственной нейронной сети чистый входной сигнал может быть рассчитан следующим образом:

у−в=X1.w1 +X2.w2 +X3.w3 dotsoxm.wm

то есть чистый вход yin= summixi.wi

Выход можно рассчитать, применив функцию активации к сетевому входу.

Y=F(yin)

Выход = функция (рассчитан чистый вход)