Эта сеть была разработана Стивеном Гроссбергом и Гейл Карпентер в 1987 году. Она основана на конкуренции и использует модель обучения без присмотра. Сети Адаптивной Резонансной Теории (ART), как следует из названия, всегда открыты для нового обучения (адаптивного) без потери старых паттернов (резонанса). По сути, сеть ART представляет собой векторный классификатор, который принимает входной вектор и классифицирует его в одну из категорий в зависимости от того, какой из сохраненных шаблонов он больше всего напоминает.

Операционный директор

Основную операцию классификации АРТ можно разделить на следующие этапы —

-

Этап распознавания — входной вектор сравнивается с классификацией, представленной в каждом узле выходного слоя. Выход нейрона становится «1», если он наилучшим образом соответствует применяемой классификации, в противном случае он становится «0».

-

Фаза сравнения. На этом этапе выполняется сравнение входного вектора с вектором слоя сравнения. Условием для сброса является то, что степень сходства будет меньше, чем параметр бдительности.

-

Фаза поиска — На этом этапе сеть будет искать сброс, а также соответствие, выполненное на вышеуказанных этапах. Следовательно, если бы не было сброса и совпадение было бы достаточно хорошим, то классификация окончена. В противном случае процесс будет повторен, и для сохранения правильного соответствия необходимо отправить другой сохраненный шаблон.

Этап распознавания — входной вектор сравнивается с классификацией, представленной в каждом узле выходного слоя. Выход нейрона становится «1», если он наилучшим образом соответствует применяемой классификации, в противном случае он становится «0».

Фаза сравнения. На этом этапе выполняется сравнение входного вектора с вектором слоя сравнения. Условием для сброса является то, что степень сходства будет меньше, чем параметр бдительности.

Фаза поиска — На этом этапе сеть будет искать сброс, а также соответствие, выполненное на вышеуказанных этапах. Следовательно, если бы не было сброса и совпадение было бы достаточно хорошим, то классификация окончена. В противном случае процесс будет повторен, и для сохранения правильного соответствия необходимо отправить другой сохраненный шаблон.

ART1

Это тип ART, который предназначен для кластеризации двоичных векторов. Мы можем понять это с архитектурой этого.

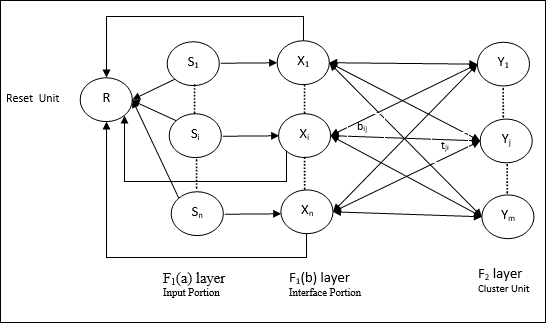

Архитектура ART1

Он состоит из следующих двух блоков —

Вычислительная единица — состоит из следующих элементов:

-

Блок ввода (слой F 1 ) — он также имеет следующие две части —

-

F 1 (a) layer (Input input) — В ART1 не будет обработки в этой части, вместо того, чтобы иметь только входные векторы. Он связан с уровнем F 1 (b) (интерфейсная часть).

-

Уровень F 1 (b) (интерфейсная часть) — эта часть объединяет сигнал от входной части с сигналом уровня F 2 . Слой F 1 (b) соединен со слоем F 2 через веса снизу вверх b ij, а слой F 2 соединен со слоем F 1 (b) через веса сверху вниз t ji .

-

-

Блок кластера (слой F 2 ) — это конкурентный уровень. Единица, имеющая наибольший сетевой вход, выбирается для изучения схемы ввода. Активация всех других узлов кластера установлена на 0.

-

Механизм сброса . Работа этого механизма основана на сходстве веса сверху вниз и вектора ввода. Теперь, если степень этого сходства меньше, чем параметр бдительности, кластеру не разрешается изучать шаблон, и отдых может произойти.

Блок ввода (слой F 1 ) — он также имеет следующие две части —

F 1 (a) layer (Input input) — В ART1 не будет обработки в этой части, вместо того, чтобы иметь только входные векторы. Он связан с уровнем F 1 (b) (интерфейсная часть).

Уровень F 1 (b) (интерфейсная часть) — эта часть объединяет сигнал от входной части с сигналом уровня F 2 . Слой F 1 (b) соединен со слоем F 2 через веса снизу вверх b ij, а слой F 2 соединен со слоем F 1 (b) через веса сверху вниз t ji .

Блок кластера (слой F 2 ) — это конкурентный уровень. Единица, имеющая наибольший сетевой вход, выбирается для изучения схемы ввода. Активация всех других узлов кластера установлена на 0.

Механизм сброса . Работа этого механизма основана на сходстве веса сверху вниз и вектора ввода. Теперь, если степень этого сходства меньше, чем параметр бдительности, кластеру не разрешается изучать шаблон, и отдых может произойти.

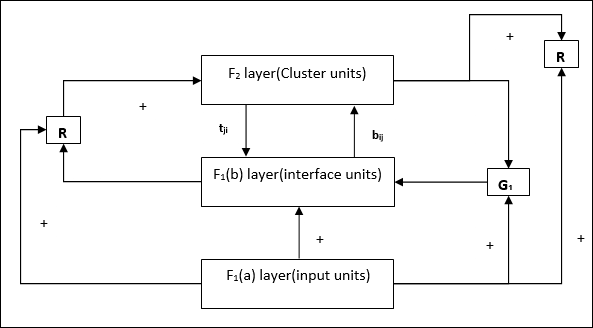

Модуль дополнения — На самом деле проблема с механизмом сброса заключается в том, что слой F 2 должен быть заблокирован при определенных условиях, а также должен быть доступен, когда происходит некоторое обучение. Вот почему два дополнительных блока, а именно, G 1 и G 2 , добавляются вместе с блоком сброса R. Они называются блоками управления усилением . Эти устройства принимают и отправляют сигналы другим устройствам, присутствующим в сети. «+» обозначает возбуждающий сигнал, а «-» обозначает запрещающий сигнал.

Используемые параметры

Используются следующие параметры:

-

n — количество компонентов во входном векторе

-

m — максимальное количество кластеров, которые могут быть сформированы

-

b ij — Вес от слоя F 1 (b) до слоя F 2 , т.е. веса снизу вверх

-

t ji — Вес от F 2 до F 1 (b) слоя, то есть веса сверху вниз

-

ρ — параметр бдительности

-

|| х || — норма вектора х

n — количество компонентов во входном векторе

m — максимальное количество кластеров, которые могут быть сформированы

b ij — Вес от слоя F 1 (b) до слоя F 2 , т.е. веса снизу вверх

t ji — Вес от F 2 до F 1 (b) слоя, то есть веса сверху вниз

ρ — параметр бдительности

|| х || — норма вектора х

Алгоритм

Шаг 1 — Инициализируйте скорость обучения, параметр бдительности и веса следующим образом:

альфа>1и0< Rho Leq1

0 \: <\: B_ {IJ} (0) \ <\: \ гидроразрыва {\ альфа} {\ альфа \: — \: 1 \ + \: п} \: \: и \: \: t_ {IJ} (0) \: = \: 1

Шаг 2 — Продолжайте шаг 3-9, когда условие остановки не соответствует действительности.

Шаг 3 — Продолжайте шаг 4-6 для каждого ввода тренировки.

Шаг 4 — Установите активацию всех единиц F 1 (a) и F 1 следующим образом

F 2 = 0 и F 1 (a) = входные векторы

Шаг 5 — Входной сигнал от слоя F 1 (a) до слоя F 1 (b) должен быть отправлен как

S_ {я} \: = \: x_ {я}

Шаг 6 — Для каждого запрещенного узла F 2

y_ {j} \: = \: \ sum_i b_ {ij} x_ {i} условие: y j ≠ -1

Шаг 7 — Выполните шаги 8-10, когда сброс является истинным.

Шаг 8 — Найти J для y J ≥ y j для всех узлов j

Шаг 9 — Снова вычислите активацию на F 1 (b) следующим образом

X_ {я} \: = \: sitJi

Шаг 10 — Теперь, после расчета нормы вектора x и вектора s , нам нужно проверить условие сброса следующим образом:

Если || x || / || s || <параметр бдительности ρ , затем запретить узел J и перейти к шагу 7

Иначе, если || x || / || s || ≥ параметр бдительности ρ , затем продолжайте.

Шаг 11 — Обновление веса для узла J может быть сделано следующим образом —

b_ {ij} (новый) \: = \: \ frac {\ alpha x_ {i}} {\ alpha \: — \: 1 \: + \: || x ||}

t_ {IJ} (новый) \: = \: x_ {я}

Шаг 12 — Условие остановки для алгоритма должно быть проверено, и оно может быть следующим: