Искусственная нейронная сеть — основные понятия

Нейронные сети представляют собой параллельные вычислительные устройства, что в основном является попыткой сделать компьютерную модель мозга. Основная цель — разработать систему для выполнения различных вычислительных задач быстрее, чем традиционные системы. Эти задачи включают распознавание и классификацию образов, аппроксимацию, оптимизацию и кластеризацию данных.

Что такое искусственная нейронная сеть?

Искусственная нейронная сеть (ANN) — эффективная вычислительная система, центральная тема которой заимствована из аналогии биологических нейронных сетей. ANN также называются «искусственными нейронными системами» или «параллельными распределенными системами обработки» или «системами соединения». ANN приобретает большой набор блоков, которые связаны по некоторому шаблону для обеспечения связи между блоками. Эти единицы, также называемые узлами или нейронами, являются простыми процессорами, которые работают параллельно.

Каждый нейрон связан с другим нейроном через канал связи. Каждая ссылка на соединение связана с весом, который имеет информацию о входном сигнале. Это наиболее полезная информация для нейронов для решения конкретной проблемы, потому что вес обычно возбуждает или подавляет передаваемый сигнал. Каждый нейрон имеет внутреннее состояние, которое называется сигналом активации. Выходные сигналы, которые вырабатываются после объединения входных сигналов и правила активации, могут отправляться на другие устройства.

Краткая история ANN

История ANN может быть разделена на следующие три эпохи —

ИНН в течение 1940-1960-х годов

Некоторые ключевые события этой эпохи заключаются в следующем —

-

1943 — Предполагается, что концепция нейронной сети началась с работы физиолога Уоррена МакКаллока и математика Уолтера Питтса, когда в 1943 году они смоделировали простую нейронную сеть с использованием электрических цепей, чтобы описать, как нейроны в мозге могут Работа.

-

1949 — в книге Дональда Хебба « Организация поведения» подчеркивается тот факт, что повторная активация одного нейрона другим увеличивает его силу при каждом использовании.

-

1956 — Тейлор ввел ассоциативную сеть памяти.

-

1958 — Розенблатт изобрел метод обучения для модели нейронов МакКаллока и Питтса по имени Перцептрон.

-

1960 — Бернард Уидроу и Марсиан Хофф разработали модели под названием «ADALINE» и «MADALINE».

1943 — Предполагается, что концепция нейронной сети началась с работы физиолога Уоррена МакКаллока и математика Уолтера Питтса, когда в 1943 году они смоделировали простую нейронную сеть с использованием электрических цепей, чтобы описать, как нейроны в мозге могут Работа.

1949 — в книге Дональда Хебба « Организация поведения» подчеркивается тот факт, что повторная активация одного нейрона другим увеличивает его силу при каждом использовании.

1956 — Тейлор ввел ассоциативную сеть памяти.

1958 — Розенблатт изобрел метод обучения для модели нейронов МакКаллока и Питтса по имени Перцептрон.

1960 — Бернард Уидроу и Марсиан Хофф разработали модели под названием «ADALINE» и «MADALINE».

ANN в 1960–1980-х годах

Некоторые ключевые события этой эпохи заключаются в следующем —

-

1961 — Розенблатт предпринял неудачную попытку, но предложил схему «обратного распространения» для многослойных сетей.

-

1964 — Тейлор построил схему «победитель получает все» с запретами среди выходных устройств.

-

1969 — Многослойный персептрон (MLP) был изобретен Минским и Папертом.

-

1971 — Кохонен разработал ассоциативную память.

-

1976 — Стивен Гроссберг и Гейл Карпентер разработали теорию адаптивного резонанса.

1961 — Розенблатт предпринял неудачную попытку, но предложил схему «обратного распространения» для многослойных сетей.

1964 — Тейлор построил схему «победитель получает все» с запретами среди выходных устройств.

1969 — Многослойный персептрон (MLP) был изобретен Минским и Папертом.

1971 — Кохонен разработал ассоциативную память.

1976 — Стивен Гроссберг и Гейл Карпентер разработали теорию адаптивного резонанса.

ИНН с 1980-х до настоящего времени

Некоторые ключевые события этой эпохи заключаются в следующем —

-

1982 — Основным событием стал энергетический подход Хопфилда.

-

1985 — машина Больцмана была разработана Экли, Хинтоном и Сейновским.

-

1986 — Rumelhart, Hinton и Williams представили обобщенное правило дельты.

-

1988 — Kosko разработал двоичную ассоциативную память (BAM), а также дал концепцию нечеткой логики в ANN.

1982 — Основным событием стал энергетический подход Хопфилда.

1985 — машина Больцмана была разработана Экли, Хинтоном и Сейновским.

1986 — Rumelhart, Hinton и Williams представили обобщенное правило дельты.

1988 — Kosko разработал двоичную ассоциативную память (BAM), а также дал концепцию нечеткой логики в ANN.

Исторический обзор показывает, что в этой области достигнут значительный прогресс. Появляются чипы на основе нейронных сетей и разрабатываются приложения для решения сложных задач. Конечно, сегодня это переходный период для технологии нейронных сетей.

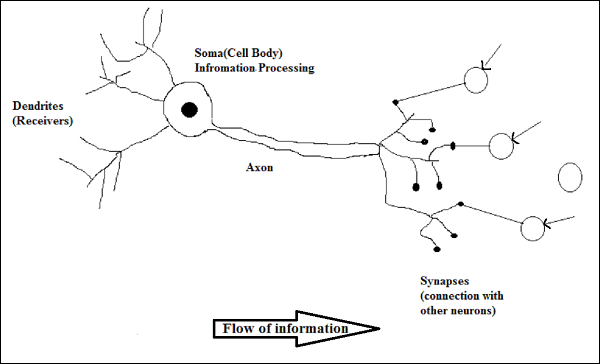

Биологический Нейрон

Нервная клетка (нейрон) — это особая биологическая клетка, которая обрабатывает информацию. Согласно оценке, существует огромное количество нейронов, приблизительно 10 11 с многочисленными взаимосвязями, приблизительно 10 15 .

Принципиальная схема

Работа биологического нейрона

Как показано на диаграмме выше, типичный нейрон состоит из следующих четырех частей, с помощью которых мы можем объяснить его работу —

-

Дендриты — это древовидные ветви, отвечающие за получение информации от других нейронов, с которыми она связана. В другом смысле можно сказать, что они похожи на уши нейрона.

-

Сома — это клеточное тело нейрона и отвечает за обработку информации, которую они получили от дендритов.

-

Аксон — это как кабель, по которому нейроны посылают информацию.

-

Синапсы — это связь между аксоном и другими нейронными дендритами.

Дендриты — это древовидные ветви, отвечающие за получение информации от других нейронов, с которыми она связана. В другом смысле можно сказать, что они похожи на уши нейрона.

Сома — это клеточное тело нейрона и отвечает за обработку информации, которую они получили от дендритов.

Аксон — это как кабель, по которому нейроны посылают информацию.

Синапсы — это связь между аксоном и другими нейронными дендритами.

Энн против БНН

Прежде чем взглянуть на различия между искусственной нейронной сетью (ANN) и биологической нейронной сетью (BNN), давайте взглянем на сходства, основанные на терминологии между этими двумя.

| Биологическая Нейронная Сеть (BNN) | Искусственная нейронная сеть (ANN) |

|---|---|

| сома | Узел |

| Дендриты | вход |

| синапс | Веса или Соединения |

| аксон | Выход |

Следующая таблица показывает сравнение между ANN и BNN на основе некоторых упомянутых критериев.

| критерии | BNN | ЭНН |

|---|---|---|

| обработка | Массивно параллельный, медленный, но превосходящий ANN | Параллельно, быстро, но уступает BNN |

| Размер | 10 11 нейронов и 10 15 взаимосвязей | От 10 2 до 10 4 узлов (в основном зависит от типа приложения и сетевого дизайнера) |

| Учусь | Они могут терпеть двусмысленность | Очень точные, структурированные и отформатированные данные необходимы, чтобы терпеть неоднозначность |

| Отказоустойчивость | Производительность ухудшается даже с частичным повреждением | Он способен работать надежно, следовательно, может быть отказоустойчивым |

| Емкость накопителя | Хранит информацию в синапсе | Хранит информацию в постоянных ячейках памяти |

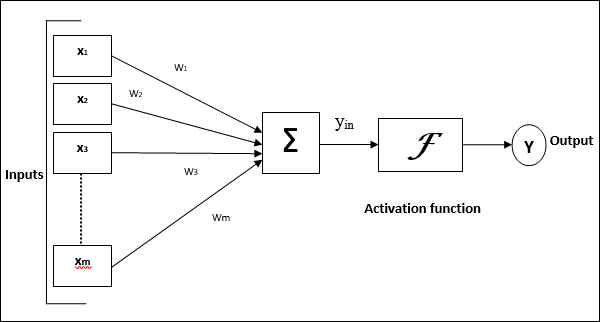

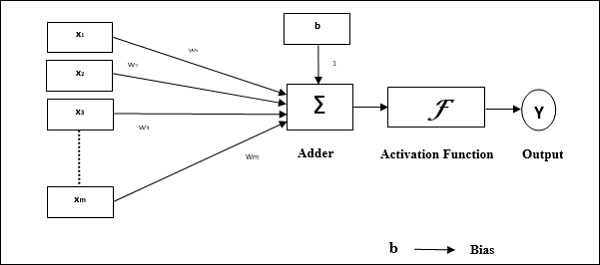

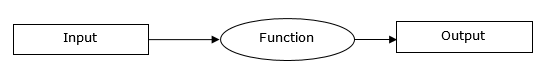

Модель искусственной нейронной сети

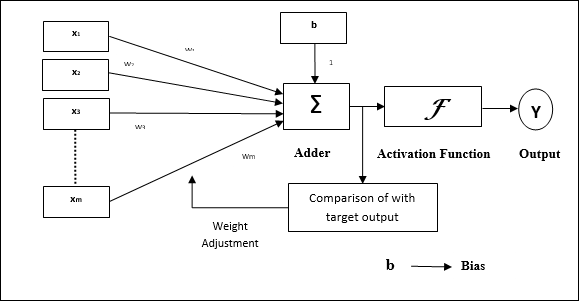

Следующая диаграмма представляет общую модель ANN с последующей ее обработкой.

Для приведенной выше общей модели искусственной нейронной сети чистый входной сигнал может быть рассчитан следующим образом:

у−в=X1.w1 +X2.w2 +X3.w3 dotsoxm.wm

то есть чистый вход yin= summixi.wi

Выход можно рассчитать, применив функцию активации к сетевому входу.

Y=F(yin)

Выход = функция (рассчитан чистый вход)

Искусственная Нейронная Сеть — Строительные Блоки

Обработка ANN зависит от следующих трех строительных блоков —

- Топология сети

- Корректировки веса или обучения

- Функции активации

В этой главе мы подробно обсудим эти три строительных блока ANN.

Топология сети

Топология сети — это расположение сети вместе с ее узлами и соединительными линиями. По топологии ИНС можно классифицировать по следующим видам:

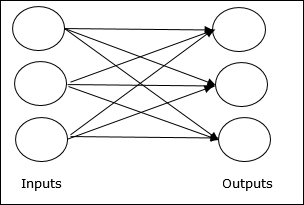

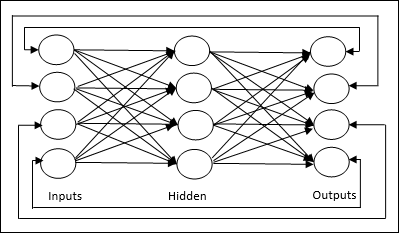

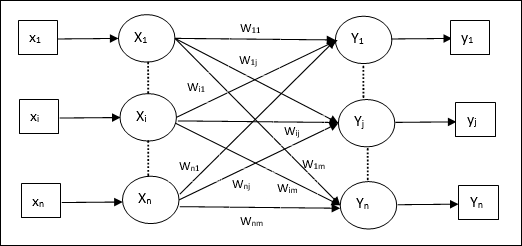

Сеть прямой связи

Это непериодическая сеть, имеющая блоки обработки / узлы в слоях, и все узлы в слое связаны с узлами предыдущих уровней. Соединение имеет различный вес на них. Отсутствие обратной связи означает, что сигнал может течь только в одном направлении, от входа к выходу. Это может быть разделено на следующие два типа —

-

Однослойная сеть с прямой связью — концепция ANN с прямой связью, имеющая только один взвешенный слой. Другими словами, мы можем сказать, что входной слой полностью связан с выходным слоем.

Однослойная сеть с прямой связью — концепция ANN с прямой связью, имеющая только один взвешенный слой. Другими словами, мы можем сказать, что входной слой полностью связан с выходным слоем.

-

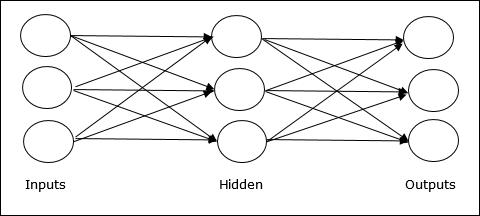

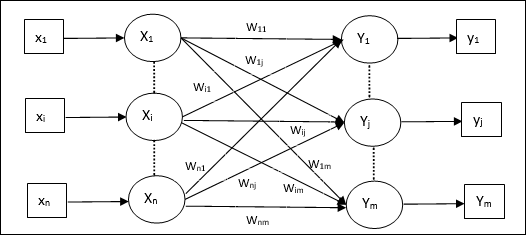

Многослойная сеть с прямой связью — концепция ANN с прямой связью, имеющая более одного взвешенного слоя. Поскольку эта сеть имеет один или несколько слоев между входным и выходным слоями, она называется скрытыми слоями.

Многослойная сеть с прямой связью — концепция ANN с прямой связью, имеющая более одного взвешенного слоя. Поскольку эта сеть имеет один или несколько слоев между входным и выходным слоями, она называется скрытыми слоями.

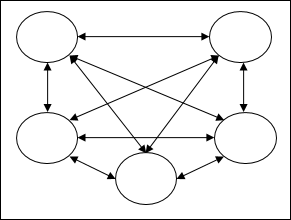

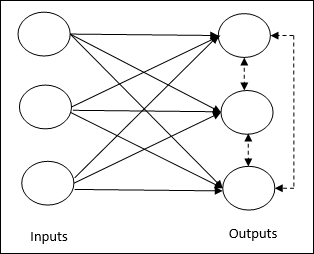

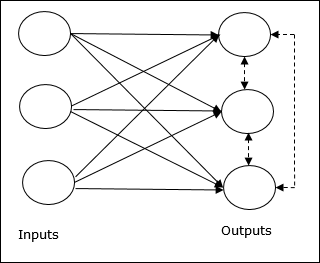

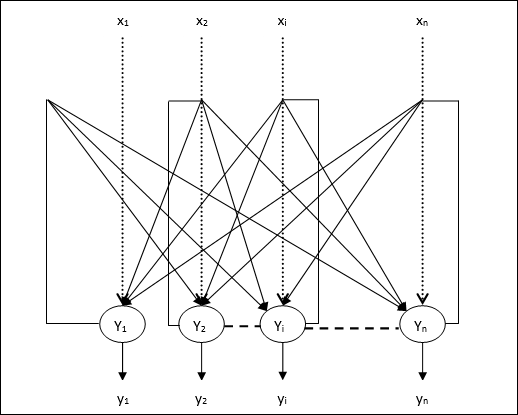

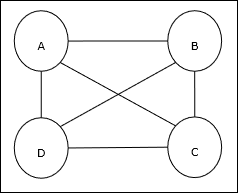

Сеть обратной связи

Как следует из названия, сеть обратной связи имеет пути обратной связи, что означает, что сигнал может проходить в обоих направлениях с использованием петель. Это делает ее нелинейной динамической системой, которая непрерывно изменяется, пока не достигнет состояния равновесия. Это может быть разделено на следующие типы —

-

Рекуррентные сети — это сети обратной связи с замкнутыми контурами. Ниже приведены два типа рекуррентных сетей.

-

Полностью рекуррентная сеть — это самая простая архитектура нейронной сети, поскольку все узлы подключены ко всем остальным узлам, и каждый узел работает как на входе, так и на выходе.

Рекуррентные сети — это сети обратной связи с замкнутыми контурами. Ниже приведены два типа рекуррентных сетей.

Полностью рекуррентная сеть — это самая простая архитектура нейронной сети, поскольку все узлы подключены ко всем остальным узлам, и каждый узел работает как на входе, так и на выходе.

-

Иорданская сеть — это сеть с обратной связью, в которой выход снова поступит на вход в качестве обратной связи, как показано на следующей диаграмме.

Иорданская сеть — это сеть с обратной связью, в которой выход снова поступит на вход в качестве обратной связи, как показано на следующей диаграмме.

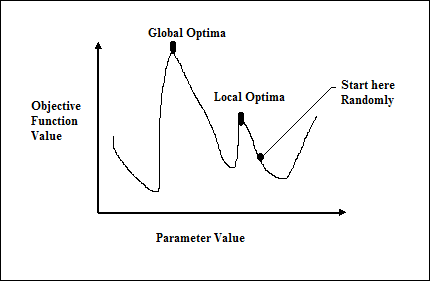

Корректировки веса или обучения

Обучение в искусственной нейронной сети — это метод изменения весов связей между нейронами указанной сети. Обучение в ANN можно разделить на три категории, а именно обучение под наблюдением, обучение без учителя и обучение с подкреплением.

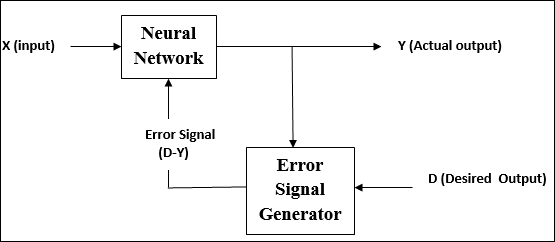

Контролируемое обучение

Как следует из названия, этот тип обучения осуществляется под наблюдением учителя. Этот процесс обучения является зависимым.

Во время обучения ANN при контролируемом обучении входной вектор представляется в сеть, которая дает выходной вектор. Этот выходной вектор сравнивается с желаемым выходным вектором. Сигнал ошибки генерируется, если есть разница между фактическим выходным сигналом и требуемым выходным вектором. На основе этого сигнала ошибки веса корректируются до тех пор, пока фактический выходной сигнал не будет сопоставлен с желаемым выходным значением.

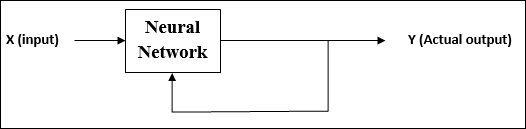

Обучение без учителя

Как следует из названия, этот тип обучения осуществляется без присмотра учителя. Этот процесс обучения является независимым.

Во время обучения ANN при обучении без учителя входные векторы аналогичного типа объединяются в кластеры. Когда применяется новый шаблон ввода, то нейронная сеть выдает ответ с указанием класса, к которому принадлежит шаблон ввода.

От среды нет обратной связи относительно того, каким должен быть желаемый результат и является ли он правильным или неправильным. Следовательно, в этом типе обучения сама сеть должна обнаруживать шаблоны и особенности из входных данных и отношения для входных данных по выходным данным.

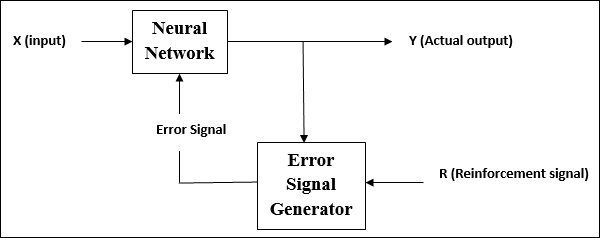

Усиление обучения

Как следует из названия, этот тип обучения используется для усиления или укрепления сети за счет некоторой критической информации. Этот процесс обучения похож на контролируемое обучение, однако у нас может быть очень мало информации.

Во время обучения сети под обучением подкрепления, сеть получает некоторую обратную связь от окружающей среды. Это делает его чем-то похожим на контролируемое обучение. Однако полученная здесь обратная связь носит оценочный, а не поучительный характер, что означает, что учителя, как в контролируемом обучении, нет. После получения обратной связи сеть выполняет корректировку весов, чтобы в будущем получать более качественную информацию о критике.

Функции активации

Это может быть определено как дополнительная сила или усилие, приложенное к входу, чтобы получить точный результат. В ANN мы также можем применять функции активации для ввода, чтобы получить точный вывод. Ниже приведены некоторые интересные функции активации —

Функция линейной активации

Она также называется функцией идентификации, поскольку она не выполняет редактирование ввода. Это может быть определено как —

F(х)=х

Функция активации сигмовидной кишки

Это имеет два типа следующим образом —

-

Двоичная сигмоидальная функция — эта функция активации выполняет редактирование ввода между 0 и 1. Она имеет положительный характер. Он всегда ограничен, что означает, что его выход не может быть меньше 0 и больше 1. Он также строго увеличивается по своей природе, что означает, что чем больше вход, тем больше будет выход. Это можно определить как

Р(х)=Сигм(х)= гидроразрыва11 +ехр(−x)

-

Биполярная сигмоидальная функция — эта функция активации выполняет редактирование ввода между -1 и 1. Она может быть положительной или отрицательной по своей природе. Он всегда ограничен, что означает, что его выход не может быть меньше -1 и больше 1. Он также строго увеличивается в природе, как сигмовидная функция. Это можно определить как

Р(х)=Сигм(х)= гидроразрыва21 +ехр(−x)−1= гидроразрыва1−ехр(х)1 +ехр(х)

Двоичная сигмоидальная функция — эта функция активации выполняет редактирование ввода между 0 и 1. Она имеет положительный характер. Он всегда ограничен, что означает, что его выход не может быть меньше 0 и больше 1. Он также строго увеличивается по своей природе, что означает, что чем больше вход, тем больше будет выход. Это можно определить как

Р(х)=Сигм(х)= гидроразрыва11 +ехр(−x)

Биполярная сигмоидальная функция — эта функция активации выполняет редактирование ввода между -1 и 1. Она может быть положительной или отрицательной по своей природе. Он всегда ограничен, что означает, что его выход не может быть меньше -1 и больше 1. Он также строго увеличивается в природе, как сигмовидная функция. Это можно определить как

Р(х)=Сигм(х)= гидроразрыва21 +ехр(−x)−1= гидроразрыва1−ехр(х)1 +ехр(х)

Обучение и адаптация

Как указывалось ранее, ANN полностью вдохновлен тем, как работает биологическая нервная система, т.е. мозг человека. Самая впечатляющая характеристика человеческого мозга — учиться, поэтому ANN приобретает такую же особенность.

Что такое обучение в ANN?

По сути, обучение означает делать и адаптировать изменения в себе по мере изменения среды. ИНС — это сложная система, или, точнее, мы можем сказать, что это сложная адаптивная система, которая может изменять свою внутреннюю структуру на основе информации, проходящей через нее.

Почему это важно?

Будучи сложной адаптивной системой, обучение в ANN подразумевает, что блок обработки способен изменять свое поведение ввода / вывода из-за изменения среды. Важность обучения в ИНС возрастает из-за фиксированной функции активации, а также вектора ввода / вывода, когда создается конкретная сеть. Теперь, чтобы изменить поведение ввода / вывода, нам нужно отрегулировать веса.

классификация

Это может быть определено как процесс обучения различению данных образцов на разные классы путем нахождения общих черт между образцами одного и того же класса. Например, для обучения ANN у нас есть несколько обучающих образцов с уникальными функциями, а для его тестирования у нас есть несколько тестовых образцов с другими уникальными функциями. Классификация является примером контролируемого обучения.

Правила обучения нейронной сети

Мы знаем, что во время обучения ANN, чтобы изменить поведение ввода / вывода, нам нужно отрегулировать веса. Следовательно, требуется метод, с помощью которого веса могут быть изменены. Эти методы называются правилами обучения, которые являются просто алгоритмами или уравнениями. Ниже приведены некоторые правила обучения для нейронной сети.

Правило изучения иврита

Это правило, одно из старейших и самых простых, было введено Дональдом Хеббом в его книге «Организация поведения» в 1949 году. Это своего рода прямое, неконтролируемое обучение.

Основная концепция — это правило основано на предложении Хебба, который написал:

«Когда аксон клетки A находится достаточно близко, чтобы возбудить клетку B, и многократно или постоянно принимает участие в ее сжигании, в одной или обеих клетках происходит некоторый процесс роста или метаболические изменения, так что A эффективно, как одна из клеток, запускающих B , увеличена.»

Из приведенного выше постулата мы можем сделать вывод, что связи между двумя нейронами могут быть усилены, если нейроны срабатывают одновременно, и могут ослабнуть, если они срабатывают в разное время.

Математическая формулировка. Согласно правилу обучения Хевбия, следующая формула увеличивает вес соединения на каждом временном шаге.

Deltawji(t)= alphaxi(t).yj(t)

Здесь Deltawji(t) = приращение, на которое увеличивается вес соединения на шаге времени t

alpha = положительная и постоянная скорость обучения

xi(t) = входное значение пресинаптического нейрона на временном шаге t

yi(t) = выход пресинаптического нейрона на шаге времени t

Правило обучения Перцептрона

Это правило является ошибкой исправления контролируемого алгоритма обучения однослойных сетей с прямой связью с линейной функцией активации, представленного Розенблаттом.

Базовая концепция. Будучи контролируемой по своей природе, для расчета ошибки будет проводиться сравнение между желаемым / целевым выходом и фактическим выходом. Если обнаруживается какая-либо разница, необходимо изменить вес соединения.

Математическая формулировка. Чтобы объяснить математическую формулировку, предположим, что у нас есть «n» число конечных входных векторов, x (n), вместе с его желаемым / целевым выходным вектором t (n), где от n = 1 до N.

Теперь выходной сигнал ‘y’ может быть рассчитан, как объяснено ранее, на основе чистого ввода, а функция активации, применяемая к этому сетевому вводу, может быть выражена следующим образом:

y \: = \: f (y_ {in}) \: = \: \ begin {case} 1, & y_ {in} \:> \: \ theta \\ 0, & y_ {in} \: \ leqslant \: \ Theta \ конец {случаи}

Где θ — порог.

Обновление веса может быть сделано в следующих двух случаях —

Случай I — когда ты , то

ш(новый)=W(старый) +ТХ

Случай II — когда t = y , то

Без изменений в весе

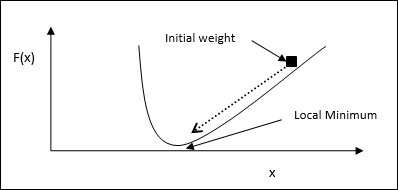

Delta Learning Rule (правило Уидроу-Хоффа)

Он введен Бернардом Уидроу и Марсианом Хоффом, также называемым методом наименьшего среднего квадрата (LMS), чтобы минимизировать ошибку во всех шаблонах обучения. Это своего рода контролируемый алгоритм обучения с функцией непрерывной активации.

Основная концепция . Основой этого правила является подход с градиентным спуском, который продолжается вечно. Дельта-правило обновляет синаптические веса, чтобы минимизировать чистый входной сигнал для выходной единицы и целевого значения.

Математическая формулировка — Чтобы обновить синаптические веса, дельта-правило задается

Deltawi= alpha :.xi.ej

Здесь Deltawi = изменение веса для i- го шаблона;

alpha = положительная и постоянная скорость обучения;

xi = входное значение от пресинаптического нейрона;

ej = (t−yin), разница между желаемым / целевым выходом и фактическим выходом y yin

Вышеуказанное дельта-правило относится только к одному выходному устройству.

Обновление веса может быть сделано в следующих двух случаях —

Случай I — когда ты , то

w(новый)=w(старый)+ Deltaw

Случай II — когда t = y , то

Без изменений в весе

Конкурентное правило обучения (победитель получает все)

Он связан с обучением без присмотра, при котором выходные узлы пытаются конкурировать друг с другом, чтобы представить шаблон ввода. Чтобы понять это правило обучения, мы должны понимать конкурентную сеть, которая представлена следующим образом:

Основная концепция конкурентной сети. Эта сеть похожа на однослойную сеть с прямой связью с обратной связью между выходами. Соединения между выходами имеют запретительный тип, показанный пунктирными линиями, что означает, что конкуренты никогда не поддерживают себя.

Основная концепция правила конкурентного обучения. Как было сказано ранее, между узлами вывода будет конкуренция. Следовательно, основная концепция заключается в том, что во время обучения выходной блок с наивысшей активацией для данного шаблона ввода будет объявлен победителем. Это правило также называется Победитель получает все, потому что обновляется только выигрышный нейрон, а остальные нейроны остаются без изменений.

Математическая формулировка — Ниже приведены три важных фактора для математической формулировки этого правила обучения —

-

Условие быть победителем — Предположим, что если нейрон yk хочет быть победителем, то будет выполнено следующее условие:

y_ {k} \: = \: \ begin {case} 1 & if \: v_ {k} \:> \: v_ {j} \: для \: все \: j, \: j \: \ neq \: k \\ 0 & в противном случае \ end {case}

Условие быть победителем — Предположим, что если нейрон yk хочет быть победителем, то будет выполнено следующее условие:

y_ {k} \: = \: \ begin {case} 1 & if \: v_ {k} \:> \: v_ {j} \: для \: все \: j, \: j \: \ neq \: k \\ 0 & в противном случае \ end {case}

Это означает, что если какой-либо нейрон, скажем, yk wants, хочет победить, то его индуцированное локальное поле (вывод единицы суммирования), скажем, vk, должно быть наибольшим среди всех других нейронов. в сети.

-

Условие суммирования общего веса. Другое ограничение по правилу конкурентного обучения состоит в том, что сумма весов для конкретного выходного нейрона будет равна 1. Например, если мы рассмотрим нейрон k, то —

displaystyle сумма limitsJwкдж=1длявсеK

Условие суммирования общего веса. Другое ограничение по правилу конкурентного обучения состоит в том, что сумма весов для конкретного выходного нейрона будет равна 1. Например, если мы рассмотрим нейрон k, то —

displaystyle сумма limitsJwкдж=1длявсеK

-

Изменение веса для победителя — если нейрон не реагирует на шаблон ввода, то обучение в этом нейроне не происходит. Однако, если конкретный нейрон выигрывает, то соответствующие веса корректируются следующим образом

\ Delta w_ {kj} \: = \: \ begin {case} — \ alpha (x_ {j} \: — \: w_ {kj}), & if \: нейрон \: k \: wins \\ 0, и если \: нейрон \: k \: убытки \ конец {случаи}

Изменение веса для победителя — если нейрон не реагирует на шаблон ввода, то обучение в этом нейроне не происходит. Однако, если конкретный нейрон выигрывает, то соответствующие веса корректируются следующим образом

\ Delta w_ {kj} \: = \: \ begin {case} — \ alpha (x_ {j} \: — \: w_ {kj}), & if \: нейрон \: k \: wins \\ 0, и если \: нейрон \: k \: убытки \ конец {случаи}

Здесь alpha — скорость обучения.

Это ясно показывает, что мы отдаем предпочтение выигрышному нейрону, регулируя его вес, и если происходит потеря нейрона, нам не нужно беспокоиться о том, чтобы заново отрегулировать его вес.

Внешнее Правило Обучения

Это правило, введенное Гроссбергом, касается контролируемого обучения, потому что желаемые результаты известны. Это также называется обучением Гроссберга.

Основная концепция — это правило применяется к нейронам, расположенным в слое. Он специально разработан для получения желаемого выхода d слоя p нейронов.

Математическая формулировка — поправки веса в этом правиле рассчитываются следующим образом

Deltawj= alpha :(d−wj)

Здесь d — желаемый выход нейрона, а alpha — скорость обучения.

Контролируемое обучение

Как следует из названия, контролируемое обучение происходит под наблюдением учителя. Этот процесс обучения является зависимым. Во время обучения ANN при контролируемом обучении входной вектор представляется в сеть, которая создает выходной вектор. Этот выходной вектор сравнивается с желаемым / целевым выходным вектором. Сигнал ошибки генерируется, если существует разница между фактическим выходным сигналом и вектором требуемого / целевого выходного сигнала. На основе этого сигнала ошибки веса будут корректироваться до тех пор, пока фактический выходной сигнал не будет сопоставлен с желаемым выходным значением.

Perceptron

Разработанный Фрэнком Розенблаттом с использованием модели МакКаллоха и Питтса, персептрон является основной операционной единицей искусственных нейронных сетей. Он использует контролируемое правило обучения и может классифицировать данные на два класса.

Эксплуатационные характеристики персептрона: он состоит из одного нейрона с произвольным числом входов и регулируемыми весами, но выход нейрона равен 1 или 0 в зависимости от порога. Он также состоит из смещения, вес которого всегда равен 1. Следующий рисунок дает схематическое представление персептрона.

Перцептрон, таким образом, имеет следующие три основных элемента —

-

Ссылки — это будет набор ссылок для соединения, который имеет вес, включая смещение, всегда имеющее вес 1.

-

Сумматор — добавляет данные после умножения их на соответствующие веса.

-

Функция активации — ограничивает выход нейрона. Самая основная функция активации — это пошаговая функция Хевисайда, имеющая два возможных выхода. Эта функция возвращает 1, если вход положительный, и 0 для любого отрицательного входа.

Ссылки — это будет набор ссылок для соединения, который имеет вес, включая смещение, всегда имеющее вес 1.

Сумматор — добавляет данные после умножения их на соответствующие веса.

Функция активации — ограничивает выход нейрона. Самая основная функция активации — это пошаговая функция Хевисайда, имеющая два возможных выхода. Эта функция возвращает 1, если вход положительный, и 0 для любого отрицательного входа.

Алгоритм обучения

Сеть Perceptron может быть обучена как для одного устройства вывода, так и для нескольких устройств вывода.

Алгоритм обучения для одного блока вывода

Шаг 1 — Инициализируйте следующее, чтобы начать тренировку —

- Веса

- предвзятость

- Скорость обучения alpha

Для простоты расчета и простоты веса и смещения должны быть установлены равными 0, а скорость обучения должна быть установлена равной 1.

Шаг 2 — Продолжайте шаг 3-8, если условие остановки не соответствует действительности.

Шаг 3 — Продолжайте шаг 4-6 для каждого вектора тренировки x .

Шаг 4 — Активируйте каждый блок ввода следующим образом —

Xя=Sя :(я=1кп)

Шаг 5 — Теперь получите чистый вход со следующим соотношением —

yin=b+ displaystyle sum limitnixi.wi

Здесь «b» — это смещение, а «n» — общее количество входных нейронов.

Шаг 6 — Примените следующую функцию активации для получения окончательного результата.

f (y_ {in}) \: = \: \ begin {case} 1 & if \: y_ {in} \:> \: \ theta \\ 0 & if \: — \ theta \: \ leqslant \ : y_ {in} \: \ leqslant \: \ theta \\ — 1 & if \: y_ {in} \: <\: — \ theta \ end {case}

Шаг 7 — Отрегулируйте вес и уклон следующим образом —

Случай 1 — если у, то

wя(новый)=wя(старый) + альфаtxя

b(новый)=b(старый)+ alphat

Случай 2 — если у = т, то

wя(новый)=wя(старый)

б(новый)=Ь(старый)

Здесь «y» — фактический выход, а «t» — желаемый / целевой выход.

Шаг 8 — Проверьте состояние остановки, которое может произойти, если нет изменения веса.

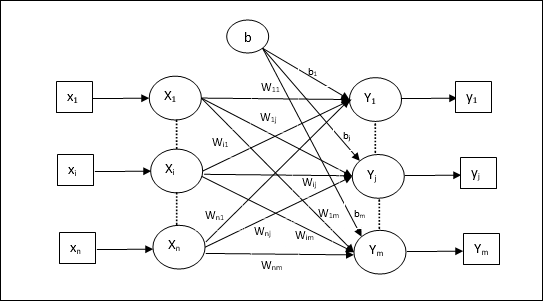

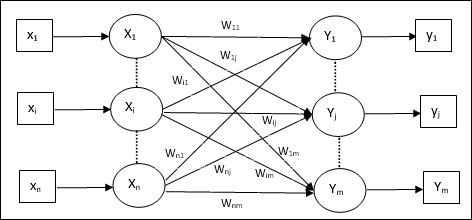

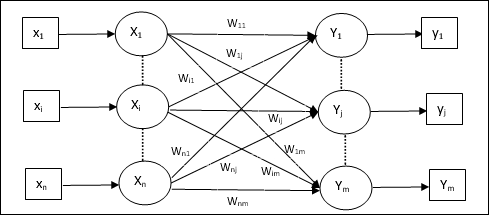

Алгоритм обучения для нескольких выходных единиц

Следующая диаграмма — архитектура персептрона для нескольких выходных классов.

Шаг 1 — Инициализируйте следующее, чтобы начать тренировку —

- Веса

- предвзятость

- Скорость обучения alpha

Для простоты расчета и простоты веса и смещения должны быть установлены равными 0, а скорость обучения должна быть установлена равной 1.

Шаг 2 — Продолжайте шаг 3-8, если условие остановки не соответствует действительности.

Шаг 3 — Продолжайте шаг 4-6 для каждого вектора тренировки x .

Шаг 4 — Активируйте каждый блок ввода следующим образом —

Xя=Sя :(я=1кп)

Шаг 5 — Получить чистый вход со следующим соотношением —

yin=b+ displaystyle sum limitnixiwij

Здесь «b» — это смещение, а «n» — общее количество входных нейронов.

Шаг 6 — Примените следующую функцию активации, чтобы получить окончательный результат для каждого блока вывода от j = 1 до m —

f (y_ {in}) \: = \: \ begin {case} 1 & if \: y_ {inj} \:> \: \ theta \\ 0 & if \: — \ theta \: \ leqslant \ : y_ {inj} \: \ leqslant \: \ theta \\ — 1 & if \: y_ {inj} \: <\: — \ theta \ end {case}

Шаг 7 — Отрегулируйте вес и смещение для x = 1 до n и j = 1 до m следующим образом —

Случай 1 — если y j ≠ t j, то

wIJ(новый)=wIJ(старый) + альфаtjXя

bj(новый)=bj(старый)+ alphatj

Случай 2 — если y j = t j, то

wIJ(новый)=wIJ(старый)

bJ(новый)=bJ(старый)

Здесь «y» — фактический выход, а «t» — желаемый / целевой выход.

Шаг 8 — Проверьте состояние остановки, которое произойдет, если нет изменения веса.

Адаптивный линейный нейрон (адалин)

Adaline, что означает адаптивный линейный нейрон, представляет собой сеть, имеющую одну линейную единицу. Он был разработан Видроу и Хоффом в 1960 году. Некоторые важные моменты об Адалине заключаются в следующем:

-

Используется функция биполярной активации.

-

Он использует дельта-правило для обучения, чтобы минимизировать среднеквадратичную ошибку (MSE) между фактическим выходом и желаемым / целевым выходом.

-

Веса и уклон регулируются.

Используется функция биполярной активации.

Он использует дельта-правило для обучения, чтобы минимизировать среднеквадратичную ошибку (MSE) между фактическим выходом и желаемым / целевым выходом.

Веса и уклон регулируются.

Архитектура

Базовая структура Adaline аналогична персептрону, имеющему дополнительную петлю обратной связи, с помощью которой фактический выход сравнивается с желаемым / целевым выходом. После сравнения на основе алгоритма обучения веса и смещения будут обновлены.

Алгоритм обучения

Шаг 1 — Инициализируйте следующее, чтобы начать тренировку —

- Веса

- предвзятость

- Скорость обучения alpha

Для простоты расчета и простоты веса и смещения должны быть установлены равными 0, а скорость обучения должна быть установлена равной 1.

Шаг 2 — Продолжайте шаг 3-8, если условие остановки не соответствует действительности.

Шаг 3 — Продолжайте шаг 4-6 для каждой биполярной тренировочной пары s: t .

Шаг 4 — Активируйте каждый блок ввода следующим образом —

Xя=Sя :(я=1кп)

Шаг 5 — Получить чистый вход со следующим соотношением —

yin=b+ displaystyle sum limitnixiwi

Здесь «b» — это смещение, а «n» — общее количество входных нейронов.

Шаг 6 — Примените следующую функцию активации для получения окончательного результата —

f (y_ {in}) \: = \: \ begin {case} 1 & if \: y_ {in} \: \ geqslant \: 0 \\ — 1 & if \: y_ {in} \: < \: 0 \ end {case}

Шаг 7 — Отрегулируйте вес и уклон следующим образом —

Случай 1 — если у, то

wi(новый)=wi(старый)+ alpha(t−yin)xi

b(новый)=b(старый)+ alpha(t−yin)

Случай 2 — если у = т, то

wя(новый)=wя(старый)

б(новый)=Ь(старый)

Здесь «y» — фактический выход, а «t» — желаемый / целевой выход.

(t−yin) — это вычисленная ошибка.

Шаг 8 — Проверка состояния остановки, которое произойдет, когда нет изменений в весе или когда наибольшее изменение веса произошло во время тренировки, меньше указанного допуска.

Множественный адаптивный линейный нейрон (Madaline)

Madaline, что означает Multiple Adaptive Linear Neuron, представляет собой сеть, которая состоит из множества Adalines параллельно. У него будет один выходной блок. Вот некоторые важные моменты, касающиеся Мадалины:

-

Это похоже на многослойный персептрон, где Adaline будет действовать как скрытая единица между входом и слоем Madaline.

-

Веса и смещение между входным и адалиновым слоями, как мы видим в архитектуре Adaline, являются регулируемыми.

-

Слои Adaline и Madaline имеют фиксированные веса и смещения 1.

-

Обучение можно проводить с помощью правила Delta.

Это похоже на многослойный персептрон, где Adaline будет действовать как скрытая единица между входом и слоем Madaline.

Веса и смещение между входным и адалиновым слоями, как мы видим в архитектуре Adaline, являются регулируемыми.

Слои Adaline и Madaline имеют фиксированные веса и смещения 1.

Обучение можно проводить с помощью правила Delta.

Архитектура

Архитектура Madaline состоит из «n» нейронов входного слоя, «m» нейронов уровня Adaline и 1 нейрона слоя Madaline. Слой Adaline можно рассматривать как скрытый слой, поскольку он находится между входным слоем и выходным слоем, то есть слоем Madaline.

Алгоритм обучения

К настоящему времени мы знаем, что должны регулироваться только веса и смещения между входным слоем и слоем Adaline, а веса и смещения между слоем Adaline и Madaline являются фиксированными.

Шаг 1 — Инициализируйте следующее, чтобы начать тренировку —

- Веса

- предвзятость

- Скорость обучения alpha

Для простоты расчета и простоты веса и смещения должны быть установлены равными 0, а скорость обучения должна быть установлена равной 1.

Шаг 2 — Продолжайте шаг 3-8, если условие остановки не соответствует действительности.

Шаг 3 — Продолжайте шаг 4-6 для каждой биполярной тренировочной пары s: t .

Шаг 4 — Активируйте каждый блок ввода следующим образом —

Xя=Sя :(я=1кп)

Шаг 5 — Получить чистую входную информацию на каждом скрытом слое, т.е. слое Adaline со следующим соотношением —

Qinj=bj+ displaystyle sum limitnixiwijj=1км

Здесь «b» — это смещение, а «n» — общее количество входных нейронов.

Шаг 6 — Примените следующую функцию активации, чтобы получить окончательный результат на уровне Adaline и Madaline —

$$ f (x) \: = \: \ begin {case} 1 & if \: x \: \ geqslant \: 0 \\ — 1 & if \: x \: <\: 0 \ end {case} $ $

Выход на скрытый (Adaline) блок

QJ=F(Qинъек)

Конечный вывод сети

у=F(у−в)

то есть yinj=b0+ summj=1Qjvj

Шаг 7 — Рассчитайте ошибку и откорректируйте веса следующим образом —

Случай 1 — если y ≠ t и t = 1, то

wij(новый)=wij(старый)+ alpha(1−Qinj)xi

bj(новый)=bj(старый)+ alpha(1−Qinj)

В этом случае весовые коэффициенты будут обновлены в Q j, где чистый входной сигнал близок к 0, поскольку t = 1 .

Случай 2 — если y ≠ t и t = -1, то

wik(новый)=wik(старый)+ alpha(−1−Qink)xi

bk(новый)=bk(старый)+ alpha(−1−Qink))

В этом случае веса будут обновлены на Q k, где чистый входной сигнал положительный, потому что t = -1 .

Здесь «y» — фактический выход, а «t» — желаемый / целевой выход.

Случай 3 — если у = т, то

Там не будет никаких изменений в весах.

Шаг 8 — Проверка состояния остановки, которое произойдет, когда нет изменений в весе или когда наибольшее изменение веса произошло во время тренировки, меньше указанного допуска.

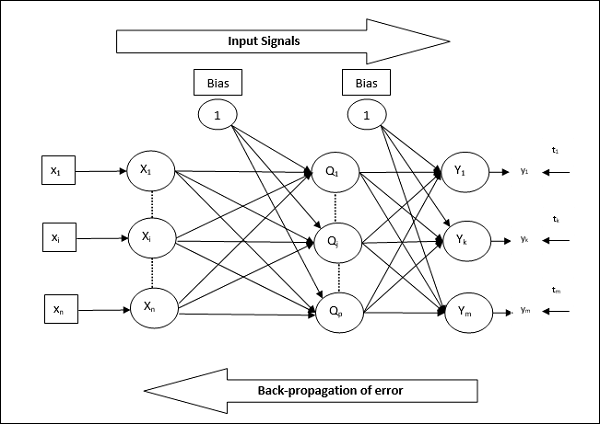

Нейронные сети обратного распространения

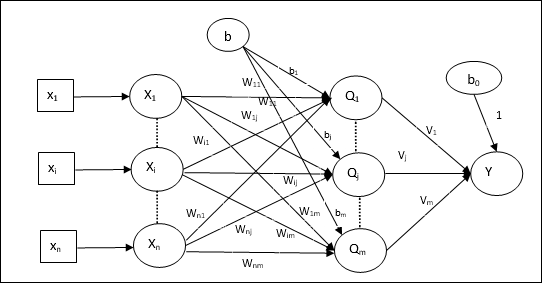

Back Propagation Neural (BPN) — это многослойная нейронная сеть, состоящая из входного слоя, как минимум одного скрытого слоя и выходного слоя. Как следует из названия, в этой сети будет происходить обратное распространение. Ошибка, которая вычисляется на выходном слое путем сравнения целевого и фактического выходных данных, будет распространяться обратно к входному слою.

Архитектура

Как показано на диаграмме, архитектура BPN имеет три взаимосвязанных уровня с весами на них. Скрытый слой и выходной слой также имеют смещение, вес которого всегда равен 1, на них. Как видно из диаграммы, работа BPN проходит в два этапа. Одна фаза отправляет сигнал с входного уровня на выходной уровень, а другая фаза обратно распространяет ошибку с выходного уровня на входной уровень.

Алгоритм обучения

Для обучения BPN будет использовать бинарную функцию активации сигмоида. Обучение BPN будет состоять из следующих трех этапов.

-

Фаза 1 — Фаза прямой подачи

-

Этап 2 — обратное распространение ошибки

-

Этап 3 — Обновление весов

Фаза 1 — Фаза прямой подачи

Этап 2 — обратное распространение ошибки

Этап 3 — Обновление весов

Все эти шаги будут заключены в алгоритме следующим образом

Шаг 1 — Инициализируйте следующее, чтобы начать тренировку —

- Веса

- Скорость обучения alpha

Для простоты расчета и простоты возьмите несколько небольших случайных значений.

Шаг 2 — Продолжайте шаг 3-11, когда условие остановки не соответствует действительности.

Шаг 3 — Продолжайте шаги 4-10 для каждой тренировочной пары.

Фаза 1

Шаг 4 — Каждый входной блок получает входной сигнал x i и отправляет его на скрытый блок для всех i = 1 до n

Шаг 5 — Рассчитать чистый вход в скрытой единице, используя следующее соотношение —

Qinj=b0j+ sumni=1xivijj= :1кр

Здесь b 0j — это смещение на скрытой единице, v ij — вес на j единице скрытого слоя, поступающего из i единицы входного слоя.

Теперь вычислите чистый результат, применив следующую функцию активации

QJ=F(Qинъек)

Отправьте эти выходные сигналы скрытых единиц слоя на единицы выходного слоя.

Шаг 6 — Рассчитать чистый входной сигнал на единицу выходного слоя, используя следующее соотношение —

yink=b0k+ sumpj=1Qjwjkk= :1км

Здесь b 0k — смещение на выходной единице, w jk — вес на k единицу выходного слоя, приходящего из j единицы скрытого слоя.

Рассчитать чистый выход, применяя следующую функцию активации

у−к=F(у−чернил)

Фаза 2

Шаг 7 — Вычислить член, исправляющий ошибки, в соответствии с целевым шаблоном, полученным на каждом выходном блоке, следующим образом:

Deltaк= :(tк−yк)е(у−чернила)

Исходя из этого, обновите вес и уклон следующим образом —

Deltavjk= alpha deltakQij

Deltab0k= alpha deltak

Затем отправьте deltak обратно в скрытый слой.

Шаг 8 — Теперь каждая скрытая единица будет суммой своих дельта-входов от выходных единиц.

deltainj= displaystyle sum limitmk=1 deltakwjk

Срок ошибки можно рассчитать следующим образом —

Deltaj= Deltaинъекце′(Qинъек)

Исходя из этого, обновите вес и уклон следующим образом —

Deltawij= alpha deltajxi

Deltab0j= alpha deltaj

Фаза 3

Шаг 9 — Каждый выходной блок (y k k = 1 до m) обновляет вес и смещение следующим образом —

vjk(новый)=vjk(старый)+ Deltavjk

b0k(новый)=b0k(старый)+ Deltab0k

Шаг 10 — Каждый выходной блок (z j j = 1 до p) обновляет вес и смещение следующим образом —

wij(новый)=wij(старый)+ Deltawij

b0j(новый)=b0j(старый)+ Deltab0j

Шаг 11 — Проверьте условие остановки, которое может быть либо количеством достигнутых эпох, либо целевым выходом, совпадающим с фактическим выходом.

Обобщенное правило обучения Delta

Дельта-правило работает только для выходного слоя. С другой стороны, обобщенное дельта-правило, также называемое правилом обратного распространения , является способом создания желаемых значений скрытого слоя.

Математическая формулировка

Для функции активации yk=f(yink) вывод чистых входных данных на скрытом слое, а также на выходном слое может быть задан как

у−чернил= displaystyle сумма limitsiZяwJK

И yinj= sumixivij

Теперь ошибка, которую нужно минимизировать,

Е= гидроразрыва12 displaystyle сумма limitsк[Tк−у−к]2

Используя правило цепочки, мы имеем

frac частичныйE частичныйwjk= frac частный частичныйwjk( frac12 displaystyle sum limitsк[tк−yк]2)

= frac частный частичныйwjk lgroup frac12[tk−t(yink)]]2 rgroup

=−[tk−yk] frac частный частичныйwjkf(yчернила)

=−[tk−yk]f(yчернила) frac частный частичныйwjk(yчернила)

= \: — [T_ {к} \: — \: у- {к}] {е ^ ‘} ({у- чернил}) Z_ {J}

Теперь давайте скажем deltak=−[tk−yk]f′(yink)

Веса на соединениях со скрытой единицей z j могут быть определены как —

frac частичныйE частичныйvij=− displaystyle sum limitk deltak frac частный частичныйvij :(yчернила)

Положив значение yink, получим следующее

Deltaj=− displaystyle сумма limitsк DeltaкwЮ.К.е′(zинъек)

Обновление веса может быть сделано следующим образом —

Для блока вывода —

Deltawjk=− alpha frac частичныйE частичныйwjk

= альфа DeltaкZJ

Для скрытого юнита —

Deltavij=− alpha frac частичныйE частичныйvij

= альфа DeltaJXя

Обучение без учителя

Как следует из названия, этот тип обучения осуществляется без присмотра учителя. Этот процесс обучения является независимым. Во время обучения ANN при обучении без учителя входные векторы аналогичного типа объединяются в кластеры. Когда применяется новый шаблон ввода, то нейронная сеть выдает ответ с указанием класса, которому принадлежит шаблон ввода. При этом не будет обратной связи от среды относительно того, каким должен быть желаемый результат и является ли он правильным или неправильным. Следовательно, в этом типе обучения сама сеть должна обнаруживать шаблоны, особенности из входных данных и отношение для входных данных по выходу.

Winner-Takes-All Networks

Эти виды сетей основаны на правиле конкурентного обучения и будут использовать стратегию, при которой нейрон выбирается с наибольшим суммарным вкладом в качестве победителя. Соединения между выходными нейронами показывают конкуренцию между ними, и один из них будет «ВКЛ», что означает, что он будет победителем, а другие «ВЫКЛ».

Ниже приведены некоторые сети, основанные на этой простой концепции, использующей обучение без учителя.

Сеть Хемминга

В большинстве нейронных сетей, использующих неконтролируемое обучение, важно вычислить расстояние и выполнить сравнение. Этот вид сети представляет собой сеть Хемминга, где для каждого заданного входного вектора она будет сгруппирована в разные группы. Ниже приведены некоторые важные особенности сетей Хемминга.

-

Липпманн начал работать над сетями Хэмминга в 1987 году.

-

Это однослойная сеть.

-

Входные данные могут быть двоичными {0, 1} из биполярных {-1, 1}.

-

Веса сети рассчитываются по примерным векторам.

-

Это сеть с фиксированным весом, что означает, что веса останутся неизменными даже во время тренировок.

Липпманн начал работать над сетями Хэмминга в 1987 году.

Это однослойная сеть.

Входные данные могут быть двоичными {0, 1} из биполярных {-1, 1}.

Веса сети рассчитываются по примерным векторам.

Это сеть с фиксированным весом, что означает, что веса останутся неизменными даже во время тренировок.

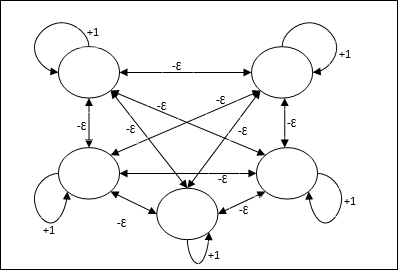

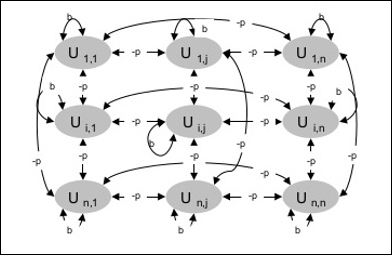

Макс Чистый

Это также сеть с фиксированным весом, которая служит подсетью для выбора узла, имеющего самый высокий вход. Все узлы полностью взаимосвязаны, и во всех этих взвешенных взаимосвязях существуют симметричные веса.

Архитектура

Он использует механизм, который является итеративным процессом, и каждый узел получает запрещающие входные данные от всех других узлов через соединения. Один узел, значение которого является максимальным, будет активным или победителем, а активации всех других узлов будут неактивными. Max Net использует функцию активации личности с f (x) \: = \: \ begin {case} x & if \: x> 0 \\ 0 & if \: x \ leq 0 \ end {case}

Задача этой сети достигается за счет веса самовозбуждения +1 и величины взаимного торможения, которая устанавливается как [0 <ɛ < frac1m], где «m» — это общее число узлы.

Конкурентное обучение в ANN

Он связан с обучением без присмотра, при котором выходные узлы пытаются конкурировать друг с другом, чтобы представить шаблон ввода. Чтобы понять это правило обучения, нам нужно понять конкурентную сеть, которая объясняется следующим образом:

Основная концепция конкурентной сети

Эта сеть подобна однослойной сети прямой связи, имеющей соединение обратной связи между выходами. Соединения между выходами имеют запретительный тип, что показано пунктирными линиями, что означает, что конкуренты никогда не поддерживают себя.

Основная концепция правила конкурентного обучения

Как было сказано ранее, между узлами вывода будет конкуренция, поэтому основная концепция заключается в том, что во время обучения модуль вывода, который имеет наибольшую активацию для данного шаблона ввода, будет объявлен победителем. Это правило также называется Победитель получает все, потому что обновляется только выигрышный нейрон, а остальные нейроны остаются без изменений.

Математическая формулировка

Ниже приведены три важных фактора для математической формулировки этого правила обучения:

-

Условие быть победителем

Предположим, что если нейрон y k хочет быть победителем, тогда будет следующее условие

y_ {k} \: = \: \ begin {case} 1 & if \: v_ {k}> v_ {j} \: for \: all \: \: j, \: j \: \ neq \ : k \\ 0 & в противном случае \ end {case}

Это означает, что если какой-либо нейрон, скажем, y k хочет победить, то его индуцированное локальное поле (выходной сигнал единицы суммирования), скажем, v k , должно быть наибольшим среди всех других нейронов в сети.

-

Условие суммы суммы веса

Другим ограничением для правила конкурентного обучения является общая сумма весов для конкретного выходного нейрона, равная 1. Например, если мы рассмотрим нейрон k, то

\ displaystyle \ sum \ limit_ {k} w_ {kj} \: = \: 1 \: \: \: \: for \: все \: \: k

-

Смена веса для победителя

Если нейрон не реагирует на шаблон ввода, то обучение в этом нейроне не происходит. Однако, если конкретный нейрон выигрывает, то соответствующие веса корректируются следующим образом:

\ Delta w_ {kj} \: = \: \ begin {case} — \ alpha (x_ {j} \: — \: w_ {kj}), & if \: нейрон \: k \: wins \\ 0 & if \: нейрон \: k \: убытки \ конец {случаи}

Здесь \ alpha — скорость обучения.

Это ясно показывает, что мы отдаем предпочтение выигрышному нейрону, регулируя его вес, и, если нейрон потерян, нам не нужно беспокоиться о том, чтобы перенастроить его вес.

Условие быть победителем

Предположим, что если нейрон y k хочет быть победителем, тогда будет следующее условие

y_ {k} \: = \: \ begin {case} 1 & if \: v_ {k}> v_ {j} \: for \: all \: \: j, \: j \: \ neq \ : k \\ 0 & в противном случае \ end {case}

Это означает, что если какой-либо нейрон, скажем, y k хочет победить, то его индуцированное локальное поле (выходной сигнал единицы суммирования), скажем, v k , должно быть наибольшим среди всех других нейронов в сети.

Условие суммы суммы веса

Другим ограничением для правила конкурентного обучения является общая сумма весов для конкретного выходного нейрона, равная 1. Например, если мы рассмотрим нейрон k, то

\ displaystyle \ sum \ limit_ {k} w_ {kj} \: = \: 1 \: \: \: \: for \: все \: \: k

Смена веса для победителя

Если нейрон не реагирует на шаблон ввода, то обучение в этом нейроне не происходит. Однако, если конкретный нейрон выигрывает, то соответствующие веса корректируются следующим образом:

\ Delta w_ {kj} \: = \: \ begin {case} — \ alpha (x_ {j} \: — \: w_ {kj}), & if \: нейрон \: k \: wins \\ 0 & if \: нейрон \: k \: убытки \ конец {случаи}

Здесь \ alpha — скорость обучения.

Это ясно показывает, что мы отдаем предпочтение выигрышному нейрону, регулируя его вес, и, если нейрон потерян, нам не нужно беспокоиться о том, чтобы перенастроить его вес.

Алгоритм кластеризации K-средних

K-means — один из самых популярных алгоритмов кластеризации, в котором мы используем концепцию процедуры разбиения. Мы начинаем с исходного раздела и многократно перемещаем шаблоны из одного кластера в другой, пока не получим удовлетворительный результат.

Алгоритм

Шаг 1 — Выберите k точек в качестве начальных центроидов. Инициализируйте k прототипов (w 1 ,…, w k ) , например, мы можем отождествить их со случайно выбранными входными векторами —

W_ {j} \: = \: i_ {p}, \: \: \: где \: j \: \ in \ lbrace1, …., k \ rbrace \: и \: p \: \ в \ lbrace1, …., n \ rbrace

Каждый кластер C j связан с прототипом w j .

Шаг 2 — Повторяйте шаг 3-5, пока E больше не уменьшится или членство в кластере больше не изменится.

Шаг 3 — Для каждого входного вектора i p, где p ∈ {1,…, n} , положить i p в кластер C j * с ближайшим прототипом w j *, имеющим следующее соотношение

| i_ {p} \: — \: w_ {j *} | \: \ leq \: | i_ {p} \: — \: w_ {j} |, \: j \: \ in \ lbrace1, …., к \ rbrace

Шаг 4 — Для каждого кластера C j , где j ∈ {1,…, k} , обновите прототип w j, чтобы он был центром тяжести всех выборок, в настоящее время находящихся в C j , так, чтобы

w_ {j} \: = \: \ sum_ {i_ {p} \ in C_ {j}} \ frac {i_ {p}} {| C_ {j} |}

Шаг 5 — Рассчитать общую ошибку квантования следующим образом —

E \: = \: \ sum_ {j = 1} ^ k \ sum_ {i_ {p} \ in w_ {j}} | i_ {p} \: — \: w_ {j} | ^ 2

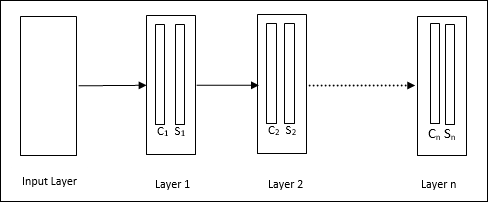

Неокогнитрон

Это многослойная сеть прямой связи, которая была разработана Fukushima в 1980-х годах. Эта модель основана на контролируемом обучении и используется для визуального распознавания образов, в основном рукописных символов. Это в основном расширение сети Cognitron, которая также была разработана компанией Fukushima в 1975 году.

Архитектура

Это иерархическая сеть, которая включает в себя много уровней, и в этих слоях существует локальная схема подключения.

Как мы видели на приведенной выше диаграмме, неокогнитрон делится на разные связанные слои, и каждый слой имеет две клетки. Объяснение этих клеток заключается в следующем —

S-ячейка — она называется простой ячейкой, которая обучается реагировать на определенный шаблон или группу шаблонов.

C-Cell — называется сложной ячейкой, которая объединяет выходные данные S-ячейки и одновременно уменьшает количество единиц в каждом массиве. В другом смысле C-клетка вытесняет результат S-клетки.

Алгоритм обучения

Тренировка неокогнитрона, как находят, прогрессирует слой за слоем. Веса от входного слоя до первого слоя обучаются и замораживаются. Затем тренируются веса от первого до второго слоя и так далее. Внутренние вычисления между S-ячейкой и Ccell зависят от весов, поступающих с предыдущих слоев. Следовательно, можно сказать, что алгоритм обучения зависит от расчетов на S-элементе и C-элементе.

Расчеты в S-ячейке

S-клетка обладает возбуждающим сигналом, полученным от предыдущего уровня, и обладает ингибирующими сигналами, полученными в том же слое.

\ theta = \: \ sqrt {\ sum \ sum t_ {i} c_ {i} ^ 2}

Здесь t i — фиксированный вес, а c i — выходной сигнал C-ячейки.

Масштабированный вход S-ячейки может быть рассчитан следующим образом:

х \: = \: \ гидроразрыва {1 \ + \: е} {1 \ + \: vw_ {0}} \: — \: 1

Здесь e \: = \: \ sum_i c_ {i} w_ {i}

w i — вес, скорректированный от C-клетки до S-клетки.

w 0 — вес, регулируемый между входом и S-ячейкой.

v — возбуждающий вход от С-клетки.

Активация выходного сигнала:

s \: = \: \ begin {case} x, & if \: x \ geq 0 \\ 0, & if \: x <0 \ end {case}

Расчеты в C-ячейке

Чистый вход C-слоя

C \: = \: \ displaystyle \ sum \ limit_i s_ {i} x_ {i}

Здесь s i — выходной сигнал от S-ячейки, а x i — фиксированный вес от S-ячейки до C-ячейки.

Окончательный результат выглядит следующим образом —

C_ {out} \: = \: \ begin {case} \ frac {C} {a + C}, & if \: C> 0 \\ 0, а в противном случае \ end {case}

Здесь «а» — это параметр, который зависит от производительности сети.

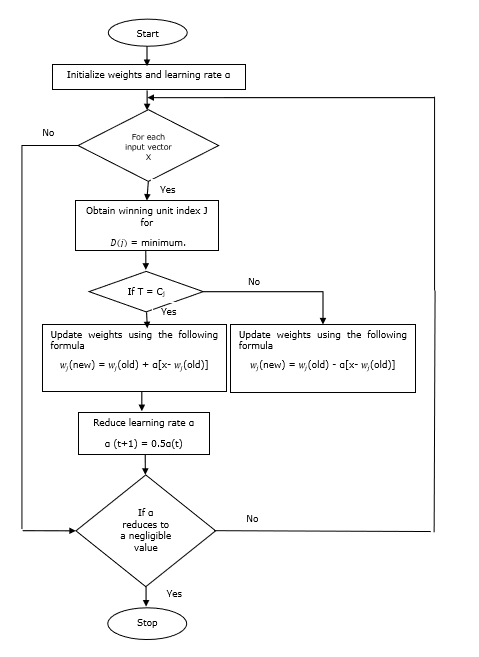

Изучение вектора квантования

Векторное квантование обучения (LVQ), отличающееся от векторного квантования (VQ) и самоорганизующихся карт Кохонена (KSOM), в основном представляет собой конкурентную сеть, в которой используется контролируемое обучение. Мы можем определить его как процесс классификации шаблонов, где каждая единица вывода представляет класс. Поскольку он использует контролируемое обучение, сети будет предоставлен набор обучающих шаблонов с известной классификацией наряду с начальным распределением выходного класса. После завершения процесса обучения LVQ классифицирует входной вектор, назначая его тому же классу, что и выходной блок.

Архитектура

На следующем рисунке показана архитектура LVQ, которая очень похожа на архитектуру KSOM. Как мы видим, существует «n» количество единиц ввода и «m» количество единиц вывода. Слои полностью взаимосвязаны с весом на них.

Используемые параметры

Ниже приведены параметры, используемые в процессе обучения LVQ, а также в блок-схеме

-

x = вектор обучения (x 1 , …, x i , …, x n )

-

T = класс для обучающего вектора x

-

w j = весовой вектор для j- й единицы измерения

-

C j = класс, связанный с j- й единицей вывода

x = вектор обучения (x 1 , …, x i , …, x n )

T = класс для обучающего вектора x

w j = весовой вектор для j- й единицы измерения

C j = класс, связанный с j- й единицей вывода

Алгоритм обучения

Шаг 1 — Инициализировать опорные векторы, что можно сделать следующим образом:

-

Шаг 1 (а) — Из данного набора тренировочных векторов взять первые « m » (количество кластеров) тренировочных векторов и использовать их в качестве весовых векторов. Остальные векторы могут быть использованы для обучения.

-

Шаг 1 (б) — Присвойте начальный вес и классификацию случайным образом.

-

Шаг 1 (с) — Применение метода кластеризации K-средних.

Шаг 1 (а) — Из данного набора тренировочных векторов взять первые « m » (количество кластеров) тренировочных векторов и использовать их в качестве весовых векторов. Остальные векторы могут быть использованы для обучения.

Шаг 1 (б) — Присвойте начальный вес и классификацию случайным образом.

Шаг 1 (с) — Применение метода кластеризации K-средних.

Шаг 2 — Инициализировать опорный вектор \ alpha

Шаг 3 — Продолжайте с шагов 4-9, если условие остановки этого алгоритма не выполняется.

Шаг 4 — Выполните шаги 5-6 для каждого входного вектора обучения x .

Шаг 5 — Рассчитать квадрат евклидова расстояния для j = 1 до m и i = от 1 до n

D (j) \: = \: \ displaystyle \ sum \ limit_ {i = 1} ^ n \ displaystyle \ sum \ limit_ {j = 1} ^ m (x_ {i} \: — \: w_ {ij }) ^ 2

Шаг 6 — Получить выигрышную единицу J, где D (j) минимально.

Шаг 7 — Рассчитайте новый вес выигрышной единицы по следующему соотношению —

если T = C j, то w_ {j} (новый) \: = \: w_ {j} (старый) \: + \: \ alpha [x \: — \: w_ {j} (старый)]

если T ≠ C j, то w_ {j} (новый) \: = \: w_ {j} (старый) \: — \: \ alpha [x \: — \: w_ {j} (старый)]

Шаг 8 — Уменьшите скорость обучения \ alpha .

Шаг 9 — Проверка состояния остановки. Это может быть следующим:

- Максимальное количество эпох достигнуто.

- Скорость обучения снижена до незначительного значения.

блок-схема

Варианты

Три других варианта, а именно LVQ2, LVQ2.1 и LVQ3, были разработаны Кохоненом. Сложность во всех этих трех вариантах из-за концепции, которую изучат победитель и юнит, занявший второе место, больше, чем в LVQ.

LVQ2

Как уже обсуждалось, концепция других вариантов LVQ выше, состояние LVQ2 формируется окном. Это окно будет основано на следующих параметрах —

-

х — текущий входной вектор

-

y c — опорный вектор, ближайший к x

-

y r — другой опорный вектор, ближайший к x

-

d c — расстояние от x до y c

-

d r — расстояние от x до y r

х — текущий входной вектор

y c — опорный вектор, ближайший к x

y r — другой опорный вектор, ближайший к x

d c — расстояние от x до y c

d r — расстояние от x до y r

Входной вектор х попадает в окно, если

\ гидроразрыва {D_ {C}} {D_ {г}} \:> \: 1 \: — \: \ тета \: \: и \: \: \ гидроразрыва {D_ {г}} {D_ {с }} \:> \: 1 \ + \: \ Theta

Здесь \ theta — количество обучающих образцов.

Обновление можно выполнить по следующей формуле:

У- {с} (т \ + \: 1) \: = \: у- {C} (т) \ + \: \ альфа (т) [х (т) \: — \: у- {C} (t)] (принадлежит к другому классу)

У- {г} (т \ + \: 1) \: = \: у- {г} (т) \ + \: \ альфа (т) [х (т) \: — \: у- {г} (t)] (принадлежит к тому же классу)

Здесь \ alpha — скорость обучения.

LVQ2.1

В LVQ2.1 мы возьмем два ближайших вектора, а именно y c1 и y c2, и условие для окна следующее:

Min \ {начинаются bmatrix} \ гидроразрыва {D_ {c1}} {D_ {c2}}, \ гидроразрыва {D_ {c2}} {D_ {c1}} \ {конец bmatrix} \:> \ 🙁 1 \ : — \: \ Theta)

Max \ {начинаются bmatrix} \ гидроразрыва {D_ {c1}} {D_ {c2}}, \ гидроразрыва {D_ {c2}} {D_ {c1}} \ {конец bmatrix} \ <\ 🙁 1 \ : + \: \ тета)

Обновление можно выполнить по следующей формуле:

У- {c1} (т \ + \: 1) \: = \: у- {c1} (т) \ + \: \ альфа (т) [х (т) \: — \: у- {c1} (t)] (принадлежит к другому классу)

У- {с2} (т \ + \: 1) \: = \: у- {с2} (т) \ + \: \ альфа (т) [х (т) \: — \: у- {с2} (t)] (принадлежит к тому же классу)

Здесь \ alpha — это скорость обучения.

LVQ3

В LVQ3 мы возьмем два ближайших вектора, а именно y c1 и y c2, и условие для окна будет следующим:

Min \ {начинаются bmatrix} \ гидроразрыва {D_ {c1}} {D_ {c2}}, \ гидроразрыва {D_ {c2}} {D_ {c1}} \ {конец bmatrix} \:> \ 🙁 1 \ : — \: \ тета) (1 \ + \: \ тета)

Здесь \ theta \ ок. 0,2

Обновление можно выполнить по следующей формуле:

У- {c1} (т \ + \: 1) \: = \: у- {c1} (т) \ + \: \ бета (т) [х (т) \: — \: у- {c1} (t)] (принадлежит к другому классу)

У- {с2} (т \ + \: 1) \: = \: у- {с2} (т) \ + \: \ бета (т) [х (т) \: — \: у- {с2} (t)] (принадлежит к тому же классу)

Здесь \ beta — это кратное значение скорости обучения \ alpha и \ beta \: = \: m \ alpha (t) для каждых 0,1 <m <0,5

Адаптивная Резонансная Теория

Эта сеть была разработана Стивеном Гроссбергом и Гейл Карпентер в 1987 году. Она основана на конкуренции и использует модель обучения без присмотра. Сети Адаптивной Резонансной Теории (ART), как следует из названия, всегда открыты для нового обучения (адаптивного) без потери старых паттернов (резонанса). По сути, сеть ART представляет собой векторный классификатор, который принимает входной вектор и классифицирует его в одну из категорий в зависимости от того, какой из сохраненных шаблонов он больше всего напоминает.

Операционный директор

Основную операцию классификации АРТ можно разделить на следующие этапы —

-

Этап распознавания — входной вектор сравнивается с классификацией, представленной в каждом узле выходного слоя. Выход нейрона становится «1», если он наилучшим образом соответствует применяемой классификации, в противном случае он становится «0».

-

Фаза сравнения. На этом этапе выполняется сравнение входного вектора с вектором слоя сравнения. Условием для сброса является то, что степень сходства будет меньше, чем параметр бдительности.

-

Фаза поиска — На этом этапе сеть будет искать сброс, а также соответствие, выполненное на вышеуказанных этапах. Следовательно, если бы не было сброса и совпадение было бы достаточно хорошим, то классификация окончена. В противном случае процесс будет повторен, и для сохранения правильного соответствия необходимо отправить другой сохраненный шаблон.

Этап распознавания — входной вектор сравнивается с классификацией, представленной в каждом узле выходного слоя. Выход нейрона становится «1», если он наилучшим образом соответствует применяемой классификации, в противном случае он становится «0».

Фаза сравнения. На этом этапе выполняется сравнение входного вектора с вектором слоя сравнения. Условием для сброса является то, что степень сходства будет меньше, чем параметр бдительности.

Фаза поиска — На этом этапе сеть будет искать сброс, а также соответствие, выполненное на вышеуказанных этапах. Следовательно, если бы не было сброса и совпадение было бы достаточно хорошим, то классификация окончена. В противном случае процесс будет повторен, и для сохранения правильного соответствия необходимо отправить другой сохраненный шаблон.

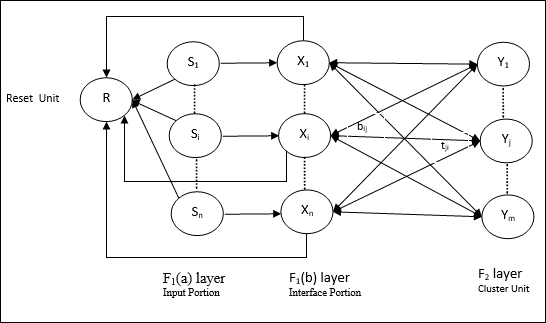

ART1

Это тип ART, который предназначен для кластеризации двоичных векторов. Мы можем понять это с архитектурой этого.

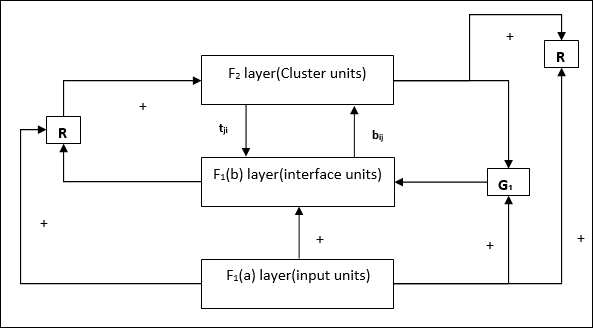

Архитектура ART1

Он состоит из следующих двух блоков —

Вычислительная единица — состоит из следующих элементов:

-

Блок ввода (слой F 1 ) — он также имеет следующие две части —

-

F 1 (a) layer (Input input) — В ART1 не будет обработки в этой части, вместо того, чтобы иметь только входные векторы. Он связан с уровнем F 1 (b) (интерфейсная часть).

-

Уровень F 1 (b) (интерфейсная часть) — эта часть объединяет сигнал от входной части с сигналом уровня F 2 . Слой F 1 (b) соединен со слоем F 2 через веса снизу вверх b ij, а слой F 2 соединен со слоем F 1 (b) через веса сверху вниз t ji .

-

-

Блок кластера (слой F 2 ) — это конкурентный уровень. Единица, имеющая наибольший сетевой вход, выбирается для изучения схемы ввода. Активация всех других узлов кластера установлена на 0.

-

Механизм сброса . Работа этого механизма основана на сходстве веса сверху вниз и вектора ввода. Теперь, если степень этого сходства меньше, чем параметр бдительности, кластеру не разрешается изучать шаблон, и отдых может произойти.

Блок ввода (слой F 1 ) — он также имеет следующие две части —

F 1 (a) layer (Input input) — В ART1 не будет обработки в этой части, вместо того, чтобы иметь только входные векторы. Он связан с уровнем F 1 (b) (интерфейсная часть).

Уровень F 1 (b) (интерфейсная часть) — эта часть объединяет сигнал от входной части с сигналом уровня F 2 . Слой F 1 (b) соединен со слоем F 2 через веса снизу вверх b ij, а слой F 2 соединен со слоем F 1 (b) через веса сверху вниз t ji .

Блок кластера (слой F 2 ) — это конкурентный уровень. Единица, имеющая наибольший сетевой вход, выбирается для изучения схемы ввода. Активация всех других узлов кластера установлена на 0.

Механизм сброса . Работа этого механизма основана на сходстве веса сверху вниз и вектора ввода. Теперь, если степень этого сходства меньше, чем параметр бдительности, кластеру не разрешается изучать шаблон, и отдых может произойти.

Модуль дополнения — На самом деле проблема с механизмом сброса заключается в том, что слой F 2 должен быть заблокирован при определенных условиях, а также должен быть доступен, когда происходит некоторое обучение. Вот почему два дополнительных блока, а именно, G 1 и G 2 , добавляются вместе с блоком сброса R. Они называются блоками управления усилением . Эти устройства принимают и отправляют сигналы другим устройствам, присутствующим в сети. «+» обозначает возбуждающий сигнал, а «-» обозначает запрещающий сигнал.

Используемые параметры

Используются следующие параметры:

-

n — количество компонентов во входном векторе

-

m — максимальное количество кластеров, которые могут быть сформированы

-

b ij — Вес от слоя F 1 (b) до слоя F 2 , т.е. веса снизу вверх

-

t ji — Вес от F 2 до F 1 (b) слоя, то есть веса сверху вниз

-

ρ — параметр бдительности

-

|| х || — норма вектора х

n — количество компонентов во входном векторе

m — максимальное количество кластеров, которые могут быть сформированы

b ij — Вес от слоя F 1 (b) до слоя F 2 , т.е. веса снизу вверх

t ji — Вес от F 2 до F 1 (b) слоя, то есть веса сверху вниз

ρ — параметр бдительности

|| х || — норма вектора х

Алгоритм

Шаг 1 — Инициализируйте скорость обучения, параметр бдительности и веса следующим образом:

\ альфа \:> \: 1 \: \: и \: \: 0 \: <\ Rho \: \ Leq \: 1

0 \: <\: B_ {IJ} (0) \ <\: \ гидроразрыва {\ альфа} {\ альфа \: — \: 1 \ + \: п} \: \: и \: \: t_ {IJ} (0) \: = \: 1

Шаг 2 — Продолжайте шаг 3-9, когда условие остановки не соответствует действительности.

Шаг 3 — Продолжайте шаг 4-6 для каждого ввода тренировки.

Шаг 4 — Установите активацию всех единиц F 1 (a) и F 1 следующим образом

F 2 = 0 и F 1 (a) = входные векторы

Шаг 5 — Входной сигнал от слоя F 1 (a) до слоя F 1 (b) должен быть отправлен как

S_ {я} \: = \: x_ {я}

Шаг 6 — Для каждого запрещенного узла F 2

y_ {j} \: = \: \ sum_i b_ {ij} x_ {i} условие: y j ≠ -1

Шаг 7 — Выполните шаги 8-10, когда сброс является истинным.

Шаг 8 — Найти J для y J ≥ y j для всех узлов j

Шаг 9 — Снова вычислите активацию на F 1 (b) следующим образом

X_ {я} \: = \: sitJi

Шаг 10 — Теперь, после расчета нормы вектора x и вектора s , нам нужно проверить условие сброса следующим образом:

Если || x || / || s || <параметр бдительности ρ , затем запретить узел J и перейти к шагу 7

Иначе, если || x || / || s || ≥ параметр бдительности ρ , затем продолжайте.

Шаг 11 — Обновление веса для узла J может быть сделано следующим образом —

b_ {ij} (новый) \: = \: \ frac {\ alpha x_ {i}} {\ alpha \: — \: 1 \: + \: || x ||}

t_ {IJ} (новый) \: = \: x_ {я}

Шаг 12 — Условие остановки для алгоритма должно быть проверено, и оно может быть следующим:

- Не иметь никаких изменений в весе.

- Сброс не выполняется для устройств.

- Максимальное количество эпох достигнуто.

Самоорганизующиеся функциональные карты Kohonen

Предположим, у нас есть шаблон произвольных измерений, однако нам нужны они в одном измерении или двух измерениях. Тогда процесс сопоставления объектов будет очень полезен для преобразования широкого пространства шаблонов в типичное пространство объектов. Теперь возникает вопрос: зачем нам нужна самоорганизующаяся карта объектов? Причина в том, что наряду с возможностью преобразования произвольных измерений в 1-D или 2-D он также должен иметь возможность сохранять топологию соседей.

Топологии соседей в Кохонене СОМ

Могут быть различные топологии, однако наиболее часто используются следующие две топологии:

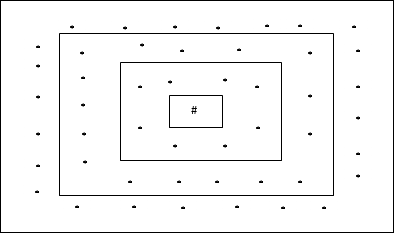

Топология прямоугольной сетки

Эта топология имеет 24 узла в сетке расстояния 2, 16 узлов в сетке расстояния 1 и 8 узлов в сетке расстояния 0, что означает, что разница между каждой прямоугольной сеткой составляет 8 узлов. Победившая единица обозначена #.

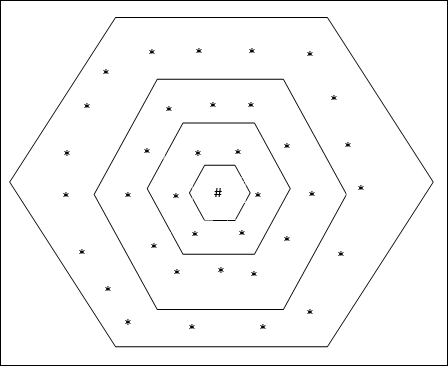

Топология гексагональной сетки

Эта топология имеет 18 узлов в сетке расстояния 2, 12 узлов в сетке расстояния 1 и 6 узлов в сетке расстояния 0, что означает, что разница между каждой прямоугольной сеткой составляет 6 узлов. Победившая единица обозначена #.

Архитектура

Архитектура KSOM аналогична архитектуре конкурентной сети. С помощью схем соседства, обсуждавшихся ранее, обучение может проходить в расширенной области сети.

Алгоритм обучения

Шаг 1 — Инициализировать веса, скорость обучения α и топологическую схему окрестности.

Шаг 2 — Продолжайте шаг 3-9, когда условие остановки не соответствует действительности.

Шаг 3 — Продолжайте шаг 4-6 для каждого входного вектора x .

Шаг 4 — Рассчитать площадь евклидова расстояния для j = 1 до м

D (j) \: = \: \ displaystyle \ sum \ limit_ {i = 1} ^ n \ displaystyle \ sum \ limit_ {j = 1} ^ m (x_ {i} \: — \: w_ {ij }) ^ 2

Шаг 5 — Получить выигрышную единицу J, где D (j) минимально.

Шаг 6 — Рассчитайте новый вес выигрышной единицы по следующему соотношению —

w_ {IJ} (новый) \: = \: w_ {IJ} (старый) \ + \: \ альфа [x_ {я} \: — \: w_ {IJ} (старый)]

Шаг 7 — Обновите скорость обучения α следующим соотношением —

\ alpha (t \: + \: 1) \: = \: 0.5 \ alpha t

Шаг 8 — Уменьшить радиус топологической схемы.

Шаг 9 — Проверьте состояние остановки сети.

Ассоциированная сеть памяти

Эти типы нейронных сетей работают на основе ассоциации шаблонов, что означает, что они могут хранить различные шаблоны и во время выдачи выходных данных они могут создавать один из сохраненных шаблонов, сопоставляя их с данным входным шаблоном. Эти типы памяти также называют Content-Addressable Memory (CAM). Ассоциативная память выполняет параллельный поиск с сохраненными шаблонами в виде файлов данных.

Ниже приведены два типа ассоциативных воспоминаний, которые мы можем наблюдать —

- Авто Ассоциативная Память

- Гетеро Ассоциативная память

Авто Ассоциативная Память

Это однослойная нейронная сеть, в которой входной обучающий вектор и выходные целевые векторы совпадают. Веса определены так, что сеть хранит набор шаблонов.

Архитектура

Как показано на следующем рисунке, архитектура сети автоассоциативной памяти имеет «n» число входных обучающих векторов и аналогичное «n» количество выходных целевых векторов.

Алгоритм обучения

Для обучения в этой сети используется правило обучения Hebb или Delta.

Шаг 1 — Инициализировать все веса до нуля, так как w ij = 0 (i = от 1 до n, от j = 1 до n)

Шаг 2 — Выполните шаги 3-4 для каждого входного вектора.

Шаг 3 — Активируйте каждый блок ввода следующим образом —

X_ {я} \: = \: S_ {я} \ 🙁 я \: = \: 1 \: к \: п)

Шаг 4 — Активируйте каждый выходной блок следующим образом —

у- {J} \: = \: S_ {J} \ 🙁 J \: = \: 1 \: к \: п)

Шаг 5 — Отрегулируйте веса следующим образом —

w_ {IJ} (новый) \: = \: w_ {IJ} (старый) \ + \: x_ {я} y_ {J}

Алгоритм тестирования

Шаг 1 — Установите веса, полученные во время тренировки для правила Хебба.

Шаг 2 — Выполните шаги 3-5 для каждого входного вектора.

Шаг 3 — Установите активацию входных единиц равной активации входного вектора.

Шаг 4 — Рассчитать чистый входной сигнал для каждой единицы выходного сигнала j = 1 до n

y_ {inj} \: = \: \ displaystyle \ sum \ limit_ {i = 1} ^ n x_ {i} w_ {ij}

Шаг 5 — Примените следующую функцию активации для расчета выхода

y_ {j} \: = \: f (y_ {inj}) \: = \: \ begin {case} +1 & if \: y_ {inj} \:> \: 0 \\ — 1 & if \: y_ {инъекц} \: \ leqslant \: 0 \ конец {случаи}

Гетеро Ассоциативная память

Подобно сети Auto Associative Memory, это также однослойная нейронная сеть. Однако в этой сети входной обучающий вектор и выходные целевые векторы не совпадают. Веса определены так, что сеть хранит набор шаблонов. Гетероассоциативная сеть носит статический характер, следовательно, не было бы нелинейных и отложенных операций.

Архитектура

Как показано на следующем рисунке, архитектура сети гетероассоциативной памяти имеет «n» число входных обучающих векторов и «m» количество выходных целевых векторов.

Алгоритм обучения

Для обучения в этой сети используется правило обучения Hebb или Delta.

Шаг 1 — Инициализировать все веса до нуля, так как w ij = 0 (i = от 1 до n, от j = 1 до m)

Шаг 2 — Выполните шаги 3-4 для каждого входного вектора.

Шаг 3 — Активируйте каждый блок ввода следующим образом —

X_ {я} \: = \: S_ {я} \ 🙁 я \: = \: 1 \: к \: п)

Шаг 4 — Активируйте каждый выходной блок следующим образом —

у- {J} \: = \: S_ {J} \ 🙁 J \: = \: 1 \: к \: м)

Шаг 5 — Отрегулируйте веса следующим образом —

w_ {IJ} (новый) \: = \: w_ {IJ} (старый) \ + \: x_ {я} y_ {J}

Алгоритм тестирования

Шаг 1 — Установите веса, полученные во время тренировки для правила Хебба.

Шаг 2 — Выполните шаги 3-5 для каждого входного вектора.

Шаг 3 — Установите активацию входных единиц равной активации входного вектора.

Шаг 4 — Рассчитать чистый входной сигнал для каждой единицы выходного сигнала j = 1 до m;

y_ {inj} \: = \: \ displaystyle \ sum \ limit_ {i = 1} ^ n x_ {i} w_ {ij}

Шаг 5 — Примените следующую функцию активации для расчета выхода

y_ {j} \: = \: f (y_ {inj}) \: = \: \ begin {case} +1 & if \: y_ {inj} \:> \: 0 \\ 0 & if \ : y_ {inj} \: = \: 0 \\ — 1 & if \: y_ {inj} \: <\: 0 \ end {case}

Искусственная Нейронная Сеть — Hopfield Networks

Нейронная сеть Хопфилда была изобретена доктором Джоном Дж. Хопфилдом в 1982 году. Она состоит из одного слоя, который содержит один или несколько полностью связанных рекуррентных нейронов. Сеть Хопфилда обычно используется для задач автоассоциирования и оптимизации.

Дискретная сеть Хопфилда

Сеть Хопфилда, которая работает в виде дискретных линий или, другими словами, можно сказать, что шаблоны ввода и вывода являются дискретными векторами, которые могут быть двоичными (0,1) или биполярными (+1, -1) по своей природе. Сеть имеет симметричные веса без самоподключений, т. Е. W ij = w ji и w ii = 0 .

Архитектура

Ниже приведены некоторые важные моменты, о которых следует помнить о дискретной сети Хопфилда.

-

Эта модель состоит из нейронов с одним инвертирующим и одним неинвертирующим выходом.

-

Выход каждого нейрона должен быть входом других нейронов, но не входом самого себя.

-

Вес / прочность соединения обозначены как w ij .

-

Соединения могут быть как возбуждающими, так и тормозящими. Было бы возбуждающим, если выходной сигнал нейрона такой же, как входной, в противном случае тормозной.

-

Веса должны быть симметричными, т.е. w ij = w ji

Эта модель состоит из нейронов с одним инвертирующим и одним неинвертирующим выходом.

Выход каждого нейрона должен быть входом других нейронов, но не входом самого себя.

Вес / прочность соединения обозначены как w ij .

Соединения могут быть как возбуждающими, так и тормозящими. Было бы возбуждающим, если выходной сигнал нейрона такой же, как входной, в противном случае тормозной.

Веса должны быть симметричными, т.е. w ij = w ji

Выходные данные от Y 1, идущие к Y 2 , Y i и Y n, имеют веса w 12 , w 1i и w 1n соответственно. Точно так же другие дуги имеют веса на них.

Алгоритм обучения

Во время обучения дискретной сети Хопфилда веса будут обновляться. Поскольку мы знаем, что у нас могут быть двоичные входные векторы, а также биполярные входные векторы. Следовательно, в обоих случаях обновления веса могут быть выполнены со следующим соотношением

Случай 1 — Шаблоны двоичного ввода

Для набора бинарных паттернов s (p), p = 1 до P

Здесь s (p) = s 1 (p), s 2 (p), …, s i (p), …, s n (p)

Весовая матрица задается

w_ {IJ} \: = \: \ sum_ {р = 1} ^ Р [2s_ {я} (р) — \: 1] [2s_ {J} (р) — \: 1] \: \: \: \: \: для \: я \: \ NEQ \: J

Случай 2 — Биполярные модели ввода

Для набора бинарных паттернов s (p), p = 1 до P

Здесь s (p) = s 1 (p), s 2 (p), …, s i (p), …, s n (p)

Весовая матрица задается

w_ {IJ} \: = \: \ sum_ {р = 1} ^ Р [S_ {я} (р)] [S_ {J} (р)] \: \: \: \: \: для \ : я \: \ NEQ \: J

Алгоритм тестирования

Шаг 1 — Инициализировать веса, которые получены из алгоритма обучения с использованием принципа Хебба.

Шаг 2 — Выполните шаги 3-9, если активации сети не консолидированы.

Шаг 3 — Для каждого входного вектора X выполните шаги 4-8.

Шаг 4 — Сделайте начальную активацию сети равной внешнему входному вектору X следующим образом —

у- {я} \: = \: X_ {я} \: \: \: для \: я \: = \: 1 \: к \: п

Шаг 5 — Для каждого блока Y i выполните шаги 6-9.

Шаг 6 — Рассчитайте чистый вход сети следующим образом —

y_ {ини} \: = \: x_ {я} \ + \: \ displaystyle \ сумма \ limits_ {j} y_ {J} {w_ джи}

Шаг 7 — Примените активацию следующим образом к сетевому входу, чтобы рассчитать выходной сигнал —

y_ {i} \: = \ begin {case} 1 & if \: y_ {ini} \:> \: \ theta_ {i} \\ y_ {i} & if \: y_ {ini} \: = \: \ theta_ {i} \\ 0 & if \: y_ {ini} \: <\: \ theta_ {i} \ end {case}

Здесь \ theta_ {i} — это порог.

Шаг 8 — Передайте этот вывод y i всем другим устройствам.

Шаг 9 — Проверьте сеть на предмет соединения.

Оценка энергетической функции

Энергетическая функция определяется как функция, которая связана и не является возрастающей функцией состояния системы.

Энергетическая функция E f , также называемая функцией Ляпунова, определяет устойчивость дискретной сети Хопфилда и характеризуется следующим образом:

E_ {f} \: = \: — \ frac {1} {2} \ displaystyle \ sum \ limit_ {i = 1} ^ n \ displaystyle \ sum \ limit_ {j = 1} ^ n y_ {i} y_ {j} w_ {ij} \: — \: \ displaystyle \ sum \ limit_ {i = 1} ^ n x_ {i} y_ {i} \: + \: \ displaystyle \ sum \ limit_ {i = 1} ^ n \ theta_ {i} y_ {i}

Условие — В стабильной сети, когда состояние узла изменяется, вышеуказанная энергетическая функция будет уменьшаться.

Предположим, что когда узел i изменил состояние с y_i ^ {(k)} на y_i ^ {(k \: + \: 1)} , то изменение энергии \ Delta E_ {f} определяется выражением следующее отношение

\ Delta E_ {f} \: = \: E_ {f} (y_i ^ {(k + 1)}) \: — \: E_ {f} (y_i ^ {(k)})

= \: — \ left (\ begin {array} {c} \ displaystyle \ sum \ limit_ {j = 1} ^ n w_ {ij} y_i ^ {(k)} \: + \: x_ {i} \: — \: \ theta_ {я} \ {конец массива} \ справа) (y_i ^ {(к + 1)} \: — \: y_i ^ {(к)})

= \: — \ 🙁 net_ {i}) \ Delta y_ {i}

Здесь \ Delta y_ {i} \: = \: y_i ^ {(k \: + \: 1)} \: — \: y_i ^ {(k)}

Изменение энергии зависит от того, что только одна единица может обновлять свою активацию одновременно.

Непрерывная сеть Хопфилда

По сравнению с дискретной сетью Хопфилда непрерывная сеть имеет время как непрерывную переменную. Он также используется в задачах автоассоциации и оптимизации, таких как задачи коммивояжера.

Модель — модель или архитектуру можно создать, добавив электрические компоненты, такие как усилители, которые могут сопоставить входное напряжение с выходным напряжением через функцию активации сигмоида.

Оценка энергетической функции

E_f = \ frac {1} {2} \ displaystyle \ sum \ limit_ {i = 1} ^ n \ sum _ {\ substack {j = 1 \\ j \ ne i}} ^ n y_i y_j w_ {ij} — \ displaystyle \ sum \ limit_ {i = 1} ^ n x_i y_i + \ frac {1} {\ lambda} \ displaystyle \ sum \ limit_ {i = 1} ^ n \ sum _ {\ substack {j = 1 \\ j \ ne i}} ^ n w_ {ij} g_ {ri} \ int_ {0} ^ {y_i} a ^ {- 1} (y) dy

Здесь λ — параметр усиления и g ri входная проводимость.

Машина Больцмана