Эта статья была спонсирована import.io . Спасибо за поддержку спонсоров, которые делают возможным SitePoint!

Сеть полна интересной и полезной информации. Некоторые из самых успешных веб-приложений не более чем организовывают эту информацию творческим способом, который легко усваивается их пользователями — когда-нибудь слышали о маленькой компании под названием Google? Однако организация данных из Интернета может быть сложным и длительным процессом, и многие проекты никогда не запускаются из-за этого. Теперь import.io решает эту проблему, что означает, что веб-данные, наконец, легко собирать, систематизировать и использовать в ваших интересах.

Что такое import.io?

import.io позволяет собирать данные из Интернета, а затем получать доступ к этим данным и манипулировать ими с помощью простого пользовательского интерфейса. Как подчеркивалось в их вступительном видео , процесс очень быстрый и не требует абсолютно никаких знаний в области кодирования. После сбора ваших данных вы можете просматривать их и вносить изменения по мере необходимости, интегрировать их в свое приложение в виде API (import.io имеет отличную документацию с инструкциями о том, как это сделать на множестве языков) или загрузить ее в виде Разнообразие форматов.

Использование import.io

Большинство приложений, которые включают сложные и сложные вычислительные процессы, имеют одинаково сложные пользовательские интерфейсы. Я был удивлен, обнаружив, как легко было импортировать и использовать import.io.

После регистрации я скачал их настольное приложение (которое вам понадобится для сбора данных).

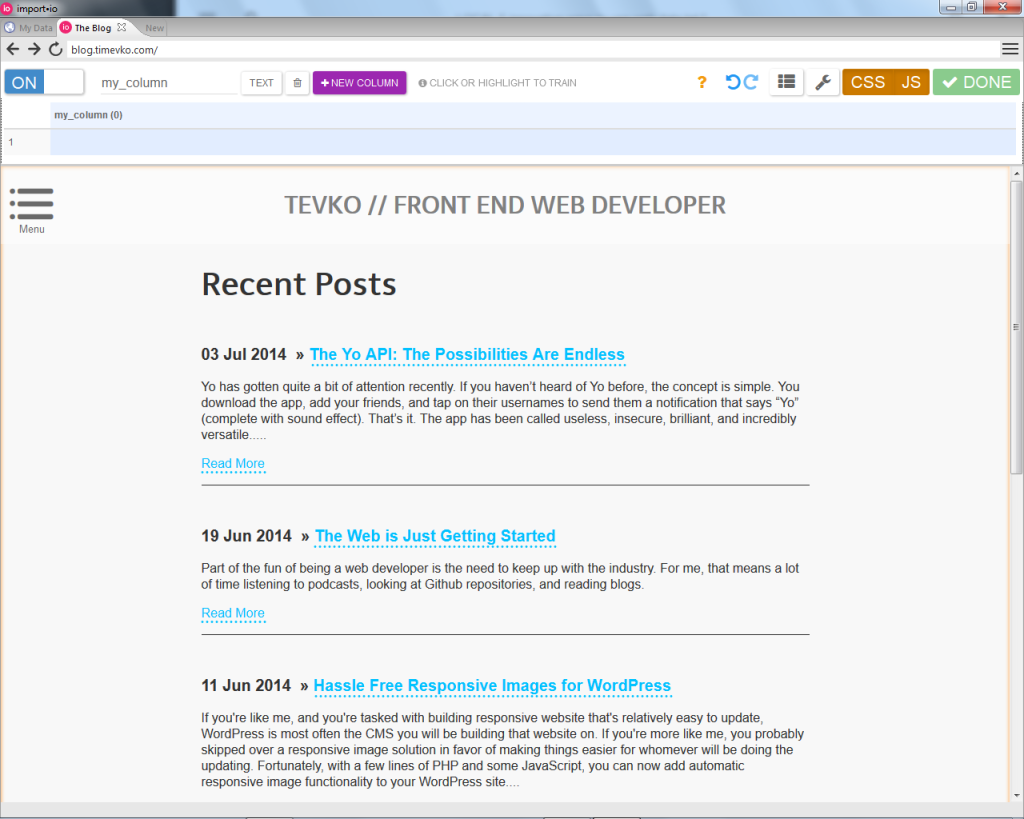

Для моего первого проекта по сбору данных я решил создать API из URL-адреса в виде набора сообщений из моего личного блога.

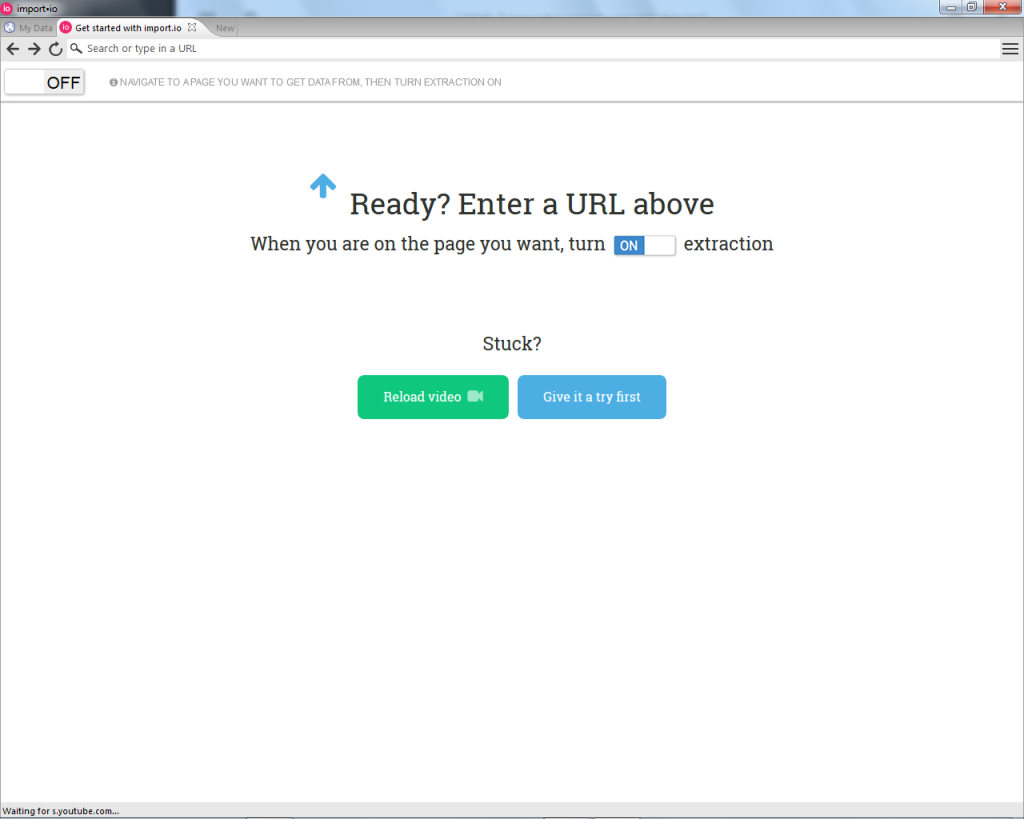

Затем я ввел адрес своего блога в строку URL, а затем включил извлечение, чтобы начать создание своего API.

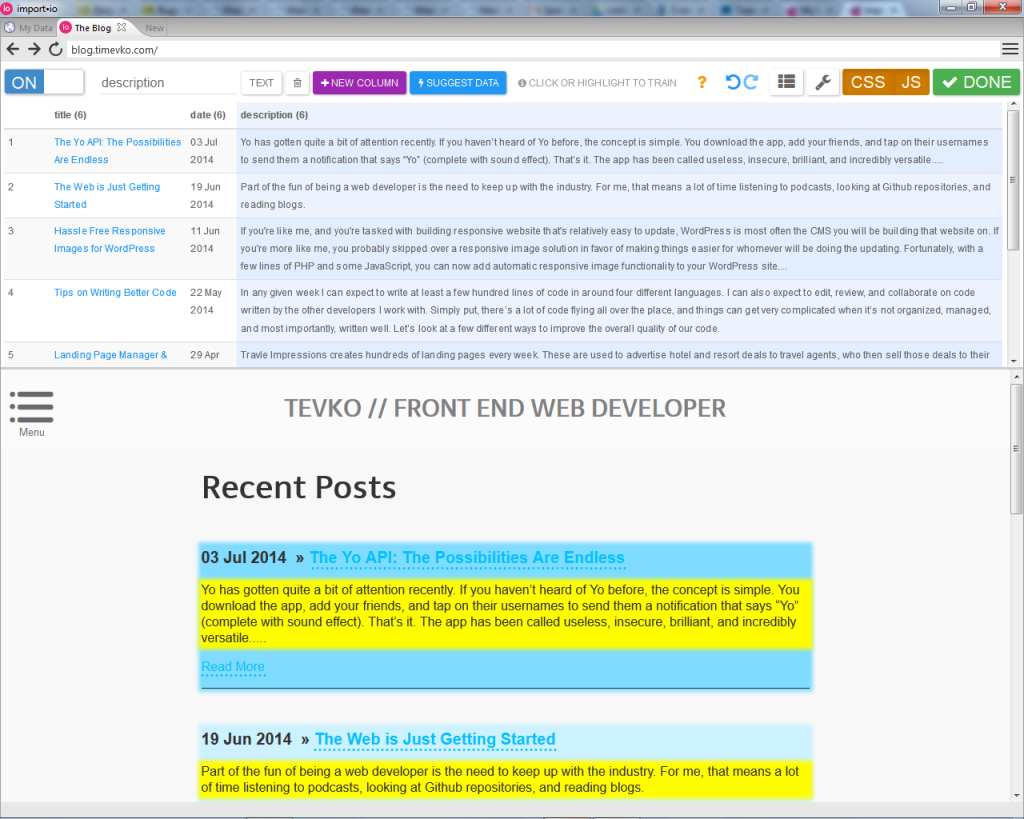

В качестве примечания, еще одна замечательная функция, предлагаемая import.io, — это возможность включать или отключать поддержку JavaScript в случае, если вам нужно собрать данные из приложения, запускаемого JavaScript. Оттуда создание таблицы данных было так же просто, как навигация по простому интерфейсу «укажи и щелкни», в котором я сообщил приложению, сколько строк должно быть в таблице (одна строка или несколько), и щелкнул нужные данные. как я назвал столбец, он должен был быть помещен. Впечатляющая часть была в том, что приложение правильно предсказало, где находятся остальные необходимые мне данные, и мне не нужно было указывать, где находится следующий пост, заголовок, дата или описание. было бы. import.io не только собирает данные, но и предсказывает, где будут находиться ваши данные, и настраивается, когда местоположение данных изменяется на странице.

После того, как все данные были на месте, я нажал «Готово» и вернулся в раздел «Мои данные» приложения, где я мог редактировать, реализовывать и экспортировать свои данные по мере необходимости. Вы можете экспортировать данные несколькими способами, включая JSON, TSV или Google Sheets.

Вот пример автоматически сгенерированного кода JSON из моей коллекции данных Recent Posts:

{ "title": "http://blog.timevko.com/2014/07/03/yo-possibilities-endless", "title/_text": "The Yo API: The Possibilities Are Endless", "description": "Yo has gotten quite a bit of attention recently. If you haven't heard of Yo before, the concept is simple. You download the app, add your friends, and tap on their usernames to send them a notification that says “Yo” (complete with sound effect). That's it. The app has been called useless, insecure, brilliant, and incredibly versatile.....", "date": "03 Jul 2014", "title/_source": "/2014/07/03/yo-possibilities-endless" }

Использование import.io для создания этого быстрого сбора данных заняло у меня всего пять минут, и это было совершенно точно. Лучшая часть? Я не заплатил ни копейки. import.io бесплатен для пожизненного использования, а также имеет возможность для корпоративных решений.

Итак, теперь мы знаем, как легко собирать и использовать данные со всей сети, какие еще интересные вещи мы можем с этим сделать?

1. Создайте приложение, которое находит посетителей рядом с вами

Допустим, что поздняя ночь, вы в Нью-Йорке, вы голодны и вам действительно нравятся посетители. Что вы делаете, если вы хотите найти несколько рядом с вами, которые все еще открыты? Используя import.io, вы можете создать веб-приложение, которое сделает это за вас! Как это будет работать?

Что ж, мы уже видели, как легко получить наши данные в удобном для использования формате JSON, и Foursquare действительно хорош в поиске 24-часовых посетителей в Нью-Йорке. Таким образом, мы могли бы использовать import.io для сбора всей информации о посетителях, а затем создать простой интерфейс, который перечисляет посетителей, ближайших к нашему текущему местоположению на карте, с помощью API Карт Google и API геолокации, предоставляемого браузер.

Если это звучит хорошо, чтобы быть правдой, не бойся! Подобный проект уже был создан с помощью import.io, и он работал настолько хорошо, что ему посвятили целый пост в блоге !

2. Получить статистику на вашем любимом сайте

SitePoint публикует много статей каждый день. Как мы можем получить статистику по этим статьям, а также их наиболее распространенную тему, среднее количество комментариев и самых частых авторов?

Нашим первым шагом было бы создать веб-сканер, процесс которого подробно описан здесь . Затем мы могли бы экспортировать данные, предоставленные нашим сканером, в формате JSON и использовать javascript для создания набора функций, который помещает URL-адреса, номера счетчиков комментариев, имена авторов и т. Д. В массивы и возвращает либо среднее значение счетчиков, либо темы и имена авторов, которые появляются чаще всего.

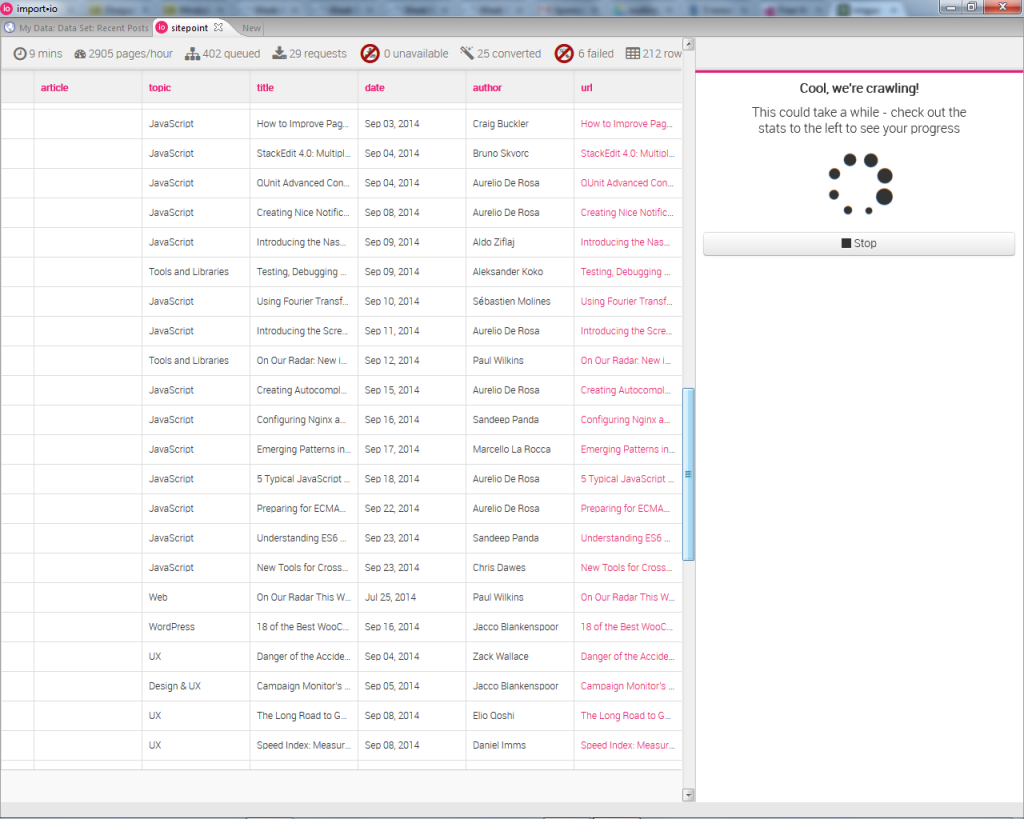

Я настроил образец сканера, чтобы продемонстрировать это, и процесс прошел быстро и без проблем.

Вот пример кода, который использует некоторые данные JSON из моего сканера Sitepoint, чтобы перечислить несколько самых последних (на тот момент) статей на сайте.

Посмотрите статистику поиска продуктов , которая использует веб-сканер import.io для получения пользовательских данных из поиска продуктов .

3. Фрилансеры, ведите

Вы фрилансер? Вы ищете больше бизнеса? Конечно же. import.io может сканировать веб-сайты, чтобы находить людей и компании, которые ищут предлагаемые вами услуги, и сохранять их контактную информацию в электронной таблице. Использовать эту информацию так же просто, как отправить электронное письмо каждому из людей или компаний в электронной таблице. У import.io есть запись в блоге, которая объясняет этот процесс . Их лучший совет: убедитесь, что отправленные вами сообщения являются личными. Никто не любит автоматическую электронную почту!

4. Сделайте крутые диаграммы и графики

Зачем делать крутые графики и графики, которые вы спрашиваете? Классные диаграммы и графики — это отличная возможность поразить посетителей вашего портфолио, помочь вам изучить новые библиотеки, такие как d3.js, или похвастаться перед друзьями-разработчиками!

Data Press недавно использовала import.io для этой цели, и результаты впечатляют! Они использовали MetaCritic и информацию о результатах поиска для сбора данных о музыкальных фестивалях и выступлениях на них. Как только все данные были собраны, они импортировали данные в Tableau для создания визуализации, встроенной ниже.

5. Создайте вирусный контент и измените мир

import.io создал набор данных со всеми мужчинами и женщинами, перечисленными в списке Forbes «Миллиардеры мира» . Затем они передали эти данные Oxfam , который использовал эти данные, чтобы найти более глубокие отношения между теми, кто в достатке, и теми, кому повезло меньше. The Guardian понял это и использовал полученные данные, чтобы написать интересную статью о бедности в Британии. Вы можете прочитать больше о наборе данных и Oxfam в блоге import.io .

Вывод

Данные есть везде, но трудности в сборе и организации часто мешают нам использовать их в своих интересах. С помощью import.io головные боли при поиске и использовании больших наборов данных исчезли. Теперь создание API-интерфейсов, обход контента в Интернете и использование автоматизации для сбора данных из аутентифицированного источника — это всего лишь один шаг.

Переход к вам: что бы вы создали на основе легко агрегируемых веб-данных?