Если вы программист, дизайнер пользовательского интерфейса, контент-менеджер или маркетолог в малом и среднем бизнесе, скорее всего, одна из ваших задач — « убедиться, что веб-страницы на нашем сайте являются поисковыми системами оптимизирован ».

На самом деле, во многих случаях программистам поручается «проверять» веб-сайт на соответствие SEO передовой практике. Или это может быть дизайнер, которому «повезло», чтобы справиться с этой задачей.

Я хотел бы помочь многим, кто борется с проблемами времени и регулярными аудитами SEO. Я предоставлю простые советы о том, какие инструменты использовать и на что обратить внимание, чтобы как можно быстрее провести аудит SEO. Но имейте в виду, что если вы хотите копать глубже, когда обнаружите проблему (или возможность), это займет намного больше часа.

Есть несколько инструментов торговли, которые могут быть использованы для этой цели:

— Инструменты SEOmoz (платные) — базовые версии бесплатны, но вам понадобится доступ к платной версии, чтобы иметь возможность настроить сканирование.

— Xenu Link Sleuth (бесплатно) — раньше это был мой любимый инструмент для сканирования, но, хотя он очень быстр в поиске неработающих ссылок на сайте, ему не хватает SEO отчетности и анализа.

Screaming Frog (бесплатно и за плату) — это поисковый робот, который делает больше, чем Xenu, но бесплатная версия ограничена 500 URL-адресами, которые в настоящее время могут быть блогом WordPress с несколькими постами и изображениями. Многие оптимизаторы очень довольны этим, но это потому, что они не знают о следующем пункте в списке.

— IIS SEO Toolkit от Microsoft (бесплатно) — это настоящая скрытая жемчужина, о которой мало кто знает или о которой говорят SEO. Это сканер рабочего стола и SEO-анализатор, который сканирует сайты, от маленьких до больших (до 50 тыс. URL, если ваша система может справиться с этим). Многие, вероятно, не используют его, потому что думают, что им нужен сайт, построенный на ASP, но это не так. Вы можете запустить этот инструмент на любом URL там. Я очень рекомендую этот инструмент для всех, кто связан с SEO. Вы даже можете установить это на Windows 8.

Мне нравится начинать свой анализ с 10 000-футового обзора SEO-видимости веб-сайта с помощью Search Metrics . Я делаю это, чтобы проверить, есть ли какие-либо большие органические проблемы видимости. Показатель видимости SEO состоит из объема поиска и позиции ранжирования ключевых слов и не совпадает с трафиком сайта. Это, однако, хороший инструмент для определения тенденций и штрафов.

Пингвин сильно клевал на этом сайте.

Выявление локальных проблем SEO

Первое, что я ищу, это файл robots.txt

— Если есть какие-либо страницы, которые заблокированы (иногда могут быть ошибки, которые блокируют все сайты / каталоги от сканирования и индексации).

— что каждая директива блока является правильной и преднамеренной.

— Синтаксис с этим инструментом .

Второе, что нужно искать, это файл sitemap.xml Если вы делаете это для своего сайта, вы знаете, где найти файл. Если вы смотрите на своих конкурентов, вы можете найти путь к этому файлу в файле robots.txt Или просто добавьте «sitemap.xml» после косой черты доменного имени. Запустите файл через этот инструмент, чтобы увидеть, есть ли какие-либо ошибки.

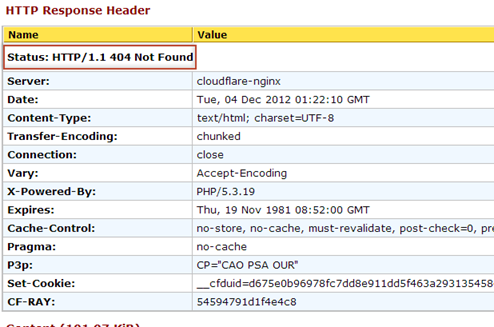

В-третьих, я проверяю ответ заголовка для домашней страницы отдельно, используя http://web-sniffer.net/ .

Страница 404 для домашней страницы совсем не хороша.

В большинстве случаев код ответа должен быть либо 200OK, либо 301 — перемещено навсегда. Если нет, то вам нужно начать задавать вопросы.

Крупномасштабные проблемы

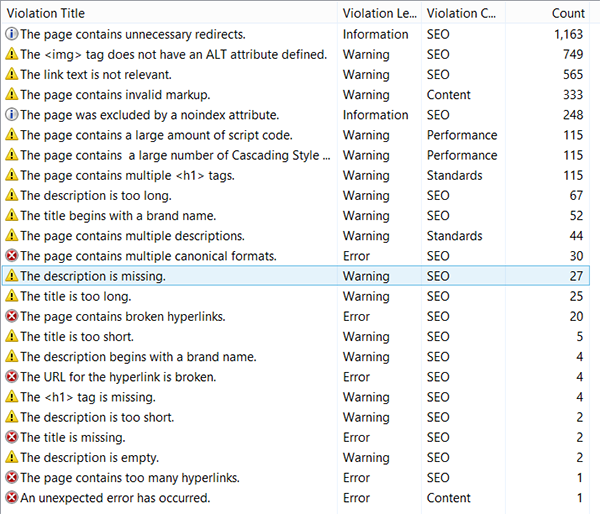

Для меня самый быстрый способ выявить проблемы SEO на всем веб-сайте — это сканировать его по требованию с моего локального компьютера с помощью IIS SEO Toolkit. После того, как вы установили его (и возможные зависимости), настройте новый обход до 10 тыс. Страниц на своем сайте. Когда сканирование завершено, подождите минуту, пока не будет выполнен анализ, а затем начните исправлять ошибки.

Это много ошибок, значит много работы.

Посмотрите на следующие отчеты:

— Содержание: сводка кода состояния (вы хотите увидеть 200 и 301)

— Контент: страницы с неработающими ссылками (неработающие ссылки означают нарушенный PR-поток)

— Содержание: дублирующиеся заголовки (Найдя дублирующиеся URL-адреса, используйте инструмент Similarity Analyzer по адресу http://tool.motoricerca.info/s Similarity- analyzer.phtml ).

— Содержание: Резюме каталога (интересно оценить таксономию вашего сайта)

— Ссылки: глубина ссылки (более четырех уровней глубины не рекомендуется)

Кроме того, важно взглянуть на якорный текст, используемый для связи страниц на вашем сайте. Чтобы получить это, вам нужно запустить запрос новой ссылки с панели инструментов . В качестве имени поля используйте «Текст ссылки», для оператора выберите « Содержит» и оставьте поле « Значение» пустым. Затем сгруппируйте по тексту ссылки .

20 000 пустых якорей не очень хорошая вещь для внутренних ссылок.

Вот так вы проводите часовой аудит любого веб-сайта. Но как только вы выявите какие-либо проблемы, их решение может занять значительно больше времени.

Как только вы сделаете вышеупомянутое, дайте мне знать, если вы были удивлены своими выводами.

Увидимся на вершине!