Первоначально Предоставленная Christain С. Perone

Читайте первую часть этого урока: извлечение текста функции (тс-IDF) — Часть I .

Этот пост является продолжением первой части, где мы начали изучать теорию и практику о выделении текстовых объектов и представлении модели векторного пространства. Я действительно рекомендую вам прочитать первую часть серии постов, чтобы следовать этому второму посту.

Так как первая часть этого урока понравилась многим, эта вторая часть немного длиннее первой.

Вступление

В первом посте мы узнали, как использовать термин-частота для представления текстовой информации в векторном пространстве. Тем не менее, основная проблема, связанная с частотно-частотным подходом, состоит в том, что он расширяет частые термины и уменьшает редкие термины, которые эмпирически более информативны, чем высокочастотные термины. Основная интуиция заключается в том, что термин, который часто встречается во многих документах, не является хорошим различителем и действительно имеет смысл (по крайней мере, во многих экспериментальных тестах); важный вопрос здесь: почему бы вам, например, в проблеме классификации выделить термин, который почти присутствует во всем корпусе ваших документов?

Вес tf-idf решает эту проблему. То, что дает tf-idf, это то, насколько важно слово для документа в коллекции, и поэтому tf-idf включает в себя локальные и глобальные параметры, потому что он учитывает не только изолированный термин, но и термин в пределах коллекции документов. Что делает tf-idf для решения этой проблемы, так это сокращает частые термины и увеличивает редкие; термин, встречающийся в 10 раз чаще, чем другой, не в 10 раз важнее, поэтому для этого tf-idf использует логарифмическую шкалу.

Но давайте вернемся к нашему определению,

Чтобы преодолеть эту проблему, термин частота

Вектор нормализации

Предположим, мы собираемся нормализовать вектор частот-слагаемых,

d4: We can see the shining sun, the bright sun.

И представление векторного пространства с использованием ненормализованной частоты-члена этого документа было:

Для нормализации вектора, такое же , как вычисления единичного вектора вектора, и они обозначаются с помощью «хет» обозначения:

Где

Единичный вектор на самом деле является не чем иным, как нормализованной версией вектора, это вектор, длина которого равна 1.

Источник: http://processing.org/learning/pvector/

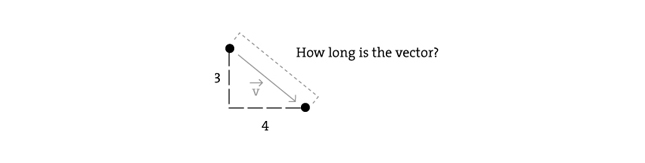

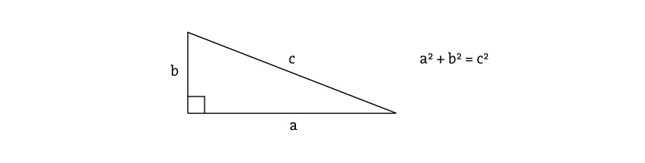

Но важный вопрос здесь заключается в том, как рассчитывается длина вектора, и чтобы понять это, вы должны понять мотивацию

Пространства Лебега

Источник: http://processing.org/learning/pvector/

Обычно длина вектора

Источник: http://processing.org/learning/pvector/

Но это не единственный способ определить длину, и поэтому вы видите (иногда) число

и упрощается как:

Поэтому, когда вы читаете о L2-норме , вы читаете о евклидовой норме , норме с

Когда вы читаете о норме L1 , вы читаете о норме с помощью

Что является не более чем простой суммой компонентов вектора, также известного как расстояние такси , также называемое расстоянием Манхэттена.

Геометрия такси по сравнению с евклидовым расстоянием: в геометрии такси все три изображенные линии имеют одинаковую длину (12) для одного и того же маршрута. В евклидовой геометрии зеленая линия имеет длину

Источник: Википедия :: Таксиаб Геометрия

Обратите внимание, что вы также можете использовать любую норму для нормализации вектора, но мы собираемся использовать наиболее распространенную норму, L2-Norm, которая также используется по умолчанию в выпуске 0.9 файла scikits.learn . Вы также можете найти документы, сравнивающие эффективность двух подходов среди других методов для нормализации вектора документа, фактически вы можете использовать любой другой метод, но вы должны быть краткими, как только вы используете норму, вы должны использовать ее для весь процесс напрямую связан с нормой ( единичный вектор, который использовал L1-норму, не будет иметь длины 1, если вы собираетесь взять его L2-норму позже ).

Вернуться к векторной нормализации

Теперь, когда вы знаете, что такое процесс нормализации вектора, мы можем попробовать конкретный пример — процесс использования L2-нормы (теперь мы будем использовать правильные термины), чтобы нормализовать наш вектор

И это все! Наш нормализованный вектор

Обратите внимание, что здесь мы нормализовали наш вектор частоты документа термина, но позже мы собираемся сделать это после вычисления tf-idf.

Термин частота — обратная частота документа (tf-idf) вес

Теперь, когда вы поняли, как нормализация вектора работает в теории и на практике, давайте продолжим наше руководство. Предположим, у вас есть следующие документы в вашей коллекции (взяты из первой части урока):

Train Document Set: d1: The sky is blue. d2: The sun is bright. Test Document Set: d3: The sun in the sky is bright. d4: We can see the shining sun, the bright sun.

Документ пространство может быть определено то , как ,

Посмотрим теперь, как тогда определяется idf (частота обратных документов):

где

Формула для tf-idf имеет вид:

и эта формула имеет важное следствие: высокий вес вычисления tf-idf достигается, когда у вас есть высокая частота термина (tf) в данном документе ( локальный параметр ) и низкая частота документа термина во всей коллекции ( глобальный параметр ).

Теперь давайте вычислим idf для каждого объекта, присутствующего в матрице объектов, с помощью частоты, которую мы вычислили в первом уроке:

Так как мы имеем 4 функции, мы должны вычислить

Эти веса IDF могут быть представлены вектором как:

Now that we have our matrix with the term frequency (

and then multiply it to the term frequency matrix, so the final result can be defined then as:

Please note that the matrix multiplication isn’t commutative, the result of

Let’s see now a concrete example of this multiplication:

And finally, we can apply our L2 normalization process to the

And that is our pretty normalized tf-idf weight of our testing document set, which is actually a collection of unit vectors. If you take the L2-norm of each row of the matrix, you’ll see that they all have a L2-norm of 1.

Python practice

Environment Used: Python v.2.7.2, Numpy 1.6.1, Scipy v.0.9.0, Sklearn (Scikits.learn) v.0.9.

Now the section you were waiting for ! In this section I’ll use Python to show each step of the tf-idf calculation using the Scikit.learn feature extraction module.

The first step is to create our training and testing document set and computing the term frequency matrix:

from sklearn.feature_extraction.text import CountVectorizer

train_set = ("The sky is blue.", "The sun is bright.")

test_set = ("The sun in the sky is bright.",

"We can see the shining sun, the bright sun.")

count_vectorizer = CountVectorizer()

count_vectorizer.fit_transform(train_set)

print "Vocabulary:", count_vectorizer.vocabulary

# Vocabulary: {'blue': 0, 'sun': 1, 'bright': 2, 'sky': 3}

freq_term_matrix = count_vectorizer.transform(test_set)

print freq_term_matrix.todense()

#[[0 1 1 1]

#[0 2 1 0]]

Now that we have the frequency term matrix (called freq_term_matrix), we can instantiate the TfidfTransformer, which is going to be responsible to calculate the tf-idf weights for our term frequency matrix:

from sklearn.feature_extraction.text import TfidfTransformer tfidf = TfidfTransformer(norm="l2") tfidf.fit(freq_term_matrix) print "IDF:", tfidf.idf_ # IDF: [ 0.69314718 -0.40546511 -0.40546511 0. ]

Note that I’ve specified the norm as L2, this is optional (actually the default is L2-norm), but I’ve added the parameter to make it explicit to you that it it’s going to use the L2-norm. Also note that you can see the calculated idf weight by accessing the internal attribute called idf_. Now that fit() method has calculated the idf for the matrix, let’s transform the freq_term_matrix to the tf-idf weight matrix:

tf_idf_matrix = tfidf.transform(freq_term_matrix) print tf_idf_matrix.todense() # [[ 0. -0.70710678 -0.70710678 0. ] # [ 0. -0.89442719 -0.4472136 0. ]]

And that is it, the tf_idf_matrix is actually our previous

I really hope you liked the post, I tried to make it simple as possible even for people without the required mathematical background of linear algebra, etc. In the next Machine Learning post I’m expecting to show how you can use the tf-idf to calculate the cosine similarity.

If you liked it, feel free to comment and make suggestions, corrections, etc.

References

Understanding Inverse Document Frequency: on theoretical arguments for IDF

The classic Vector Space Model

Sklearn text feature extraction code

Updates

Added the info about the environment used for Python examples