Аналитика больших данных — обзор

За последнее десятилетие объем данных, с которыми приходится иметь дело, взорвался до невообразимых уровней, и в то же время стоимость хранения данных систематически снижалась. Частные компании и исследовательские учреждения собирают терабайты данных о взаимодействиях своих пользователей, бизнесе, социальных сетях, а также датчики с таких устройств, как мобильные телефоны и автомобили. Задача этой эпохи состоит в том, чтобы разобраться в этом море данных. Здесь аналитика больших данных входит в картину.

Big Data Analytics в основном включает сбор данных из разных источников, изменение их таким образом, чтобы они стали доступными для использования аналитиками, и, наконец, предоставление продуктов данных, полезных для бизнеса организации.

Процесс преобразования больших объемов неструктурированных необработанных данных, полученных из разных источников, в продукт данных, полезный для организаций, составляет ядро Big Data Analytics.

Аналитика больших данных — жизненный цикл данных

Традиционный жизненный цикл интеллектуального анализа данных

Чтобы обеспечить основу для организации работы, необходимой для организации, и предоставить четкое представление о больших данных, полезно рассматривать ее как цикл с различными этапами. Это ни в коем случае не линейно, то есть все этапы связаны друг с другом. Этот цикл имеет поверхностное сходство с более традиционным циклом интеллектуального анализа данных, как описано в методологии CRISP .

Методология CRISP-DM

Методология CRISP-DM , обозначающая межотраслевой стандартный процесс интеллектуального анализа данных, представляет собой цикл, описывающий часто используемые подходы, используемые экспертами по интеллектуальному анализу данных для решения проблем в традиционном интеллектуальном анализе данных BI. Он все еще используется в традиционных командах интеллектуального анализа данных.

Посмотрите на следующую иллюстрацию. Он показывает основные этапы цикла, описанные методологией CRISP-DM, и их взаимосвязь.

CRISP-DM был задуман в 1996 году, а в следующем году он был реализован как проект Европейского Союза в рамках инициативы финансирования ESPRIT. Проект возглавляли пять компаний: SPSS, Teradata, Daimler AG, NCR Corporation и OHRA (страховая компания). Проект был наконец включен в SPSS. Методология чрезвычайно детально ориентирована на то, как должен быть определен проект интеллектуального анализа данных.

Давайте теперь узнаем немного больше о каждом из этапов жизненного цикла CRISP-DM —

-

Понимание бизнеса — на этом начальном этапе основное внимание уделяется пониманию целей и требований проекта с точки зрения бизнеса, а затем преобразованию этих знаний в определение проблемы интеллектуального анализа данных. Предварительный план предназначен для достижения целей. Можно использовать модель принятия решений, особенно модель, построенную с использованием модели принятия решений и стандарта обозначений.

-

Понимание данных. Фаза понимания данных начинается с первоначального сбора данных и продолжается действиями, чтобы ознакомиться с данными, выявить проблемы с качеством данных, обнаружить первое понимание данных или обнаружить интересные подмножества, чтобы сформировать гипотезы для скрытого Информация.

-

Подготовка данных. Этап подготовки данных охватывает все действия по построению окончательного набора данных (данных, которые будут вводиться в инструмент (ы) моделирования) из исходных необработанных данных. Задачи подготовки данных, вероятно, будут выполняться несколько раз, а не в каком-либо предписанном порядке. Задачи включают выбор таблиц, записей и атрибутов, а также преобразование и очистку данных для инструментов моделирования.

-

Моделирование — на этом этапе выбираются и применяются различные методы моделирования, а их параметры калибруются до оптимальных значений. Как правило, существует несколько методов для одного и того же типа проблемы интеллектуального анализа данных. Некоторые методы предъявляют особые требования к форме данных. Поэтому часто требуется вернуться к этапу подготовки данных.

-

Оценка — на этом этапе проекта вы создали модель (или модели), которая, по-видимому, имеет высокое качество с точки зрения анализа данных. Прежде чем приступить к окончательному развертыванию модели, важно тщательно оценить модель и рассмотреть шаги, выполненные для построения модели, чтобы убедиться, что она правильно достигает бизнес-целей.

Основная цель — определить, существует ли какая-то важная бизнес-проблема, которая не была в достаточной мере рассмотрена. В конце этого этапа должно быть принято решение об использовании результатов интеллектуального анализа данных.

-

Развертывание — создание модели, как правило, не является концом проекта. Даже если целью модели является повышение знаний о данных, полученные знания необходимо будет организовать и представить так, чтобы это было полезно для клиента.

В зависимости от требований фаза развертывания может быть такой же простой, как создание отчета, или такой сложной, как реализация повторяющейся оценки данных (например, распределение сегментов) или процесса интеллектуального анализа данных.

Понимание бизнеса — на этом начальном этапе основное внимание уделяется пониманию целей и требований проекта с точки зрения бизнеса, а затем преобразованию этих знаний в определение проблемы интеллектуального анализа данных. Предварительный план предназначен для достижения целей. Можно использовать модель принятия решений, особенно модель, построенную с использованием модели принятия решений и стандарта обозначений.

Понимание данных. Фаза понимания данных начинается с первоначального сбора данных и продолжается действиями, чтобы ознакомиться с данными, выявить проблемы с качеством данных, обнаружить первое понимание данных или обнаружить интересные подмножества, чтобы сформировать гипотезы для скрытого Информация.

Подготовка данных. Этап подготовки данных охватывает все действия по построению окончательного набора данных (данных, которые будут вводиться в инструмент (ы) моделирования) из исходных необработанных данных. Задачи подготовки данных, вероятно, будут выполняться несколько раз, а не в каком-либо предписанном порядке. Задачи включают выбор таблиц, записей и атрибутов, а также преобразование и очистку данных для инструментов моделирования.

Моделирование — на этом этапе выбираются и применяются различные методы моделирования, а их параметры калибруются до оптимальных значений. Как правило, существует несколько методов для одного и того же типа проблемы интеллектуального анализа данных. Некоторые методы предъявляют особые требования к форме данных. Поэтому часто требуется вернуться к этапу подготовки данных.

Оценка — на этом этапе проекта вы создали модель (или модели), которая, по-видимому, имеет высокое качество с точки зрения анализа данных. Прежде чем приступить к окончательному развертыванию модели, важно тщательно оценить модель и рассмотреть шаги, выполненные для построения модели, чтобы убедиться, что она правильно достигает бизнес-целей.

Основная цель — определить, существует ли какая-то важная бизнес-проблема, которая не была в достаточной мере рассмотрена. В конце этого этапа должно быть принято решение об использовании результатов интеллектуального анализа данных.

Развертывание — создание модели, как правило, не является концом проекта. Даже если целью модели является повышение знаний о данных, полученные знания необходимо будет организовать и представить так, чтобы это было полезно для клиента.

В зависимости от требований фаза развертывания может быть такой же простой, как создание отчета, или такой сложной, как реализация повторяющейся оценки данных (например, распределение сегментов) или процесса интеллектуального анализа данных.

Во многих случаях именно заказчик, а не аналитик данных, будет выполнять этапы развертывания. Даже если аналитик развертывает модель, для клиента важно заранее понять действия, которые необходимо будет выполнить для фактического использования созданных моделей.

Методология SEMMA

SEMMA — это еще одна методология, разработанная SAS для моделирования интеллектуального анализа данных. Он обозначает S достаточно, E xplore, M odify, M odel и A sses. Вот краткое описание его этапов —

-

Выборка — процесс начинается с выборки данных, например, с выбора набора данных для моделирования. Набор данных должен быть достаточно большим, чтобы содержать достаточную информацию для извлечения, но достаточно маленьким, чтобы его можно было эффективно использовать. Этот этап также касается разделения данных.

-

Исследовать — Эта фаза охватывает понимание данных путем обнаружения ожидаемых и непредвиденных связей между переменными, а также отклонений с помощью визуализации данных.

-

Modify — фаза Modify содержит методы для выбора, создания и преобразования переменных при подготовке к моделированию данных.

-

Модель. На этапе модели основное внимание уделяется применению различных методов моделирования (интеллектуального анализа данных) к подготовленным переменным с целью создания моделей, которые могут обеспечить желаемый результат.

-

Оценка — Оценка результатов моделирования показывает надежность и полезность созданных моделей.

Выборка — процесс начинается с выборки данных, например, с выбора набора данных для моделирования. Набор данных должен быть достаточно большим, чтобы содержать достаточную информацию для извлечения, но достаточно маленьким, чтобы его можно было эффективно использовать. Этот этап также касается разделения данных.

Исследовать — Эта фаза охватывает понимание данных путем обнаружения ожидаемых и непредвиденных связей между переменными, а также отклонений с помощью визуализации данных.

Modify — фаза Modify содержит методы для выбора, создания и преобразования переменных при подготовке к моделированию данных.

Модель. На этапе модели основное внимание уделяется применению различных методов моделирования (интеллектуального анализа данных) к подготовленным переменным с целью создания моделей, которые могут обеспечить желаемый результат.

Оценка — Оценка результатов моделирования показывает надежность и полезность созданных моделей.

Основное различие между CRISM-DM и SEMMA заключается в том, что SEMMA фокусируется на аспекте моделирования, тогда как CRISP-DM придает большее значение этапам цикла, предшествующим моделированию, таким как понимание бизнес-проблемы, подлежащей решению, понимание и предварительная обработка данных, подлежащих обработке. используется в качестве входных данных, например, алгоритмы машинного обучения.

Жизненный цикл больших данных

В сегодняшнем контексте больших данных предыдущие подходы являются либо неполными, либо неоптимальными. Например, методология SEMMA полностью игнорирует сбор данных и предварительную обработку различных источников данных. Эти этапы обычно составляют большую часть работы в успешном проекте больших данных.

Большой цикл анализа данных может быть описан следующим этапом —

- Определение бизнес-проблемы

- Исследование

- Оценка человеческих ресурсов

- Получение данных

- Data Munging

- Хранилище данных

- Исследовательский анализ данных

- Подготовка данных для моделирования и оценки

- моделирование

- Реализация

В этом разделе мы расскажем о каждом из этих этапов жизненного цикла больших данных.

Определение бизнес-проблемы

Это обычное явление в традиционном жизненном цикле BI и аналитики больших данных. Обычно это нетривиальный этап проекта больших данных, чтобы определить проблему и правильно оценить, какой потенциальный выигрыш он может принести для организации. Кажется очевидным упомянуть об этом, но необходимо оценить, каковы ожидаемые выгоды и затраты по проекту.

Исследование

Проанализируйте, что другие компании сделали в такой же ситуации. Это включает в себя поиск решений, которые являются разумными для вашей компании, даже если это включает в себя адаптацию других решений к ресурсам и требованиям, которые есть у вашей компании. На этом этапе следует определить методологию будущих этапов.

Оценка человеческих ресурсов

Как только проблема будет определена, целесообразно продолжить анализ того, сможет ли текущий персонал успешно завершить проект. Традиционные команды BI могут быть не в состоянии предоставить оптимальное решение для всех этапов, поэтому следует рассмотреть это перед началом проекта, если есть необходимость передать часть проекта на аутсорсинг или нанять больше людей.

Получение данных

Этот раздел является ключевым в жизненном цикле больших данных; он определяет, какой тип профилей потребуется для доставки итогового продукта данных. Сбор данных является нетривиальным шагом процесса; обычно он включает сбор неструктурированных данных из разных источников. В качестве примера можно привести написание сканера для получения отзывов с веб-сайта. Это включает в себя работу с текстом, возможно, на разных языках, обычно требующих значительного времени для завершения.

Data Munging

Когда данные извлекаются, например, из Интернета, они должны храниться в удобном для использования формате. Чтобы продолжить с примерами обзоров, давайте предположим, что данные извлекаются с разных сайтов, каждый из которых по-разному отображает данные.

Предположим, что один источник данных дает обзоры с точки зрения рейтинга в звездах, поэтому его можно считать отображением для переменной отклика y ∈ {1, 2, 3, 4, 5} . Другой источник данных дает обзоры с использованием системы двух стрелок, одна для голосования «за», а другая для голосования «за». Это подразумевало бы переменную ответа вида y ∈ {положительный, отрицательный} .

Чтобы объединить оба источника данных, необходимо принять решение, чтобы сделать эти два представления ответов эквивалентными. Это может включать преобразование первого отклика представления источника данных во вторую форму, считая одну звезду отрицательной и пять звезд положительной. Этот процесс часто требует больших временных затрат для обеспечения хорошего качества.

Хранилище данных

Как только данные обработаны, их иногда необходимо сохранить в базе данных. Технологии больших данных предлагают множество альтернатив в этом отношении. Наиболее распространенной альтернативой является использование файловой системы Hadoop для хранения, которая предоставляет пользователям ограниченную версию SQL, известную как язык запросов HIVE. Это позволяет выполнять большинство задач аналитики аналогично тому, как это делается в традиционных хранилищах данных BI, с точки зрения пользователя. Другими вариантами хранения, которые следует учитывать, являются MongoDB, Redis и SPARK.

Эта стадия цикла связана со знаниями человеческих ресурсов с точки зрения их способности реализовывать различные архитектуры. Модифицированные версии традиционных хранилищ данных все еще используются в крупномасштабных приложениях. Например, teradata и IBM предлагают базы данных SQL, которые могут обрабатывать терабайты данных; Решения с открытым исходным кодом, такие как postgreSQL и MySQL, все еще используются для крупномасштабных приложений.

Несмотря на различия в работе различных хранилищ в фоновом режиме, на стороне клиента большинство решений предоставляют SQL API. Следовательно, хорошее понимание SQL по-прежнему является ключевым навыком для анализа больших данных.

Этот этап априори представляется наиболее важной темой, на практике это не так. Это даже не существенная стадия. Можно реализовать решение для больших данных, которое будет работать с данными в реальном времени, поэтому в этом случае нам нужно только собрать данные для разработки модели, а затем реализовать ее в режиме реального времени. Таким образом, не было бы необходимости формально хранить данные вообще.

Исследовательский анализ данных

После того, как данные были очищены и сохранены таким образом, что из них можно извлечь информацию, фаза исследования данных является обязательной. Целью этого этапа является понимание данных, обычно это делается с помощью статистических методов, а также построения графиков данных. Это хороший этап для оценки того, имеет ли определение проблемы смысл или выполнимость.

Подготовка данных для моделирования и оценки

Этот этап включает изменение предварительно очищенных данных, полученных ранее, и использование статистической предварительной обработки для определения пропущенных значений, обнаружения выбросов, нормализации, выделения признаков и выбора признаков.

моделирование

На предыдущем этапе должно было быть подготовлено несколько наборов данных для обучения и тестирования, например, прогнозирующая модель. Этот этап включает в себя попытки различных моделей и с нетерпением ждем решения проблемы бизнеса под рукой. На практике обычно желательно, чтобы модель дала некоторое представление о бизнесе. И, наконец, выбирается лучшая модель или комбинация моделей, которая оценивает ее производительность в неактивном наборе данных.

Реализация

На данном этапе разработанный продукт данных внедряется в конвейер данных компании. Это включает в себя настройку схемы проверки во время работы продукта данных, чтобы отслеживать его производительность. Например, в случае реализации прогнозирующей модели, этот этап будет включать применение модели к новым данным и, как только ответ будет получен, оцените модель.

Аналитика больших данных — методология

С точки зрения методологии, анализ больших данных значительно отличается от традиционного статистического подхода к планированию эксперимента. Аналитика начинается с данных. Обычно мы моделируем данные таким образом, чтобы объяснить ответ. Задачи этого подхода — предсказать поведение ответа или понять, как входные переменные связаны с ответом. Обычно в статистических экспериментальных планах эксперимент разрабатывается, и в результате извлекаются данные. Это позволяет генерировать данные таким образом, чтобы их можно было использовать в статистической модели, где соблюдаются определенные допущения, такие как независимость, нормальность и рандомизация.

В аналитике больших данных нам представляются данные. Мы не можем разработать эксперимент, который соответствует нашей любимой статистической модели. В крупномасштабных аналитических приложениях требуется большой объем работы (обычно 80% усилий) только для очистки данных, поэтому он может использоваться моделью машинного обучения.

У нас нет уникальной методологии, которой нужно следовать в реальных масштабных приложениях. Обычно, как только проблема бизнеса определена, необходим этап исследования для разработки методологии, которая будет использоваться. Тем не менее, общие рекомендации имеют отношение к упоминанию и применимы практически ко всем проблемам.

Одной из наиболее важных задач в анализе больших данных является статистическое моделирование , то есть проблемы с контролируемой и неконтролируемой классификацией или регрессией. После того, как данные очищены и предварительно обработаны, доступны для моделирования, следует позаботиться об оценке различных моделей с приемлемыми показателями потерь, а затем, как только модель будет внедрена, следует сообщать о дальнейшей оценке и результатах. Распространенная ошибка в прогнозном моделировании — просто реализовать модель и никогда не измерять ее производительность.

Аналитика больших данных — основные результаты

Как уже упоминалось в жизненном цикле больших данных, продукты данных, полученные в результате разработки продукта больших данных, в большинстве случаев являются следующими:

-

Реализация машинного обучения — это может быть алгоритм классификации, модель регрессии или модель сегментации.

-

Система рекомендаций — Цель состоит в том, чтобы разработать систему, которая рекомендует выбор на основе поведения пользователя. Netflix является характерным примером этого продукта данных, где на основе оценок пользователей рекомендуются другие фильмы.

-

Панель инструментов — бизнесу обычно нужны инструменты для визуализации агрегированных данных. Панель инструментов — это графический механизм, позволяющий сделать эти данные доступными.

-

Специальный анализ — как правило, в бизнес-сферах есть вопросы, гипотезы или мифы, на которые можно ответить, выполнив специальный анализ с данными.

Реализация машинного обучения — это может быть алгоритм классификации, модель регрессии или модель сегментации.

Система рекомендаций — Цель состоит в том, чтобы разработать систему, которая рекомендует выбор на основе поведения пользователя. Netflix является характерным примером этого продукта данных, где на основе оценок пользователей рекомендуются другие фильмы.

Панель инструментов — бизнесу обычно нужны инструменты для визуализации агрегированных данных. Панель инструментов — это графический механизм, позволяющий сделать эти данные доступными.

Специальный анализ — как правило, в бизнес-сферах есть вопросы, гипотезы или мифы, на которые можно ответить, выполнив специальный анализ с данными.

Аналитика больших данных — ключевые заинтересованные стороны

В крупных организациях для успешного развития проекта с большими данными необходимо, чтобы руководство поддержало проект. Обычно это включает в себя поиск способа показать бизнес-преимущества проекта. У нас нет уникального решения проблемы поиска спонсоров для проекта, но ниже приведены несколько рекомендаций.

-

Узнайте, кто и где является спонсором других проектов, похожих на тот, который вас интересует.

-

Наличие личных контактов на ключевых руководящих должностях помогает, поэтому любой контакт может быть инициирован, если проект перспективен.

-

Кто выиграет от вашего проекта? Кто станет вашим клиентом, как только проект будет запущен?

-

Разработайте простое, понятное и интересное предложение и поделитесь им с ключевыми игроками своей организации.

Узнайте, кто и где является спонсором других проектов, похожих на тот, который вас интересует.

Наличие личных контактов на ключевых руководящих должностях помогает, поэтому любой контакт может быть инициирован, если проект перспективен.

Кто выиграет от вашего проекта? Кто станет вашим клиентом, как только проект будет запущен?

Разработайте простое, понятное и интересное предложение и поделитесь им с ключевыми игроками своей организации.

Лучший способ найти спонсоров для проекта — понять проблему и каков будет конечный продукт данных после его внедрения. Это понимание даст преимущество в убеждении руководства в важности проекта больших данных.

Big Data Analytics — Аналитик данных

Аналитик данных имеет ориентированный на отчетность профиль, имеет опыт извлечения и анализа данных из традиционных хранилищ данных с использованием SQL. Их задачи обычно связаны с хранением данных или с отчетами об общих бизнес-результатах. Хранилище данных отнюдь не просто, оно просто отличается от того, что делает ученый.

Многие организации изо всех сил пытаются найти компетентных специалистов по данным на рынке. Однако хорошей идеей будет отобрать потенциальных аналитиков данных и научить их соответствующим навыкам, чтобы стать специалистом по данным. Это ни в коем случае не является тривиальной задачей и обычно включает в себя человека, получающего степень магистра в количественной области, но это определенно жизнеспособный вариант. Ниже перечислены основные навыки, которыми должен обладать компетентный аналитик данных.

- Понимание бизнеса

- Программирование SQL

- Разработка и реализация отчетов

- Разработка панели инструментов

Аналитика больших данных — Data Scientist

Роль исследователя данных обычно связана с такими задачами, как прогнозирующее моделирование, разработка алгоритмов сегментации, системы рекомендаций, системы A / B-тестирования и часто работа с необработанными неструктурированными данными.

Характер их работы требует глубокого понимания математики, прикладной статистики и программирования. Есть несколько общих навыков между аналитиком данных и ученым, например, умение запрашивать базы данных. Оба анализируют данные, но решение ученого может оказать большее влияние на организацию.

Вот набор навыков, которыми обычно должен обладать ученый данных:

- Программирование в статистическом пакете, таком как: R, Python, SAS, SPSS или Julia

- Возможность очищать, извлекать и исследовать данные из разных источников

- Исследование, разработка и внедрение статистических моделей

- Глубокие статистические, математические и компьютерные знания

В аналитике больших данных люди обычно путают роль ученого с ролью архитектора данных. На самом деле разница довольно проста. Архитектор данных определяет инструменты и архитектуру, в которой будут храниться данные, тогда как ученый использует эту архитектуру. Конечно, специалист по обработке данных должен иметь возможность устанавливать новые инструменты, если это необходимо для специальных проектов, но определение и проектирование инфраструктуры не должны быть частью его задачи.

Аналитика больших данных — определение проблемы

С помощью этого урока мы разработаем проект. Каждая последующая глава в этом руководстве посвящена части более крупного проекта в разделе мини-проекта. Предполагается, что это раздел прикладного учебного пособия, в котором будет рассказано о реальной проблеме. В этом случае мы начнем с определения проблемы проекта.

Описание Проекта

Целью этого проекта будет разработка модели машинного обучения для прогнозирования почасовой заработной платы людей с использованием их биографических данных (CV) в качестве входных данных.

Используя рамки, определенные выше, просто определить проблему. Мы можем определить X = {x 1 , x 2 ,…, x n } как резюме пользователей, где каждая функция может быть самым простым способом, сколько раз это слово появляется. Тогда ответ реально оценен, мы пытаемся прогнозировать почасовую зарплату физических лиц в долларах.

Этих двух соображений достаточно, чтобы сделать вывод, что представленная проблема может быть решена с помощью алгоритма контролируемой регрессии.

Определение проблемы

Определение проблемы — это, вероятно, один из самых сложных и часто игнорируемых этапов в аналитическом конвейере больших данных. Чтобы определить проблему, которую должен решить продукт данных, опыт работы обязателен. У большинства аспирантов-исследователей на этом этапе нет опыта.

Большинство проблем с большими данными можно классифицировать следующими способами:

- Контролируемая классификация

- Контролируемая регрессия

- Неконтролируемое обучение

- Учимся оценивать

Давайте теперь узнаем больше об этих четырех понятиях.

Контролируемая классификация

Учитывая матрицу признаков X = {x 1 , x 2 , …, x n }, мы разрабатываем модель M для прогнозирования различных классов, определенных как y = {c 1 , c 2 , …, c n } . Например: учитывая данные о транзакциях клиентов в страховой компании, можно разработать модель, которая будет прогнозировать, будет ли клиент работать на рынке или нет. Последняя является проблемой двоичной классификации, где есть два класса или целевые переменные: отток и не отток.

Другие проблемы включают предсказание более чем одного класса, мы могли бы быть заинтересованы в распознавании цифр, поэтому вектор ответа будет определяться как: y = {0, 1, 2, 3, 4, 5, 6, 7, 8, 9} Современная модель будет представлять собой сверточную нейронную сеть, а матрица признаков будет определяться как пиксели изображения.

Контролируемая регрессия

В этом случае определение проблемы довольно похоже на предыдущий пример; разница зависит от ответа. В задаче регрессии, ответ y ∈ this, это означает, что ответ является действительным значением. Например, мы можем разработать модель для прогнозирования почасовой зарплаты отдельных лиц с учетом совокупности их резюме.

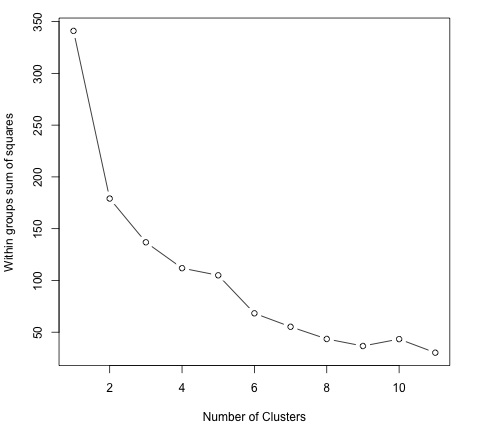

Обучение без учителя

Менеджмент часто жаждет новых идей. Модели сегментации могут предоставить эту информацию, чтобы отдел маркетинга разработал продукты для различных сегментов. Хороший подход к разработке модели сегментации, а не к размышлению об алгоритмах, состоит в выборе функций, которые имеют отношение к желаемой сегментации.

Например, в телекоммуникационной компании интересно сегментировать клиентов по их мобильному телефону. Это может включать игнорирование функций, которые не имеют ничего общего с целью сегментации, и включает только те, которые имеют. В этом случае это будет выбор функций, таких как количество SMS-сообщений, использованных за месяц, количество входящих и исходящих минут и т. Д.

Учимся ранжировать

Эта проблема может рассматриваться как проблема регрессии, но она имеет свои особенности и заслуживает отдельного рассмотрения. Проблема заключается в том, что при наличии набора документов мы стремимся найти наиболее релевантный порядок по запросу. Чтобы разработать контролируемый алгоритм обучения, необходимо пометить, насколько релевантно упорядочение с учетом запроса.

Следует отметить, что для разработки алгоритма обучения под наблюдением необходимо маркировать данные обучения. Это означает, что для обучения модели, которая будет, например, распознавать цифры на изображении, нам нужно вручную пометить значительное количество примеров. Существуют веб-сервисы, которые могут ускорить этот процесс и обычно используемые для этой задачи, такие как amazon механический турок. Доказано, что алгоритмы обучения улучшают свою производительность, когда предоставляют больше данных, поэтому маркировка приличного количества примеров практически обязательна в контролируемом обучении.

Big Data Analytics — Сбор данных

Сбор данных играет важнейшую роль в цикле больших данных. Интернет предоставляет практически неограниченные источники данных по различным темам. Важность этой области зависит от типа бизнеса, но традиционные отрасли могут получать разнообразные источники внешних данных и объединять их со своими транзакционными данными.

Например, предположим, что мы хотели бы создать систему, которая рекомендует рестораны. Первым шагом будет сбор данных, в данном случае обзоров ресторанов с разных сайтов и сохранение их в базе данных. Поскольку мы заинтересованы в необработанном тексте и будем использовать его для аналитики, неважно, где будут храниться данные для разработки модели. Это может показаться противоречивым с основными технологиями больших данных, но для реализации приложения с большими данными нам просто нужно заставить его работать в режиме реального времени.

Twitter Mini Project

Как только проблема определена, следующим этапом является сбор данных. Следующая идея минипроекта состоит в том, чтобы работать над сбором данных из сети и структурированием их для использования в модели машинного обучения. Мы будем собирать некоторые твиты из API остальных Twitter, используя язык программирования R.

Прежде всего создайте учетную запись Twitter, а затем следуйте инструкциям в виньетке пакета twitteR , чтобы создать учетную запись разработчика Twitter. Это краткое изложение этих инструкций —

-

Перейдите на https://twitter.com/apps/new и войдите в систему.

-

После заполнения основной информации перейдите на вкладку «Настройки» и выберите «Чтение, запись и доступ к прямым сообщениям».

-

Убедитесь, что вы нажали на кнопку «Сохранить» после этого

-

На вкладке «Сведения» запишите ключ и секрет клиента.

-

В вашей сессии R вы будете использовать ключ API и секретные значения API

-

Наконец запустите следующий скрипт. Это установит пакет twitteR из его репозитория на github.

Перейдите на https://twitter.com/apps/new и войдите в систему.

После заполнения основной информации перейдите на вкладку «Настройки» и выберите «Чтение, запись и доступ к прямым сообщениям».

Убедитесь, что вы нажали на кнопку «Сохранить» после этого

На вкладке «Сведения» запишите ключ и секрет клиента.

В вашей сессии R вы будете использовать ключ API и секретные значения API

Наконец запустите следующий скрипт. Это установит пакет twitteR из его репозитория на github.

install.packages(c("devtools", "rjson", "bit64", "httr"))

# Make sure to restart your R session at this point

library(devtools)

install_github("geoffjentry/twitteR")

Мы заинтересованы в том, чтобы получить данные, в которые включена строка «big mac», и выяснить, какие темы выделяются по этому поводу. Для этого первым шагом является сбор данных из твиттера. Ниже приведен наш R скрипт для сбора необходимых данных из твиттера. Этот код также доступен в файле bda / part1 / collect_data / collect_data_twitter.R.

rm(list = ls(all = TRUE)); gc() # Clears the global environment library(twitteR) Sys.setlocale(category = "LC_ALL", locale = "C") ### Replace the xxx’s with the values you got from the previous instructions # consumer_key = "xxxxxxxxxxxxxxxxxxxx" # consumer_secret = "xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxx" # access_token = "xxxxxxxxxx-xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxx" # access_token_secret= "xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxx" # Connect to twitter rest API setup_twitter_oauth(consumer_key, consumer_secret, access_token, access_token_secret) # Get tweets related to big mac tweets <- searchTwitter(’big mac’, n = 200, lang = ’en’) df <- twListToDF(tweets) # Take a look at the data head(df) # Check which device is most used sources <- sapply(tweets, function(x) x$getStatusSource()) sources <- gsub("</a>", "", sources) sources <- strsplit(sources, ">") sources <- sapply(sources, function(x) ifelse(length(x) > 1, x[2], x[1])) source_table = table(sources) source_table = source_table[source_table > 1] freq = source_table[order(source_table, decreasing = T)] as.data.frame(freq) # Frequency # Twitter for iPhone 71 # Twitter for Android 29 # Twitter Web Client 25 # recognia 20

Аналитика больших данных — очистка данных

Как только данные собраны, у нас обычно есть различные источники данных с различными характеристиками. Самым непосредственным шагом было бы сделать эти источники данных однородными и продолжать развивать наш продукт данных. Однако это зависит от типа данных. Мы должны спросить себя, целесообразно ли гомогенизировать данные.

Возможно, источники данных совершенно разные, и потеря информации будет большой, если источники будут гомогенизированы. В этом случае мы можем думать об альтернативах. Может ли один источник данных помочь мне построить модель регрессии, а другой — модель классификации? Можно ли работать с неоднородностью на наше преимущество, а не просто терять информацию? Принятие этих решений — вот что делает аналитику интересной и сложной.

В случае обзоров, можно иметь язык для каждого источника данных. Опять же, у нас есть два варианта —

-

Гомогенизация — включает перевод разных языков на язык, на котором у нас больше данных. Качество услуг перевода приемлемо, но если мы хотим перевести большие объемы данных с помощью API, стоимость будет значительной. Для этой задачи доступны программные средства, но это будет слишком дорого.

-

Гетерогенизация — можно ли разработать решение для каждого языка? Так как язык корпуса просто определить, мы могли бы разработать рекомендацию для каждого языка. Это потребовало бы дополнительной работы с точки зрения настройки каждого рекомендателя в соответствии с количеством доступных языков, но, безусловно, является приемлемым вариантом, если у нас есть несколько доступных языков.

Гомогенизация — включает перевод разных языков на язык, на котором у нас больше данных. Качество услуг перевода приемлемо, но если мы хотим перевести большие объемы данных с помощью API, стоимость будет значительной. Для этой задачи доступны программные средства, но это будет слишком дорого.

Гетерогенизация — можно ли разработать решение для каждого языка? Так как язык корпуса просто определить, мы могли бы разработать рекомендацию для каждого языка. Это потребовало бы дополнительной работы с точки зрения настройки каждого рекомендателя в соответствии с количеством доступных языков, но, безусловно, является приемлемым вариантом, если у нас есть несколько доступных языков.

Twitter Mini Project

В данном случае нам нужно сначала очистить неструктурированные данные, а затем преобразовать их в матрицу данных, чтобы применить к ним моделирование тем. В целом, при получении данных из твиттера есть несколько символов, которые нам не нужны, по крайней мере, на первом этапе процесса очистки данных.

Например, после получения твитов мы получаем следующие странные символы: «<ed> <U + 00A0> <U + 00BD> <ed> <U + 00B8> <U + 008B>». Вероятно, это смайлики, поэтому для очистки данных мы просто удалим их, используя следующий скрипт. Этот код также доступен в файле bda / part1 / collect_data / cleaning_data.R.

rm(list = ls(all = TRUE)); gc() # Clears the global environment source('collect_data_twitter.R') # Some tweets head(df$text) [1] "I’m not a big fan of turkey but baked Mac & cheese <ed><U+00A0><U+00BD><ed><U+00B8><U+008B>" [2] "@Jayoh30 Like no special sauce on a big mac. HOW" ### We are interested in the text - Let’s clean it! # We first convert the encoding of the text from latin1 to ASCII df$text <- sapply(df$text,function(row) iconv(row, "latin1", "ASCII", sub = "")) # Create a function to clean tweets clean.text <- function(tx) { tx <- gsub("htt.{1,20}", " ", tx, ignore.case = TRUE) tx = gsub("[^#[:^punct:]]|@|RT", " ", tx, perl = TRUE, ignore.case = TRUE) tx = gsub("[[:digit:]]", " ", tx, ignore.case = TRUE) tx = gsub(" {1,}", " ", tx, ignore.case = TRUE) tx = gsub("^\\s+|\\s+$", " ", tx, ignore.case = TRUE) return(tx) } clean_tweets <- lapply(df$text, clean.text) # Cleaned tweets head(clean_tweets) [1] " WeNeedFeminlsm MAC s new make up line features men woc and big girls " [1] " TravelsPhoto What Happens To Your Body One Hour After A Big Mac "

Последний шаг мини-проекта по очистке данных — очистить текст, который мы можем преобразовать в матрицу, и применить алгоритм. Из текста, хранящегося в векторе clean_tweets, мы можем легко преобразовать его в матрицу пакетов слов и применить алгоритм обучения без присмотра.

Аналитика больших данных — обобщение данных

Отчетность очень важна в аналитике больших данных. Каждая организация должна регулярно предоставлять информацию для поддержки процесса принятия решений. Эта задача обычно выполняется аналитиками данных с опытом работы с SQL и ETL (извлечение, передача и загрузка).

Команда, отвечающая за эту задачу, несет ответственность за распространение информации, полученной в отделе анализа больших данных, в различных областях организации.

Следующий пример демонстрирует, что означает суммирование данных. Перейдите в папку bda / part1 / sumrize_data и внутри папки откройте файл sumrize_data.Rproj , дважды щелкнув по нему. Затем откройте сценарий sumrize_data.R, посмотрите на код и следуйте приведенным объяснениям.

# Install the following packages by running the following code in R.

pkgs = c('data.table', 'ggplot2', 'nycflights13', 'reshape2')

install.packages(pkgs)

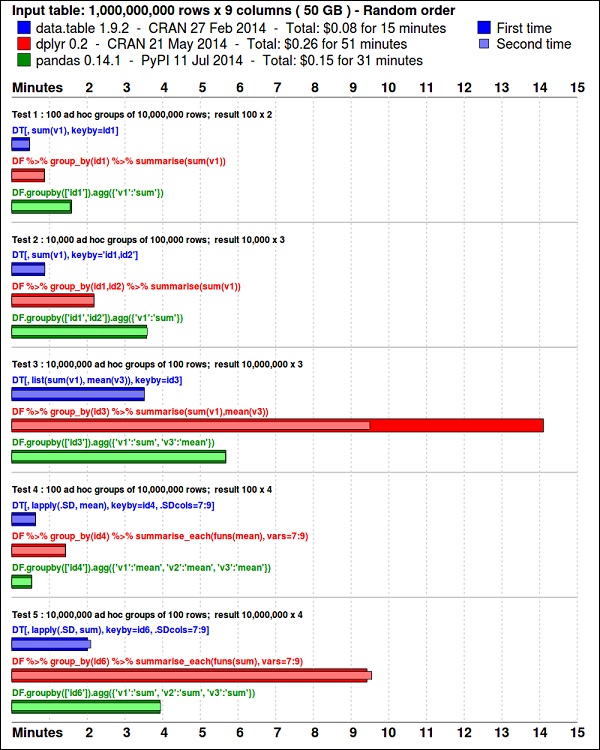

Пакет ggplot2 отлично подходит для визуализации данных. Пакет data.table является отличным вариантом для быстрого и эффективного суммирования памяти в R. Недавний тест показывает, что это даже быстрее, чем pandas , библиотека python, используемая для подобных задач.

Посмотрите на данные, используя следующий код. Этот код также доступен в файле bda / part1 / summaryrize_data / summaryrize_data.Rproj .

library(nycflights13) library(ggplot2) library(data.table) library(reshape2) # Convert the flights data.frame to a data.table object and call it DT DT <- as.data.table(flights) # The data has 336776 rows and 16 columns dim(DT) # Take a look at the first rows head(DT) # year month day dep_time dep_delay arr_time arr_delay carrier # 1: 2013 1 1 517 2 830 11 UA # 2: 2013 1 1 533 4 850 20 UA # 3: 2013 1 1 542 2 923 33 AA # 4: 2013 1 1 544 -1 1004 -18 B6 # 5: 2013 1 1 554 -6 812 -25 DL # 6: 2013 1 1 554 -4 740 12 UA # tailnum flight origin dest air_time distance hour minute # 1: N14228 1545 EWR IAH 227 1400 5 17 # 2: N24211 1714 LGA IAH 227 1416 5 33 # 3: N619AA 1141 JFK MIA 160 1089 5 42 # 4: N804JB 725 JFK BQN 183 1576 5 44 # 5: N668DN 461 LGA ATL 116 762 5 54 # 6: N39463 1696 EWR ORD 150 719 5 54

В следующем коде приведен пример суммирования данных.

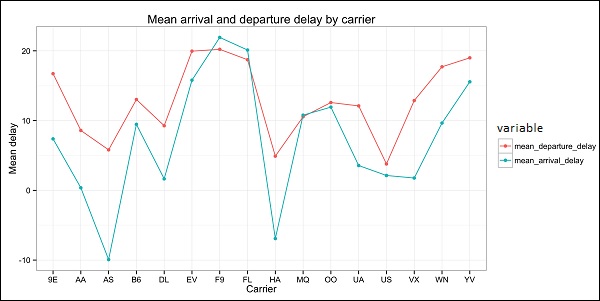

### Data Summarization # Compute the mean arrival delay DT[, list(mean_arrival_delay = mean(arr_delay, na.rm = TRUE))] # mean_arrival_delay # 1: 6.895377 # Now, we compute the same value but for each carrier mean1 = DT[, list(mean_arrival_delay = mean(arr_delay, na.rm = TRUE)), by = carrier] print(mean1) # carrier mean_arrival_delay # 1: UA 3.5580111 # 2: AA 0.3642909 # 3: B6 9.4579733 # 4: DL 1.6443409 # 5: EV 15.7964311 # 6: MQ 10.7747334 # 7: US 2.1295951 # 8: WN 9.6491199 # 9: VX 1.7644644 # 10: FL 20.1159055 # 11: AS -9.9308886 # 12: 9E 7.3796692 # 13: F9 21.9207048 # 14: HA -6.9152047 # 15: YV 15.5569853 # 16: OO 11.9310345 # Now let’s compute to means in the same line of code mean2 = DT[, list(mean_departure_delay = mean(dep_delay, na.rm = TRUE), mean_arrival_delay = mean(arr_delay, na.rm = TRUE)), by = carrier] print(mean2) # carrier mean_departure_delay mean_arrival_delay # 1: UA 12.106073 3.5580111 # 2: AA 8.586016 0.3642909 # 3: B6 13.022522 9.4579733 # 4: DL 9.264505 1.6443409 # 5: EV 19.955390 15.7964311 # 6: MQ 10.552041 10.7747334 # 7: US 3.782418 2.1295951 # 8: WN 17.711744 9.6491199 # 9: VX 12.869421 1.7644644 # 10: FL 18.726075 20.1159055 # 11: AS 5.804775 -9.9308886 # 12: 9E 16.725769 7.3796692 # 13: F9 20.215543 21.9207048 # 14: HA 4.900585 -6.9152047 # 15: YV 18.996330 15.5569853 # 16: OO 12.586207 11.9310345 ### Create a new variable called gain # this is the difference between arrival delay and departure delay DT[, gain:= arr_delay - dep_delay] # Compute the median gain per carrier median_gain = DT[, median(gain, na.rm = TRUE), by = carrier] print(median_gain)

Аналитика больших данных — исследование данных

Исследовательский анализ данных — это концепция, разработанная Джоном Тьюки (John Tuckey, 1977), которая основана на новом взгляде на статистику. Идея Тьюки заключалась в том, что в традиционной статистике данные не изучались графически, а просто использовались для проверки гипотез. Первая попытка разработать инструмент была сделана в Стэнфорде, проект получил название prim9 . Инструмент был способен визуализировать данные в девяти измерениях, поэтому он мог обеспечить многомерную перспективу данных.

В последние дни аналитический анализ данных является обязательным и был включен в жизненный цикл аналитики больших данных. Способность находить понимание и иметь возможность эффективно обмениваться информацией в организации обеспечивается мощными возможностями EDA.

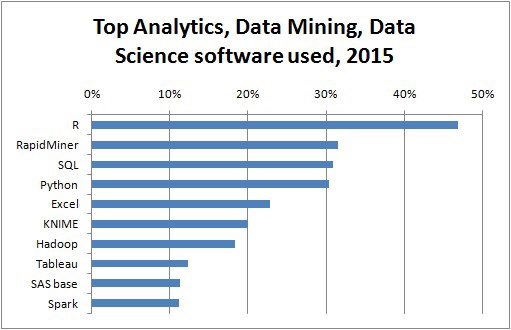

Основываясь на идеях Тьюки, Bell Labs разработала язык программирования S , чтобы предоставить интерактивный интерфейс для ведения статистики. Идея S состояла в том, чтобы предоставить обширные графические возможности с помощью простого в использовании языка. В современном мире в контексте больших данных R , основанный на языке программирования S, является самым популярным программным обеспечением для аналитики.

Следующая программа демонстрирует использование разведочного анализа данных.

Ниже приведен пример аналитического анализа данных. Этот код также доступен в файле part1 / eda / exploratory_data_analysis.R .

library(nycflights13)

library(ggplot2)

library(data.table)

library(reshape2)

# Using the code from the previous section

# This computes the mean arrival and departure delays by carrier.

DT <- as.data.table(flights)

mean2 = DT[, list(mean_departure_delay = mean(dep_delay, na.rm = TRUE),

mean_arrival_delay = mean(arr_delay, na.rm = TRUE)),

by = carrier]

# In order to plot data in R usign ggplot, it is normally needed to reshape the data

# We want to have the data in long format for plotting with ggplot

dt = melt(mean2, id.vars = ’carrier’)

# Take a look at the first rows

print(head(dt))

# Take a look at the help for ?geom_point and geom_line to find similar examples

# Here we take the carrier code as the x axis

# the value from the dt data.table goes in the y axis

# The variable column represents the color

p = ggplot(dt, aes(x = carrier, y = value, color = variable, group = variable)) +

geom_point() + # Plots points

geom_line() + # Plots lines

theme_bw() + # Uses a white background

labs(list(title = 'Mean arrival and departure delay by carrier',

x = 'Carrier', y = 'Mean delay'))

print(p)

# Save the plot to disk

ggsave('mean_delay_by_carrier.png', p,

width = 10.4, height = 5.07)

Код должен создать изображение, такое как следующее —

Big Data Analytics — Визуализация данных

Чтобы понять данные, часто полезно визуализировать их. Обычно в приложениях Big Data интерес заключается в том, чтобы находить понимание, а не просто создавать красивые сюжеты. Ниже приведены примеры различных подходов к пониманию данных с использованием графиков.

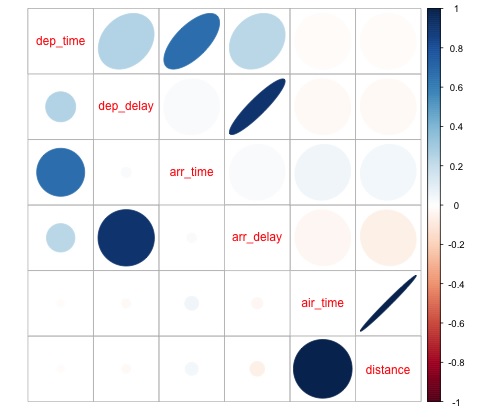

Чтобы начать анализ данных о рейсах, мы можем начать с проверки наличия корреляции между числовыми переменными. Этот код также доступен в файле bda / part1 / data_visualization / data_visualization.R .

# Install the package corrplot by running

install.packages('corrplot')

# then load the library

library(corrplot)

# Load the following libraries

library(nycflights13)

library(ggplot2)

library(data.table)

library(reshape2)

# We will continue working with the flights data

DT <- as.data.table(flights)

head(DT) # take a look

# We select the numeric variables after inspecting the first rows.

numeric_variables = c('dep_time', 'dep_delay',

'arr_time', 'arr_delay', 'air_time', 'distance')

# Select numeric variables from the DT data.table

dt_num = DT[, numeric_variables, with = FALSE]

# Compute the correlation matrix of dt_num

cor_mat = cor(dt_num, use = "complete.obs")

print(cor_mat)

### Here is the correlation matrix

# dep_time dep_delay arr_time arr_delay air_time distance

# dep_time 1.00000000 0.25961272 0.66250900 0.23230573 -0.01461948 -0.01413373

# dep_delay 0.25961272 1.00000000 0.02942101 0.91480276 -0.02240508 -0.02168090

# arr_time 0.66250900 0.02942101 1.00000000 0.02448214 0.05429603 0.04718917

# arr_delay 0.23230573 0.91480276 0.02448214 1.00000000 -0.03529709 -0.06186776

# air_time -0.01461948 -0.02240508 0.05429603 -0.03529709 1.00000000 0.99064965

# distance -0.01413373 -0.02168090 0.04718917 -0.06186776 0.99064965 1.00000000

# We can display it visually to get a better understanding of the data

corrplot.mixed(cor_mat, lower = "circle", upper = "ellipse")

# save it to disk

png('corrplot.png')

print(corrplot.mixed(cor_mat, lower = "circle", upper = "ellipse"))

dev.off()

Этот код генерирует следующую визуализацию матрицы корреляции —

Из графика видно, что между некоторыми переменными в наборе данных существует сильная корреляция. Например, задержка прибытия и задержка вылета кажутся сильно коррелированными. Мы можем видеть это, потому что эллипс показывает почти линейную связь между обеими переменными, однако, найти причину этого результата не просто.

Нельзя сказать, что, поскольку две переменные коррелируют, одна влияет на другую. Также на графике мы находим сильную корреляцию между временем в воздухе и расстоянием, что вполне разумно ожидать, так как при увеличении расстояния время полета должно расти.

Мы также можем сделать одномерный анализ данных. Простой и эффективный способ визуализации распределений — это блочные графики . Следующий код демонстрирует, как создавать коробчатые и решетчатые диаграммы с использованием библиотеки ggplot2. Этот код также доступен в файле bda / part1 / data_visualization / boxplots.R .

source('data_visualization.R')

### Analyzing Distributions using box-plots

# The following shows the distance as a function of the carrier

p = ggplot(DT, aes(x = carrier, y = distance, fill = carrier)) + # Define the carrier

in the x axis and distance in the y axis

geom_box-plot() + # Use the box-plot geom

theme_bw() + # Leave a white background - More in line with tufte's

principles than the default

guides(fill = FALSE) + # Remove legend

labs(list(title = 'Distance as a function of carrier', # Add labels

x = 'Carrier', y = 'Distance'))

p

# Save to disk

png(‘boxplot_carrier.png’)

print(p)

dev.off()

# Let's add now another variable, the month of each flight

# We will be using facet_wrap for this

p = ggplot(DT, aes(carrier, distance, fill = carrier)) +

geom_box-plot() +

theme_bw() +

guides(fill = FALSE) +

facet_wrap(~month) + # This creates the trellis plot with the by month variable

labs(list(title = 'Distance as a function of carrier by month',

x = 'Carrier', y = 'Distance'))

p

# The plot shows there aren't clear differences between distance in different months

# Save to disk

png('boxplot_carrier_by_month.png')

print(p)

dev.off()

Аналитика больших данных — Введение в R

Этот раздел посвящен знакомству пользователей с языком программирования R. R можно скачать с сайта крана . Для пользователей Windows полезно установить rtools и IDE rstudio .

Общая концепция R заключается в том, чтобы служить интерфейсом для другого программного обеспечения, разработанного на скомпилированных языках, таких как C, C ++ и Fortran, и предоставлять пользователю интерактивный инструмент для анализа данных.

Перейдите в папку zip-файла книги bda / part2 / R_introduction и откройте файл R_introduction.Rproj . Это откроет сеанс RStudio. Затем откройте файл 01_vectors.R. Запустите скрипт построчно и следуйте комментариям в коде. Еще одна полезная опция для обучения — просто набрать код, это поможет вам привыкнуть к синтаксису R. В R комментарии пишутся с символом #.

Чтобы отобразить результаты выполнения R-кода в книге, после оценки кода возвращаются результаты R-комментариев. Таким образом, вы можете скопировать вставить код в книгу и попробовать непосредственно разделы этого в R.

# Create a vector of numbers

numbers = c(1, 2, 3, 4, 5)

print(numbers)

# [1] 1 2 3 4 5

# Create a vector of letters

ltrs = c('a', 'b', 'c', 'd', 'e')

# [1] "a" "b" "c" "d" "e"

# Concatenate both

mixed_vec = c(numbers, ltrs)

print(mixed_vec)

# [1] "1" "2" "3" "4" "5" "a" "b" "c" "d" "e"

Давайте проанализируем, что произошло в предыдущем коде. Мы видим, что можно создавать векторы с цифрами и буквами. Нам не нужно было заранее указывать R, какой тип данных нам нужен. Наконец, мы смогли создать вектор с цифрами и буквами. Вектор mixed_vec привел числа к символу, мы можем увидеть это, визуализируя, как значения печатаются внутри кавычек.

Следующий код показывает тип данных различных векторов, возвращаемых классом функции. Обычно функция класса используется для «опроса» объекта, спрашивая его, каков его класс.

### Evaluate the data types using class ### One dimensional objects # Integer vector num = 1:10 class(num) # [1] "integer" # Numeric vector, it has a float, 10.5 num = c(1:10, 10.5) class(num) # [1] "numeric" # Character vector ltrs = letters[1:10] class(ltrs) # [1] "character" # Factor vector fac = as.factor(ltrs) class(fac) # [1] "factor"

R поддерживает двумерные объекты также. В следующем коде приведены примеры двух самых популярных структур данных, используемых в R: матрица и data.frame.

# Matrix M = matrix(1:12, ncol = 4) # [,1] [,2] [,3] [,4] # [1,] 1 4 7 10 # [2,] 2 5 8 11 # [3,] 3 6 9 12 lM = matrix(letters[1:12], ncol = 4) # [,1] [,2] [,3] [,4] # [1,] "a" "d" "g" "j" # [2,] "b" "e" "h" "k" # [3,] "c" "f" "i" "l" # Coerces the numbers to character # cbind concatenates two matrices (or vectors) in one matrix cbind(M, lM) # [,1] [,2] [,3] [,4] [,5] [,6] [,7] [,8] # [1,] "1" "4" "7" "10" "a" "d" "g" "j" # [2,] "2" "5" "8" "11" "b" "e" "h" "k" # [3,] "3" "6" "9" "12" "c" "f" "i" "l" class(M) # [1] "matrix" class(lM) # [1] "matrix" # data.frame # One of the main objects of R, handles different data types in the same object. # It is possible to have numeric, character and factor vectors in the same data.frame df = data.frame(n = 1:5, l = letters[1:5]) df # n l # 1 1 a # 2 2 b # 3 3 c # 4 4 d # 5 5 e

Как показано в предыдущем примере, в одном и том же объекте можно использовать разные типы данных. В общем, это то, как данные представлены в базах данных, часть данных API — это текстовые или символьные векторы и другие числовые значения. Задача аналитика — определить, какой тип статистических данных назначить, а затем использовать для него правильный тип данных R. В статистике мы обычно рассматриваем переменные следующих типов:

- числовой

- Номинальный или категориальный

- порядковый

В R вектор может быть следующих классов:

- Числовое — целое число

- фактор

- Упорядоченный фактор

R предоставляет тип данных для каждого статистического типа переменной. Упорядоченный коэффициент, однако, используется редко, но может быть создан с помощью функционального коэффициента или упорядочен.

В следующем разделе рассматривается понятие индексации. Это довольно распространенная операция, и она связана с проблемой выбора разделов объекта и преобразования в них.

# Let's create a data.frame

df = data.frame(numbers = 1:26, letters)

head(df)

# numbers letters

# 1 1 a

# 2 2 b

# 3 3 c

# 4 4 d

# 5 5 e

# 6 6 f

# str gives the structure of a data.frame, it’s a good summary to inspect an object

str(df)

# 'data.frame': 26 obs. of 2 variables:

# $ numbers: int 1 2 3 4 5 6 7 8 9 10 ...

# $ letters: Factor w/ 26 levels "a","b","c","d",..: 1 2 3 4 5 6 7 8 9 10 ...

# The latter shows the letters character vector was coerced as a factor.

# This can be explained by the stringsAsFactors = TRUE argumnet in data.frame

# read ?data.frame for more information

class(df)

# [1] "data.frame"

### Indexing

# Get the first row

df[1, ]

# numbers letters

# 1 1 a

# Used for programming normally - returns the output as a list

df[1, , drop = TRUE]

# $numbers

# [1] 1

#

# $letters

# [1] a

# Levels: a b c d e f g h i j k l m n o p q r s t u v w x y z

# Get several rows of the data.frame

df[5:7, ]

# numbers letters

# 5 5 e

# 6 6 f

# 7 7 g

### Add one column that mixes the numeric column with the factor column

df$mixed = paste(df$numbers, df$letters, sep = ’’)

str(df)

# 'data.frame': 26 obs. of 3 variables:

# $ numbers: int 1 2 3 4 5 6 7 8 9 10 ...

# $ letters: Factor w/ 26 levels "a","b","c","d",..: 1 2 3 4 5 6 7 8 9 10 ...

# $ mixed : chr "1a" "2b" "3c" "4d" ...

### Get columns

# Get the first column

df[, 1]

# It returns a one dimensional vector with that column

# Get two columns

df2 = df[, 1:2]

head(df2)

# numbers letters

# 1 1 a

# 2 2 b

# 3 3 c

# 4 4 d

# 5 5 e

# 6 6 f

# Get the first and third columns

df3 = df[, c(1, 3)]

df3[1:3, ]

# numbers mixed

# 1 1 1a

# 2 2 2b

# 3 3 3c

### Index columns from their names

names(df)

# [1] "numbers" "letters" "mixed"

# This is the best practice in programming, as many times indeces change, but

variable names don’t

# We create a variable with the names we want to subset

keep_vars = c("numbers", "mixed")

df4 = df[, keep_vars]

head(df4)

# numbers mixed

# 1 1 1a

# 2 2 2b

# 3 3 3c

# 4 4 4d

# 5 5 5e

# 6 6 6f

### subset rows and columns

# Keep the first five rows

df5 = df[1:5, keep_vars]

df5

# numbers mixed

# 1 1 1a

# 2 2 2b

# 3 3 3c

# 4 4 4d

# 5 5 5e

# subset rows using a logical condition

df6 = df[df$numbers < 10, keep_vars]

df6

# numbers mixed

# 1 1 1a

# 2 2 2b

# 3 3 3c

# 4 4 4d

# 5 5 5e

# 6 6 6f

# 7 7 7g

# 8 8 8h

# 9 9 9i

Big Data Analytics — Введение в SQL

SQL обозначает язык структурированных запросов. Это один из наиболее широко используемых языков для извлечения данных из баз данных в традиционных хранилищах данных и технологиях больших данных. Чтобы продемонстрировать основы SQL, мы будем работать с примерами. Чтобы сосредоточиться на самом языке, мы будем использовать SQL внутри R. С точки зрения написания кода SQL это точно так же, как это делается в базе данных.

Ядром SQL являются три оператора: SELECT, FROM и WHERE. В следующих примерах используются наиболее распространенные варианты использования SQL. Перейдите в папку bda / part2 / SQL_introduction и откройте файл SQL_introduction.Rproj . Затем откройте скрипт 01_select.R. Чтобы написать код SQL на R, нам нужно установить пакет sqldf , как показано в следующем коде.

# Install the sqldf package

install.packages('sqldf')

# load the library

library('sqldf')

library(nycflights13)

# We will be working with the fligths dataset in order to introduce SQL

# Let’s take a look at the table

str(flights)

# Classes 'tbl_d', 'tbl' and 'data.frame': 336776 obs. of 16 variables:

# $ year : int 2013 2013 2013 2013 2013 2013 2013 2013 2013 2013 ...

# $ month : int 1 1 1 1 1 1 1 1 1 1 ...

# $ day : int 1 1 1 1 1 1 1 1 1 1 ...

# $ dep_time : int 517 533 542 544 554 554 555 557 557 558 ...

# $ dep_delay: num 2 4 2 -1 -6 -4 -5 -3 -3 -2 ...

# $ arr_time : int 830 850 923 1004 812 740 913 709 838 753 ...

# $ arr_delay: num 11 20 33 -18 -25 12 19 -14 -8 8 ...

# $ carrier : chr "UA" "UA" "AA" "B6" ...

# $ tailnum : chr "N14228" "N24211" "N619AA" "N804JB" ...

# $ flight : int 1545 1714 1141 725 461 1696 507 5708 79 301 ...

# $ origin : chr "EWR" "LGA" "JFK" "JFK" ...

# $ dest : chr "IAH" "IAH" "MIA" "BQN" ...

# $ air_time : num 227 227 160 183 116 150 158 53 140 138 ...

# $ distance : num 1400 1416 1089 1576 762 ...

# $ hour : num 5 5 5 5 5 5 5 5 5 5 ...

# $ minute : num 17 33 42 44 54 54 55 57 57 58 ...

Оператор select используется для извлечения столбцов из таблиц и выполнения расчетов по ним. Простейшее утверждение SELECT продемонстрировано в ej1 . Мы также можем создать новые переменные, как показано в ej2 .

### SELECT statement

ej1 = sqldf("

SELECT

dep_time

,dep_delay

,arr_time

,carrier

,tailnum

FROM

flights

")

head(ej1)

# dep_time dep_delay arr_time carrier tailnum

# 1 517 2 830 UA N14228

# 2 533 4 850 UA N24211

# 3 542 2 923 AA N619AA

# 4 544 -1 1004 B6 N804JB

# 5 554 -6 812 DL N668DN

# 6 554 -4 740 UA N39463

# In R we can use SQL with the sqldf function. It works exactly the same as in

a database

# The data.frame (in this case flights) represents the table we are querying

and goes in the FROM statement

# We can also compute new variables in the select statement using the syntax:

# old_variables as new_variable

ej2 = sqldf("

SELECT

arr_delay - dep_delay as gain,

carrier

FROM

flights

")

ej2[1:5, ]

# gain carrier

# 1 9 UA

# 2 16 UA

# 3 31 AA

# 4 -17 B6

# 5 -19 DL

Одной из наиболее часто используемых функций SQL является оператор group by. Это позволяет вычислить числовое значение для разных групп другой переменной. Откройте скрипт 02_group_by.R.

### GROUP BY

# Computing the average

ej3 = sqldf("

SELECT

avg(arr_delay) as mean_arr_delay,

avg(dep_delay) as mean_dep_delay,

carrier

FROM

flights

GROUP BY

carrier

")

# mean_arr_delay mean_dep_delay carrier

# 1 7.3796692 16.725769 9E

# 2 0.3642909 8.586016 AA

# 3 -9.9308886 5.804775 AS

# 4 9.4579733 13.022522 B6

# 5 1.6443409 9.264505 DL

# 6 15.7964311 19.955390 EV

# 7 21.9207048 20.215543 F9

# 8 20.1159055 18.726075 FL

# 9 -6.9152047 4.900585 HA

# 10 10.7747334 10.552041 MQ

# 11 11.9310345 12.586207 OO

# 12 3.5580111 12.106073 UA

# 13 2.1295951 3.782418 US

# 14 1.7644644 12.869421 VX

# 15 9.6491199 17.711744 WN

# 16 15.5569853 18.996330 YV

# Other aggregations

ej4 = sqldf("

SELECT

avg(arr_delay) as mean_arr_delay,

min(dep_delay) as min_dep_delay,

max(dep_delay) as max_dep_delay,

carrier

FROM

flights

GROUP BY

carrier

")

# We can compute the minimun, mean, and maximum values of a numeric value

ej4

# mean_arr_delay min_dep_delay max_dep_delay carrier

# 1 7.3796692 -24 747 9E

# 2 0.3642909 -24 1014 AA

# 3 -9.9308886 -21 225 AS

# 4 9.4579733 -43 502 B6

# 5 1.6443409 -33 960 DL

# 6 15.7964311 -32 548 EV

# 7 21.9207048 -27 853 F9

# 8 20.1159055 -22 602 FL

# 9 -6.9152047 -16 1301 HA

# 10 10.7747334 -26 1137 MQ

# 11 11.9310345 -14 154 OO

# 12 3.5580111 -20 483 UA

# 13 2.1295951 -19 500 US

# 14 1.7644644 -20 653 VX

# 15 9.6491199 -13 471 WN

# 16 15.5569853 -16 387 YV

### We could be also interested in knowing how many observations each carrier has

ej5 = sqldf("

SELECT

carrier, count(*) as count

FROM

flights

GROUP BY

carrier

")

ej5

# carrier count

# 1 9E 18460

# 2 AA 32729

# 3 AS 714

# 4 B6 54635

# 5 DL 48110

# 6 EV 54173

# 7 F9 685

# 8 FL 3260

# 9 HA 342

# 10 MQ 26397

# 11 OO 32

# 12 UA 58665

# 13 US 20536

# 14 VX 5162

# 15 WN 12275

# 16 YV 601

Самая полезная особенность SQL — это объединения. Объединение означает, что мы хотим объединить таблицу A и таблицу B в одну таблицу, используя один столбец, чтобы соответствовать значениям обеих таблиц. Существуют различные типы объединений, с практической точки зрения, для начала они будут наиболее полезными: внутреннее объединение и левое внешнее объединение.

# Let’s create two tables: A and B to demonstrate joins.

A = data.frame(c1 = 1:4, c2 = letters[1:4])

B = data.frame(c1 = c(2,4,5,6), c2 = letters[c(2:5)])

A

# c1 c2

# 1 a

# 2 b

# 3 c

# 4 d

B

# c1 c2

# 2 b

# 4 c

# 5 d

# 6 e

### INNER JOIN

# This means to match the observations of the column we would join the tables by.

inner = sqldf("

SELECT

A.c1, B.c2

FROM

A INNER JOIN B

ON A.c1 = B.c1

")

# Only the rows that match c1 in both A and B are returned

inner

# c1 c2

# 2 b

# 4 c

### LEFT OUTER JOIN

# the left outer join, sometimes just called left join will return the

# first all the values of the column used from the A table

left = sqldf("

SELECT

A.c1, B.c2

FROM

A LEFT OUTER JOIN B

ON A.c1 = B.c1

")

# Only the rows that match c1 in both A and B are returned

left

# c1 c2

# 1 <NA>

# 2 b

# 3 <NA>

# 4 c

Аналитика больших данных — диаграммы и графики

Первый подход к анализу данных — это визуальный анализ. Цели при этом обычно заключаются в нахождении отношений между переменными и одномерном описании переменных. Мы можем разделить эти стратегии как —

- Одномерный анализ

- Многомерный анализ

Одномерные графические методы

Одномерный — это статистический термин. На практике это означает, что мы хотим анализировать переменную независимо от остальных данных. Сюжеты, которые позволяют сделать это эффективно, —

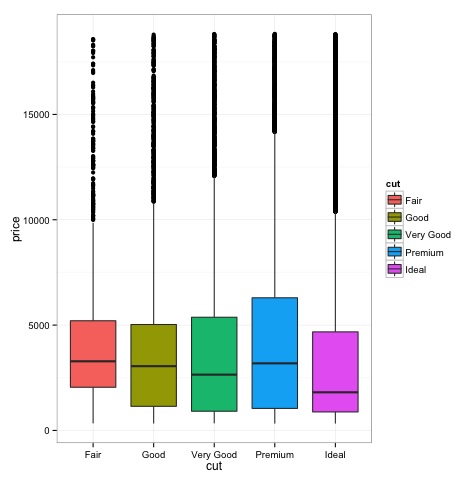

Box-участки

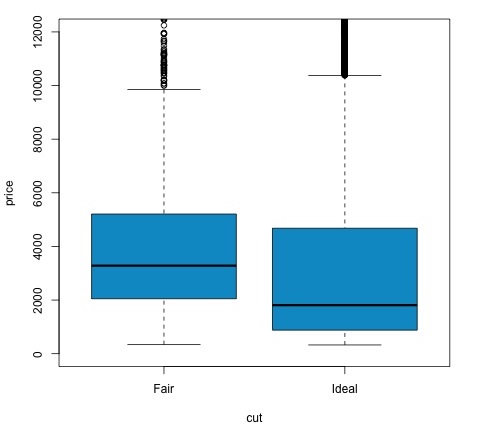

Боксы обычно используются для сравнения распределений. Это отличный способ визуально проверить, есть ли различия между дистрибутивами. Мы можем увидеть, если есть различия между ценами на бриллианты для разных огранки.

# We will be using the ggplot2 library for plotting

library(ggplot2)

data("diamonds")

# We will be using the diamonds dataset to analyze distributions of numeric variables

head(diamonds)

# carat cut color clarity depth table price x y z

# 1 0.23 Ideal E SI2 61.5 55 326 3.95 3.98 2.43

# 2 0.21 Premium E SI1 59.8 61 326 3.89 3.84 2.31

# 3 0.23 Good E VS1 56.9 65 327 4.05 4.07 2.31

# 4 0.29 Premium I VS2 62.4 58 334 4.20 4.23 2.63

# 5 0.31 Good J SI2 63.3 58 335 4.34 4.35 2.75

# 6 0.24 Very Good J VVS2 62.8 57 336 3.94 3.96 2.48

### Box-Plots

p = ggplot(diamonds, aes(x = cut, y = price, fill = cut)) +

geom_box-plot() +

theme_bw()

print(p)

Как видно на графике, существуют различия в распределении цен на алмазы в разных видах огранки.

Гистограммы

source('01_box_plots.R')

# We can plot histograms for each level of the cut factor variable using

facet_grid

p = ggplot(diamonds, aes(x = price, fill = cut)) +

geom_histogram() +

facet_grid(cut ~ .) +

theme_bw()

p

# the previous plot doesn’t allow to visuallize correctly the data because of

the differences in scale

# we can turn this off using the scales argument of facet_grid

p = ggplot(diamonds, aes(x = price, fill = cut)) +

geom_histogram() +

facet_grid(cut ~ ., scales = 'free') +

theme_bw()

p

png('02_histogram_diamonds_cut.png')

print(p)

dev.off()

Вывод вышеприведенного кода будет следующим:

Многовариантные графические методы

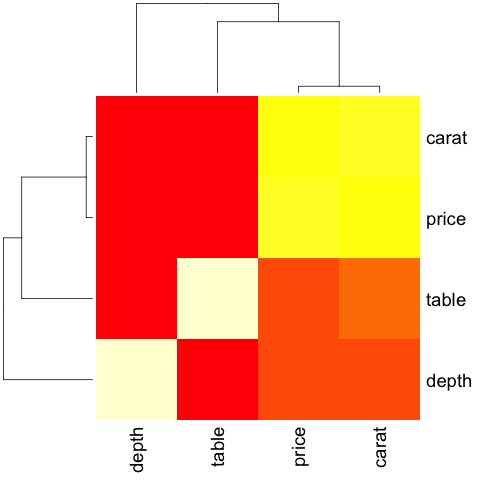

Многовариантные графические методы в исследовательском анализе данных имеют целью найти взаимосвязи между различными переменными. Есть два способа сделать это, которые обычно используются: построение матрицы корреляции числовых переменных или просто построение необработанных данных в виде матрицы диаграмм рассеяния.

Чтобы продемонстрировать это, мы будем использовать набор данных diamonds. Чтобы следовать коду, откройте скрипт bda / part2 / charts / 03_multivariate_analysis.R .

library(ggplot2)

data(diamonds)

# Correlation matrix plots

keep_vars = c('carat', 'depth', 'price', 'table')

df = diamonds[, keep_vars]

# compute the correlation matrix

M_cor = cor(df)

# carat depth price table

# carat 1.00000000 0.02822431 0.9215913 0.1816175

# depth 0.02822431 1.00000000 -0.0106474 -0.2957785

# price 0.92159130 -0.01064740 1.0000000 0.1271339

# table 0.18161755 -0.29577852 0.1271339 1.0000000

# plots

heat-map(M_cor)

Код выдаст следующий вывод —

Это резюме, оно говорит нам, что существует сильная корреляция между ценой и каретой, и не так много среди других переменных.

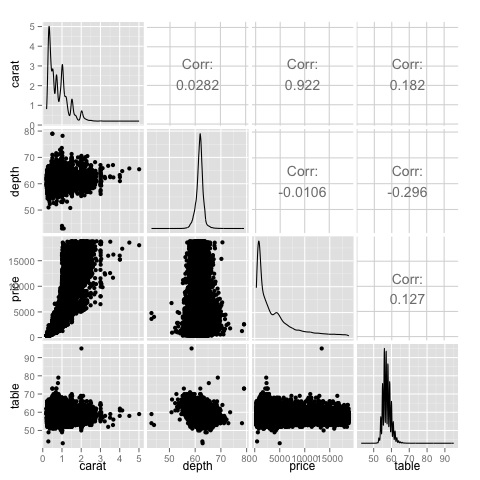

Корреляционная матрица может быть полезна, когда у нас есть большое количество переменных, и в этом случае построение исходных данных будет нецелесообразным. Как уже упоминалось, можно показать необработанные данные также —

library(GGally) ggpairs(df)

На графике видно, что результаты, отображаемые на тепловой карте, подтверждены, между ценовой и каратной переменными есть корреляция 0,922.

Это отношение можно визуализировать на диаграмме рассеяния цена-карат, расположенной в (3, 1) индексе матрицы рассеяния.

Big Data Analytics — Инструменты анализа данных

Существует множество инструментов, позволяющих ученым эффективно анализировать данные. Обычно инженерный аспект анализа данных фокусируется на базах данных, ученый фокусируется на инструментах, которые могут реализовывать продукты данных. В следующем разделе рассматриваются преимущества различных инструментов с акцентом на статистические пакеты, которые ученые чаще всего используют на практике.

Язык программирования R

R — это язык программирования с открытым исходным кодом с упором на статистический анализ. Это конкурентоспособно с коммерческими инструментами, такими как SAS, SPSS с точки зрения статистических возможностей. Считается, что это интерфейс к другим языкам программирования, таким как C, C ++ или Fortran.

Еще одним преимуществом R является большое количество доступных библиотек с открытым исходным кодом. В CRAN есть более 6000 пакетов, которые можно скачать бесплатно, а в Github доступно множество R-пакетов.

С точки зрения производительности R медленен для интенсивных операций, учитывая большое количество доступных библиотек, медленные части кода написаны на скомпилированных языках. Но если вы собираетесь выполнять операции, требующие глубокого написания циклов for, тогда R не будет вашей лучшей альтернативой. Для анализа данных есть хорошие библиотеки, такие как data.table, glmnet, ranger, xgboost, ggplot2, caret, которые позволяют использовать R в качестве интерфейса для более быстрых языков программирования.

Python для анализа данных

Python является языком программирования общего назначения и содержит значительное количество библиотек, посвященных анализу данных, таких как pandas, scikit-learn, theano, numpy и scipy .

Большая часть того, что доступно в R, также может быть сделано в Python, но мы обнаружили, что R проще в использовании. Если вы работаете с большими наборами данных, обычно Python — лучший выбор, чем R. Python может использоваться довольно эффективно для очистки и обработки данных построчно. Это возможно из R, но это не так эффективно, как Python для задач сценариев.

Для машинного обучения scikit-learn — это хорошая среда, в которой доступно большое количество алгоритмов, которые без проблем могут обрабатывать наборы данных среднего размера. По сравнению с эквивалентной библиотекой R (caret), Scikit-learn имеет более чистый и согласованный API.

Юля

Julia — это высокопроизводительный динамический язык программирования для технических вычислений. Его синтаксис очень похож на R или Python, поэтому, если вы уже работаете с R или Python, будет довольно просто написать тот же код на Julia. Язык довольно новый и значительно вырос за последние годы, так что это определенно вариант на данный момент.

Мы бы порекомендовали Джулию для прототипирования алгоритмов, которые требуют больших вычислительных ресурсов, таких как нейронные сети. Это отличный инструмент для исследований. С точки зрения внедрения модели в производство, вероятно, у Python есть лучшие альтернативы. Однако это становится меньшей проблемой, поскольку существуют веб-сервисы, которые занимаются разработкой моделей на R, Python и Julia.

ПАВ

SAS — это коммерческий язык, который до сих пор используется для бизнес-аналитики. Он имеет базовый язык, который позволяет пользователю программировать самые разные приложения. Он содержит довольно много коммерческих продуктов, которые дают пользователям, не являющимся экспертами, возможность использовать сложные инструменты, такие как библиотека нейронных сетей, без необходимости программирования.

Помимо очевидного недостатка коммерческих инструментов, SAS плохо масштабируется для больших наборов данных. Даже набор данных среднего размера будет иметь проблемы с SAS и приведет к сбою сервера. Рекомендуется использовать SAS только в том случае, если вы работаете с небольшими наборами данных, а пользователи не являются экспертами в области обработки данных. Для продвинутых пользователей R и Python обеспечивают более продуктивную среду.

SPSS

SPSS, в настоящее время является продуктом IBM для статистического анализа. Он в основном используется для анализа данных опроса, и для пользователей, которые не умеют программировать, это достойная альтернатива. Возможно, его так же просто использовать, как и SAS, но с точки зрения реализации модели это проще, поскольку он предоставляет код SQL для оценки модели. Этот код обычно неэффективен, но это только начало, тогда как SAS продает продукт, который оценивает модели для каждой базы данных в отдельности. Для небольших данных и неопытного коллектива SPSS — такой же хороший выбор, как и SAS.

Программное обеспечение, однако, довольно ограничено, и опытные пользователи будут на порядок более продуктивными, используя R или Python.

Матлаб, Октава

Доступны и другие инструменты, такие как Matlab или его версия с открытым исходным кодом (Octave). Эти инструменты в основном используются для исследований. С точки зрения возможностей R или Python могут делать все, что доступно в Matlab или Octave. Покупать лицензию на продукт имеет смысл только в том случае, если вы заинтересованы в поддержке, которую они предоставляют.

Аналитика больших данных — статистические методы

При анализе данных можно использовать статистический подход. Основные инструменты, необходимые для проведения базового анализа:

- Корреляционный анализ

- Дисперсионный анализ

- Проверка гипотезы

При работе с большими наборами данных это не вызывает проблем, поскольку эти методы не требуют значительных вычислительных ресурсов, за исключением корреляционного анализа. В этом случае всегда можно взять образец, и результаты должны быть надежными.

Корреляционный анализ

Корреляционный анализ стремится найти линейные отношения между числовыми переменными. Это может быть полезно в разных обстоятельствах. Одним из распространенных применений является исследовательский анализ данных, в разделе 16.0.2 книги приведен базовый пример этого подхода. Прежде всего, метрика корреляции, использованная в упомянутом примере, основана на коэффициенте Пирсона . Существует, однако, еще один интересный показатель корреляции, который не зависит от выбросов. Эта метрика называется корреляцией Спирмена.

Метрика корреляции Спирмена более устойчива к наличию выбросов, чем метод Пирсона, и дает более точные оценки линейных отношений между числовой переменной, когда данные обычно не распределены.

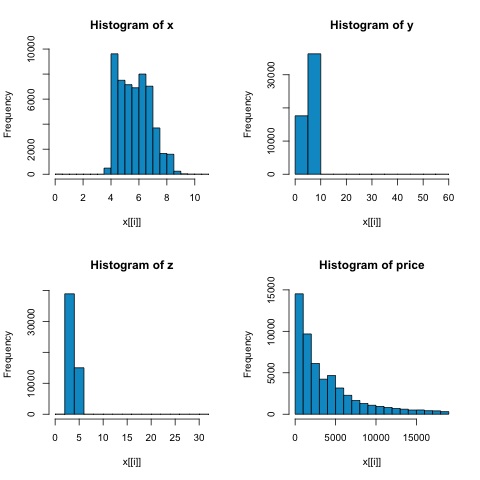

library(ggplot2) # Select variables that are interesting to compare pearson and spearman correlation methods. x = diamonds[, c('x', 'y', 'z', 'price')] # From the histograms we can expect differences in the correlations of both metrics. # In this case as the variables are clearly not normally distributed, the spearman correlation # is a better estimate of the linear relation among numeric variables. par(mfrow = c(2,2)) colnm = names(x) for(i in 1:4) { hist(x[[i]], col = 'deepskyblue3', main = sprintf('Histogram of %s', colnm[i])) } par(mfrow = c(1,1))

Из гистограмм на следующем рисунке можно ожидать различий в корреляциях обеих метрик. В этом случае, поскольку переменные явно не распределены нормально, корреляция Спирмена является лучшей оценкой линейного отношения между числовыми переменными.

Чтобы вычислить корреляцию в R, откройте файл bda / part2 / statistics_methods / correlation / correlation.R, в котором есть этот раздел кода.

## Correlation Matrix - Pearson and spearman cor_pearson <- cor(x, method = 'pearson') cor_spearman <- cor(x, method = 'spearman') ### Pearson Correlation print(cor_pearson) # x y z price # x 1.0000000 0.9747015 0.9707718 0.8844352 # y 0.9747015 1.0000000 0.9520057 0.8654209 # z 0.9707718 0.9520057 1.0000000 0.8612494 # price 0.8844352 0.8654209 0.8612494 1.0000000 ### Spearman Correlation print(cor_spearman) # x y z price # x 1.0000000 0.9978949 0.9873553 0.9631961 # y 0.9978949 1.0000000 0.9870675 0.9627188 # z 0.9873553 0.9870675 1.0000000 0.9572323 # price 0.9631961 0.9627188 0.9572323 1.0000000

Тест хи-квадрат

Тест хи-квадрат позволяет нам проверить, являются ли две случайные переменные независимыми. Это означает, что распределение вероятностей каждой переменной не влияет на другую. Чтобы оценить тест в R, нам нужно сначала создать таблицу сопряженности, а затем передать таблицу в функцию chisq.test R.

Например, давайте проверим, существует ли связь между переменными: cut и color из набора данных diamonds. Тест формально определяется как —

- H0: переменная огранка и алмаз независимы

- H1: переменная огранка и алмаз не являются независимыми

Мы могли бы предположить, что существует связь между этими двумя переменными по их именам, но тест может дать объективное «правило», указывающее, насколько значим этот результат или нет.

В следующем фрагменте кода мы обнаружили, что значение p теста равно 2.2e-16, что практически равно нулю в практическом плане. Затем после запуска теста, выполняющего моделирование по методу Монте-Карло , мы обнаружили, что значение p составляет 0,0004998, что все еще значительно ниже порога 0,05. Этот результат означает, что мы отвергаем нулевую гипотезу (H0), поэтому считаем, что переменные cut и color не являются независимыми.

library(ggplot2) # Use the table function to compute the contingency table tbl = table(diamonds$cut, diamonds$color) tbl # D E F G H I J # Fair 163 224 312 314 303 175 119 # Good 662 933 909 871 702 522 307 # Very Good 1513 2400 2164 2299 1824 1204 678 # Premium 1603 2337 2331 2924 2360 1428 808 # Ideal 2834 3903 3826 4884 3115 2093 896 # In order to run the test we just use the chisq.test function. chisq.test(tbl) # Pearson’s Chi-squared test # data: tbl # X-squared = 310.32, df = 24, p-value < 2.2e-16 # It is also possible to compute the p-values using a monte-carlo simulation # It's needed to add the simulate.p.value = TRUE flag and the amount of simulations chisq.test(tbl, simulate.p.value = TRUE, B = 2000) # Pearson’s Chi-squared test with simulated p-value (based on 2000 replicates) # data: tbl # X-squared = 310.32, df = NA, p-value = 0.0004998

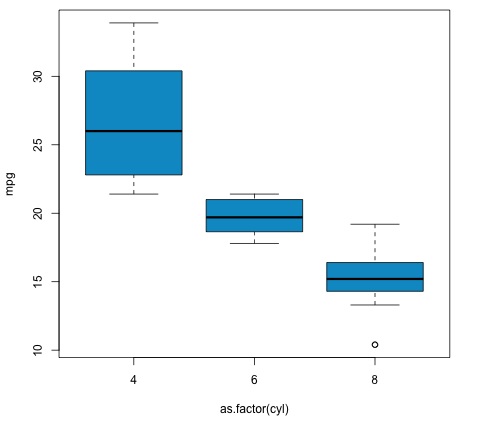

Т-тест

Идея t-критерия состоит в том, чтобы оценить, есть ли различия в числовой переменной # распределение между различными группами номинальной переменной. Чтобы продемонстрировать это, я выберу уровни Справедливого и Идеального уровней среза факторной переменной, затем сравним значения числовой переменной среди этих двух групп.

data = diamonds[diamonds$cut %in% c('Fair', 'Ideal'), ]

data$cut = droplevels.factor(data$cut) # Drop levels that aren’t used from the

cut variable

df1 = data[, c('cut', 'price')]

# We can see the price means are different for each group

tapply(df1$price, df1$cut, mean)

# Fair Ideal

# 4358.758 3457.542

T-тесты реализованы в R с помощью функции t.test . Интерфейс формулы для t.test является самым простым способом его использования, идея состоит в том, что числовая переменная объясняется групповой переменной.

Например: t.test (numeric_variable ~ group_variable, data = data) . В предыдущем примере numeric_variable это цена, а group_variable обрезается .

Со статистической точки зрения мы проверяем, есть ли различия в распределении числовой переменной между двумя группами. Формально проверка гипотезы описывается нулевой гипотезой (H0) и альтернативной гипотезой (H1).

-