Начало работы с Kubernetes 1.4 с использованием Spring Boot и Couchbase объясняет, как начать работу с Kubernetes 1.4 в Amazon Web Services. В кластере создается служба Couchbase, а приложение Spring Boot сохраняет документ JSON в базе данных. Для запуска кластера используется скрипт kube-up.sh из бинарной загрузки Kubernetes по адресу github.com/kubernetes/kubernetes/releases/download/v1.4.0/kubernetes.tar.gz . Этот скрипт способен создавать кластер Kubernetes только с одним мастером. Это фундаментальный недостаток распределенных приложений, когда мастер становится единой точкой отказа.

Встречайте копы — сокращение от Kubernetes Operations.

Это самый простой способ запустить высокодоступный кластер Kubernetes. Сценарий kubectl — это интерфейс командной строки для запуска команд с запущенными кластерами. Думайте о kops как о kubectl для кластера .

Этот блог покажет, как создать высокодоступный кластер Kubernetes на Amazon, используя kops . И как только кластер будет создан, он создаст на нем службу Couchbase и запустит приложение Spring Boot для хранения документа JSON в базе данных.

Огромное спасибо Джастинсб , Сарахсу , Разичу, Джейгорреллу, пожиманию плечами, Бкпандей и другим на свободном канале Кубернетеса за помощь в прояснении деталей!

Скачать копы и кубектл

- Загрузите последнюю версию Kops . Этот блог был протестирован с 1.4.1 на OSX. Полный набор команд для

kopsможно увидеть:

|

01

02

03

04

05

06

07

08

09

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

|

Usage: kops [command] Available Commands: create create resources delete delete clusters describe describe objects edit edit items export export clusters/kubecfg get list or get objects import import clusters rolling-update rolling update clusters secrets Manage secrets & keys toolbox Misc infrequently used commands update update clusters upgrade upgrade clusters version Print the client version information Flags: --alsologtostderr log to standard error as well as files --config string config file (default is $HOME/.kops.yaml) --log_backtrace_at traceLocation when logging hits line file:N, emit a stack trace (default :0) --log_dir string If non-empty, write log files in this directory --logtostderr log to standard error instead of files (default false) --name string Name of cluster --state string Location of state storage --stderrthreshold severity logs at or above this threshold go to stderr (default 2) -v, --v Level log level for V logs --vmodule moduleSpec comma-separated list of pattern=N settings for file-filtered logging Use "kops [command] --help" for more information about a command. |

- Скачать

kubectl:

|

1

|

curl -Lo kubectl http://storage.googleapis.com/kubernetes-release/release/v1.4.1/bin/darwin/amd64/kubectl && chmod +x kubectl |

- Включите

kubectlв вашkubectl.

Создать Bucket и NS Records на Amazon

В настоящее время требуется немного настройки, и, надеюсь, это будет исправлено в следующих выпусках. Создание кластера в AWS предоставляет подробные инструкции и дополнительную информацию. Вот то, что блог следовал:

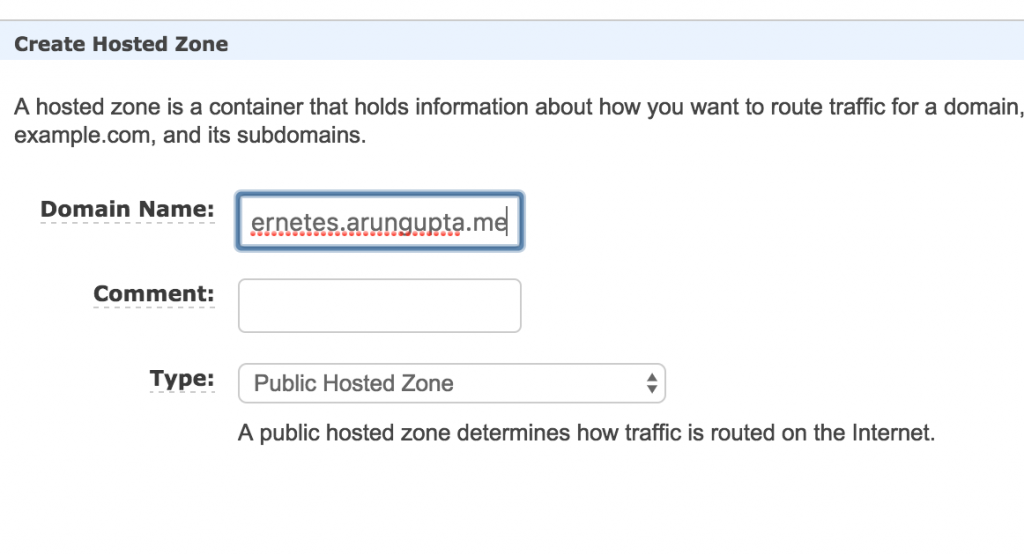

- Выберите домен, где будет размещен кластер Kubernetes. Этот блог использует домен

kubernetes.arungupta.me. Вы можете выбрать домен верхнего уровня или поддомен. - Amazon Route 53 — это высокодоступная и масштабируемая служба DNS. Войдите в консоль Amazon и создайте размещенную зону для этого домена с помощью службы Route 53

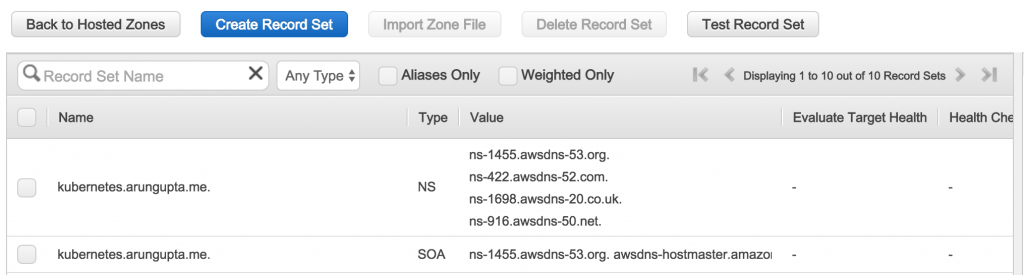

Созданная зона выглядит так:

Значения, показанные в столбце « Value , важны, так как они будут использованы позже для создания записей NS.

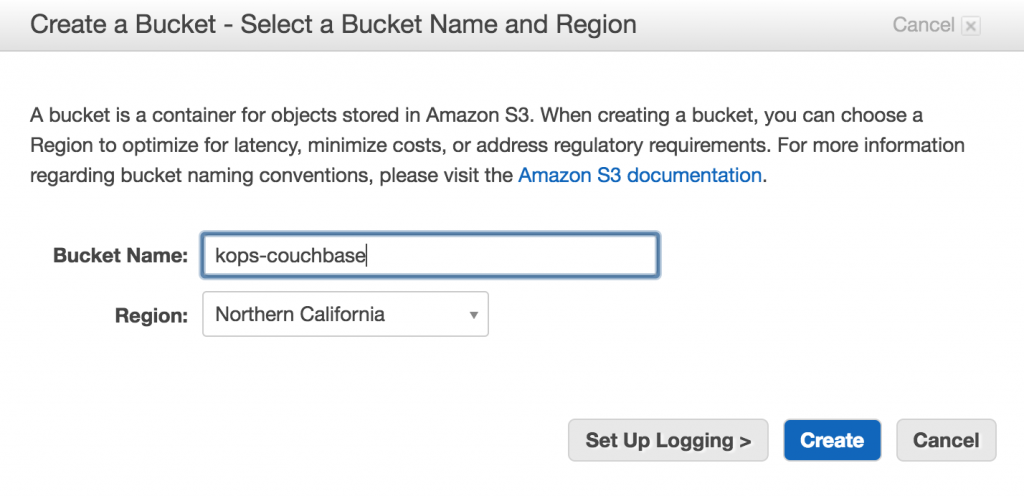

- Создайте корзину S3 с помощью Amazon Console для хранения конфигурации кластера — это называется

state store.

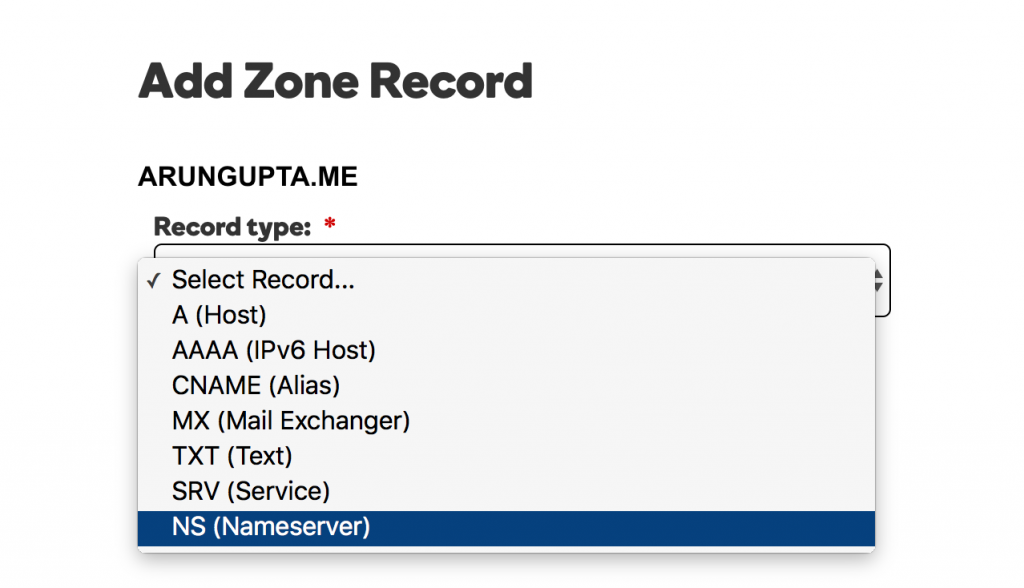

- Домен

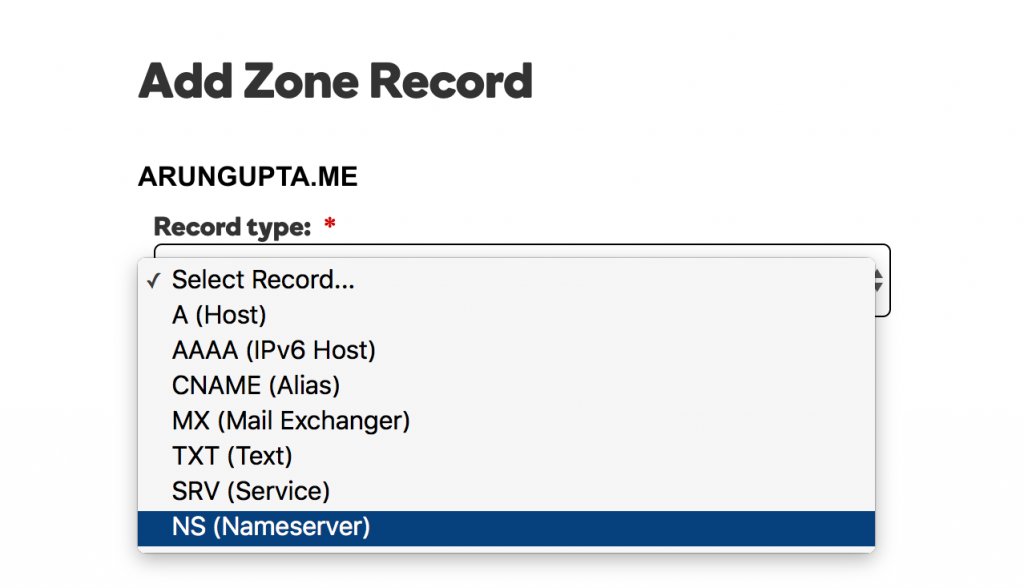

kubernetes.arungupta.meразмещен на GoDaddy. Для каждого значения, показанного в столбце «Значение» размещенной зоны Route53, создайте запись NS, используя Центр управления доменом GoDaddy для этого домена. Выберите тип записи:

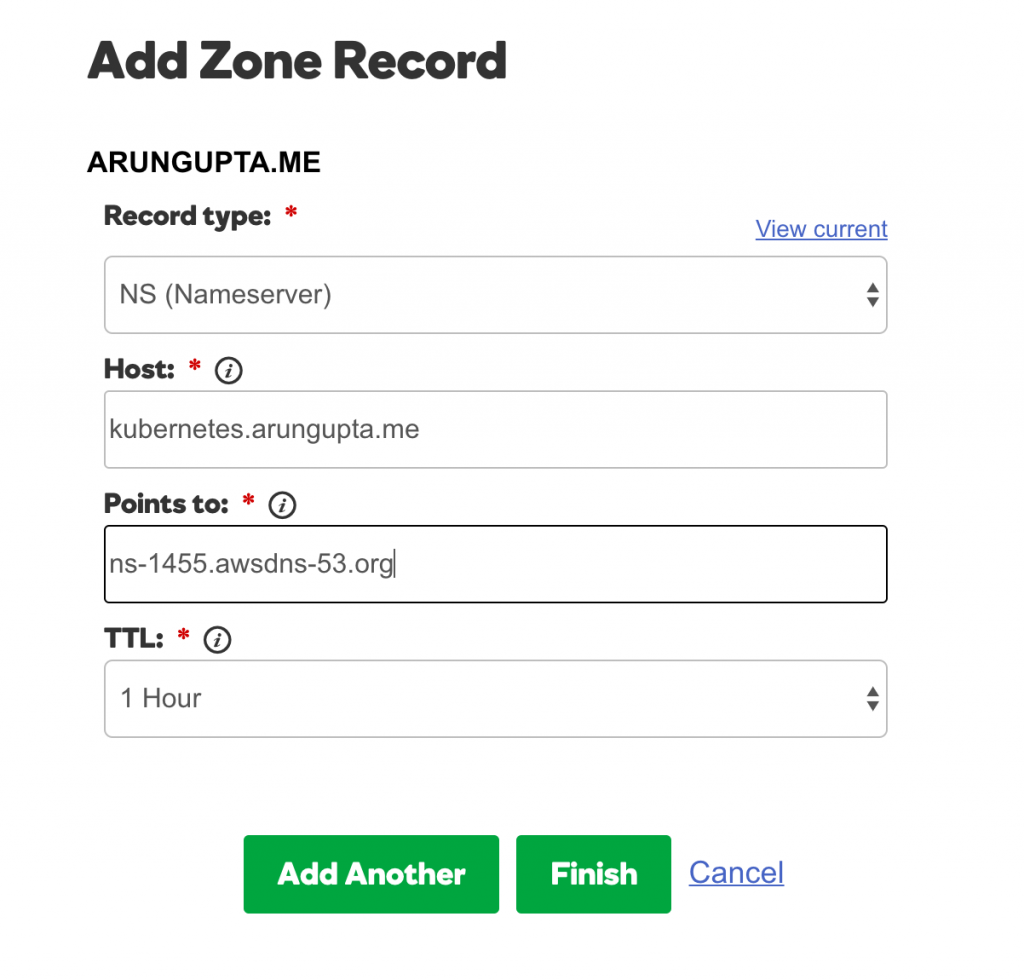

Для каждого значения добавьте запись, как показано:

Завершено множество записей вида

Начать мультимедийный кластер Kubernetes

Давайте немного разберемся с регионами и зонами Амазонки:

Amazon EC2 размещается в нескольких местах по всему миру. Эти местоположения состоят из регионов и зон доступности. Каждый регион — это отдельная географическая зона. Каждый регион имеет несколько изолированных мест, известных как зоны доступности.

Высокодоступный кластер Kubernetes можно создавать в разных зонах, но не в разных регионах.

- Узнайте зоны доступности в пределах региона:

|

01

02

03

04

05

06

07

08

09

10

11

12

13

14

15

16

17

18

19

20

21

22

23

|

aws ec2 describe-availability-zones --region us-west-2{ "AvailabilityZones": [ { "State": "available", "RegionName": "us-west-2", "Messages": [], "ZoneName": "us-west-2a" }, { "State": "available", "RegionName": "us-west-2", "Messages": [], "ZoneName": "us-west-2b" }, { "State": "available", "RegionName": "us-west-2", "Messages": [], "ZoneName": "us-west-2c" } ]} |

- Создайте мультимастерный кластер:

|

1

|

kops-darwin-amd64 create cluster --name=kubernetes.arungupta.me --cloud=aws --zones=us-west-2a,us-west-2b,us-west-2c --master-size=m4.large --node-count=3 --node-size=m4.2xlarge --master-zones=us-west-2a,us-west-2b,us-west-2c --state=s3://kops-couchbase --yes |

Большинство переключателей говорят сами за себя. Некоторые переключатели нуждаются в небольшом объяснении:

- Указание нескольких зон с помощью

--master-zones(должно быть нечетным числом) создает несколько мастеров по AZ -

--cloud=awsнеобязательно, если облако может быть выведено из зон -

--yesиспользуется для указания немедленного создания кластера. В противном случае в сегменте сохраняется только состояние, и кластер необходимо создавать отдельно.

Полный набор переключателей CLI можно увидеть:

|

01

02

03

04

05

06

07

08

09

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

|

./kops-darwin-amd64 create cluster --helpCreates a k8s cluster. Usage: kops create cluster [flags] Flags: --admin-access string Restrict access to admin endpoints (SSH, HTTPS) to this CIDR. If not set, access will not be restricted by IP. --associate-public-ip Specify --associate-public-ip=[true|false] to enable/disable association of public IP for master ASG and nodes. Default is 'true'. (default true) --channel string Channel for default versions and configuration to use (default "stable") --cloud string Cloud provider to use - gce, aws --dns-zone string DNS hosted zone to use (defaults to last two components of cluster name) --image string Image to use --kubernetes-version string Version of kubernetes to run (defaults to version in channel) --master-size string Set instance size for masters --master-zones string Zones in which to run masters (must be an odd number) --model string Models to apply (separate multiple models with commas) (default "config,proto,cloudup") --network-cidr string Set to override the default network CIDR --networking string Networking mode to use. kubenet (default), classic, external. (default "kubenet") --node-count int Set the number of nodes --node-size string Set instance size for nodes --out string Path to write any local output --project string Project to use (must be set on GCE) --ssh-public-key string SSH public key to use (default "~/.ssh/id_rsa.pub") --target string Target - direct, terraform (default "direct") --vpc string Set to use a shared VPC --yes Specify --yes to immediately create the cluster --zones string Zones in which to run the cluster Global Flags: --alsologtostderr log to standard error as well as files --config string config file (default is $HOME/.kops.yaml) --log_backtrace_at traceLocation when logging hits line file:N, emit a stack trace (default :0) --log_dir string If non-empty, write log files in this directory --logtostderr log to standard error instead of files (default false) --name string Name of cluster --state string Location of state storage --stderrthreshold severity logs at or above this threshold go to stderr (default 2) -v, --v Level log level for V logs --vmodule moduleSpec comma-separated list of pattern=N settings for file-filtered logging |

- Как только кластер создан, узнайте больше о кластере:

|

1

2

3

4

5

|

kubectl cluster-infoKubernetes master is running at https://api.kubernetes.arungupta.meKubeDNS is running at https://api.kubernetes.arungupta.me/api/v1/proxy/namespaces/kube-system/services/kube-dns To further debug and diagnose cluster problems, use 'kubectl cluster-info dump'. |

- Проверьте клиент кластера и версию сервера:

|

1

2

3

|

kubectl versionClient Version: version.Info{Major:"1", Minor:"4", GitVersion:"v1.4.1", GitCommit:"33cf7b9acbb2cb7c9c72a10d6636321fb180b159", GitTreeState:"clean", BuildDate:"2016-10-10T18:19:49Z", GoVersion:"go1.7.1", Compiler:"gc", Platform:"darwin/amd64"}Server Version: version.Info{Major:"1", Minor:"4", GitVersion:"v1.4.3", GitCommit:"4957b090e9a4f6a68b4a40375408fdc74a212260", GitTreeState:"clean", BuildDate:"2016-10-16T06:20:04Z", GoVersion:"go1.6.3", Compiler:"gc", Platform:"linux/amd64"} |

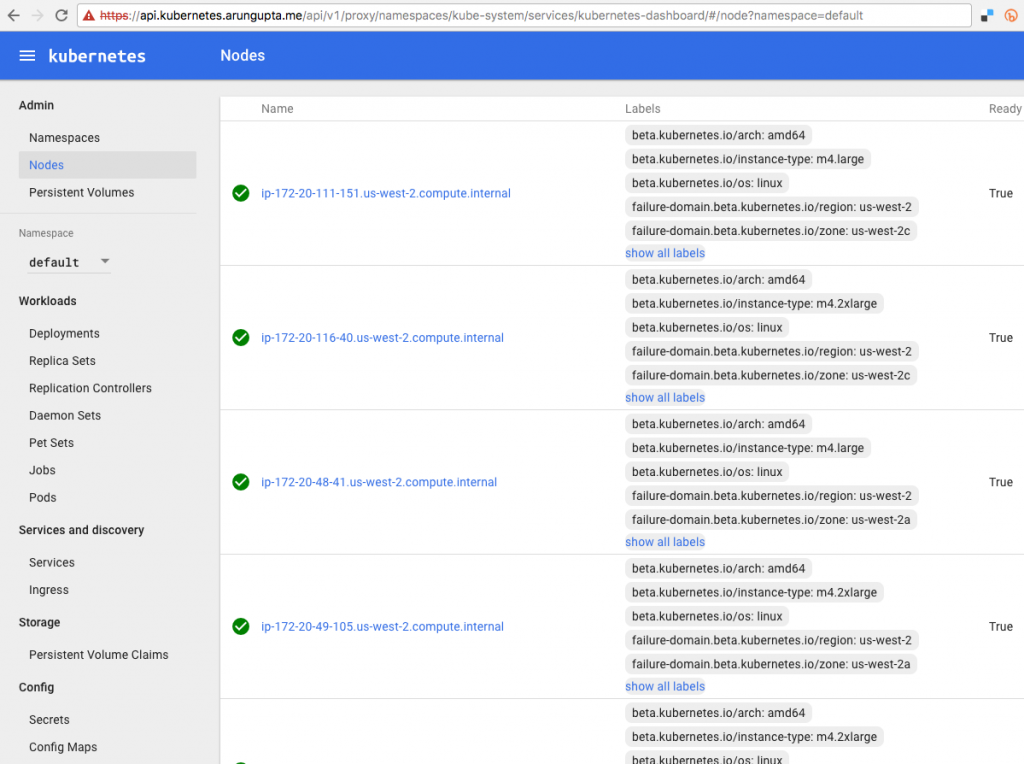

- Проверьте все узлы в кластере:

|

1

2

3

4

5

6

7

8

|

kubectl get nodes NAME STATUS AGEip-172-20-111-151.us-west-2.compute.internal Ready 1hip-172-20-116-40.us-west-2.compute.internal Ready 1hip-172-20-48-41.us-west-2.compute.internal Ready 1hip-172-20-49-105.us-west-2.compute.internal Ready 1hip-172-20-80-233.us-west-2.compute.internal Ready 1hip-172-20-82-93.us-west-2.compute.internal Ready 1h |

Или узнайте только главные узлы:

|

1

2

3

4

5

|

kubectl get nodes -l kubernetes.io/role=masterNAME STATUS AGEip-172-20-111-151.us-west-2.compute.internal Ready 1hip-172-20-48-41.us-west-2.compute.internal Ready 1hip-172-20-82-93.us-west-2.compute.internal Ready 1h |

- Проверьте все кластеры:

|

1

2

3

|

kops-darwin-amd64 get clusters --state=s3://kops-couchbaseNAME CLOUD ZONESkubernetes.arungupta.me aws us-west-2a,us-west-2b,us-west-2c |

Kubernetes Dashboard Аддон

По умолчанию кластер, созданный с помощью kops, не имеет панели мониторинга пользовательского интерфейса. Но это может быть добавлено как дополнение:

|

1

2

3

|

kubectl create -f https://raw.githubusercontent.com/kubernetes/kops/master/addons/kubernetes-dashboard/v1.4.0.yamldeployment "kubernetes-dashboard-v1.4.0" createdservice "kubernetes-dashboard" created |

Теперь полные сведения о кластере можно увидеть:

|

1

2

3

4

5

6

|

kubectl cluster-infoKubernetes master is running at https://api.kubernetes.arungupta.meKubeDNS is running at https://api.kubernetes.arungupta.me/api/v1/proxy/namespaces/kube-system/services/kube-dnskubernetes-dashboard is running at https://api.kubernetes.arungupta.me/api/v1/proxy/namespaces/kube-system/services/kubernetes-dashboard To further debug and diagnose cluster problems, use 'kubectl cluster-info dump'. |

И панель управления пользовательского интерфейса Kubernetes находится по указанному URL. В нашем случае это https://api.kubernetes.arungupta.me/ui и выглядит так:

Учетные данные для доступа к этой панели мониторинга можно получить с помощью команды kubectl config view . Значения показаны как:

|

1

2

3

4

|

- name: kubernetes.arungupta.me-basic-auth user: password: PASSWORD username: admin |

Развернуть Couchbase Service

Как объясняется в разделе Начало работы с Kubernetes 1.4 с использованием Spring Boot и Couchbase , давайте запустим сервис Couchbase:

|

1

2

3

|

kubectl create -f ~/workspaces/kubernetes-java-sample/maven/couchbase-service.yml service "couchbase-service" createdreplicationcontroller "couchbase-rc" created |

Этот файл конфигурации находится по адресу github.com/arun-gupta/kubernetes-java-sample/blob/master/maven/couchbase-service.yml .

Получить список услуг:

|

1

2

3

4

|

kubectl get svcNAME CLUSTER-IP EXTERNAL-IP PORT(S) AGEcouchbase-service 100.65.4.139 <none> 8091/TCP,8092/TCP,8093/TCP,11210/TCP 27skubernetes 100.64.0.1 <none> 443/TCP 2h |

Опишите услугу:

|

01

02

03

04

05

06

07

08

09

10

11

12

13

14

15

16

|

kubectl describe svc/couchbase-serviceName: couchbase-serviceNamespace: defaultLabels: <none>Selector: app=couchbase-rc-podType: ClusterIPIP: 100.65.4.139Port: admin 8091/TCPEndpoints: 100.96.5.2:8091Port: views 8092/TCPEndpoints: 100.96.5.2:8092Port: query 8093/TCPEndpoints: 100.96.5.2:8093Port: memcached 11210/TCPEndpoints: 100.96.5.2:11210Session Affinity: None |

Получи стручки:

|

1

2

3

|

kubectl get podsNAME READY STATUS RESTARTS AGEcouchbase-rc-e35v5 1/1 Running 0 1m |

Запустите Spring Boot Application

Приложение Spring Boot работает с сервисом Couchbase и сохраняет в нем документ JSON.

Запустите приложение Spring Boot:

|

1

2

|

kubectl create -f ~/workspaces/kubernetes-java-sample/maven/bootiful-couchbase.yml job "bootiful-couchbase" created |

Этот файл конфигурации находится по адресу github.com/arun-gupta/kubernetes-java-sample/blob/master/maven/bootiful-couchbase.yml .

Смотрите список всех контейнеров:

|

1

2

3

4

5

|

<kubectl get pods --show-allNAME READY STATUS RESTARTS AGEbootiful-couchbase-ainv8 0/1 Completed 0 1mcouchbase-rc-e35v5 1/1 Running 0 3m |

Проверьте журналы полного пакета:

|

01

02

03

04

05

06

07

08

09

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

|

kubectl logs bootiful-couchbase-ainv8. ____ _ __ _ _/\\ / ___'_ __ _ _(_)_ __ __ _ \ \ \ \( ( )\___ | '_ | '_| | '_ \/ _` | \ \ \ \\\/ ___)| |_)| | | | | || (_| | ) ) ) )' |____| .__|_| |_|_| |_\__, | / / / /=========|_|==============|___/=/_/_/_/:: Spring Boot :: (v1.4.0.RELEASE)2016-11-02 18:48:56.035 INFO 7 --- [ main] org.example.webapp.Application : Starting Application v1.0-SNAPSHOT on bootiful-couchbase-ainv8 with PID 7 (/maven/bootiful-couchbase.jar started by root in /)2016-11-02 18:48:56.040 INFO 7 --- [ main] org.example.webapp.Application : No active profile set, falling back to default profiles: default2016-11-02 18:48:56.115 INFO 7 --- [ main] s.c.a.AnnotationConfigApplicationContext : Refreshing org.springframework.context.annotation.AnnotationConfigApplicationContext@108c4c35: startup date [Wed Nov 02 18:48:56 UTC 2016]; root of context hierarchy2016-11-02 18:48:57.021 INFO 7 --- [ main] com.couchbase.client.core.CouchbaseCore : CouchbaseEnvironment: {sslEnabled=false, sslKeystoreFile='null', sslKeystorePassword='null', queryEnabled=false, queryPort=8093, bootstrapHttpEnabled=true, bootstrapCarrierEnabled=true, bootstrapHttpDirectPort=8091, bootstrapHttpSslPort=18091, bootstrapCarrierDirectPort=11210, bootstrapCarrierSslPort=11207, ioPoolSize=8, computationPoolSize=8, responseBufferSize=16384, requestBufferSize=16384, kvServiceEndpoints=1, viewServiceEndpoints=1, queryServiceEndpoints=1, searchServiceEndpoints=1, ioPool=NioEventLoopGroup, coreScheduler=CoreScheduler, eventBus=DefaultEventBus, packageNameAndVersion=couchbase-java-client/2.2.8 (git: 2.2.8, core: 1.2.9), dcpEnabled=false, retryStrategy=BestEffort, maxRequestLifetime=75000, retryDelay=ExponentialDelay{growBy 1.0 MICROSECONDS, powers of 2; lower=100, upper=100000}, reconnectDelay=ExponentialDelay{growBy 1.0 MILLISECONDS, powers of 2; lower=32, upper=4096}, observeIntervalDelay=ExponentialDelay{growBy 1.0 MICROSECONDS, powers of 2; lower=10, upper=100000}, keepAliveInterval=30000, autoreleaseAfter=2000, bufferPoolingEnabled=true, tcpNodelayEnabled=true, mutationTokensEnabled=false, socketConnectTimeout=1000, dcpConnectionBufferSize=20971520, dcpConnectionBufferAckThreshold=0.2, dcpConnectionName=dcp/core-io, callbacksOnIoPool=false, queryTimeout=7500, viewTimeout=7500, kvTimeout=2500, connectTimeout=5000, disconnectTimeout=25000, dnsSrvEnabled=false}2016-11-02 18:48:57.245 INFO 7 --- [ cb-io-1-1] com.couchbase.client.core.node.Node : Connected to Node couchbase-service2016-11-02 18:48:57.291 INFO 7 --- [ cb-io-1-1] com.couchbase.client.core.node.Node : Disconnected from Node couchbase-service2016-11-02 18:48:57.533 INFO 7 --- [ cb-io-1-2] com.couchbase.client.core.node.Node : Connected to Node couchbase-service2016-11-02 18:48:57.638 INFO 7 --- [-computations-4] c.c.c.core.config.ConfigurationProvider : Opened bucket books2016-11-02 18:48:58.152 INFO 7 --- [ main] o.s.j.e.a.AnnotationMBeanExporter : Registering beans for JMX exposure on startupBook{isbn=978-1-4919-1889-0, name=Minecraft Modding with Forge, cost=29.99}2016-11-02 18:48:58.402 INFO 7 --- [ main] org.example.webapp.Application : Started Application in 2.799 seconds (JVM running for 3.141)2016-11-02 18:48:58.403 INFO 7 --- [ Thread-5] s.c.a.AnnotationConfigApplicationContext : Closing org.springframework.context.annotation.AnnotationConfigApplicationContext@108c4c35: startup date [Wed Nov 02 18:48:56 UTC 2016]; root of context hierarchy2016-11-02 18:48:58.404 INFO 7 --- [ Thread-5] o.s.j.e.a.AnnotationMBeanExporter : Unregistering JMX-exposed beans on shutdown2016-11-02 18:48:58.410 INFO 7 --- [ cb-io-1-2] com.couchbase.client.core.node.Node : Disconnected from Node couchbase-service2016-11-02 18:48:58.410 INFO 7 --- [ Thread-5] c.c.c.core.config.ConfigurationProvider : Closed bucket books |

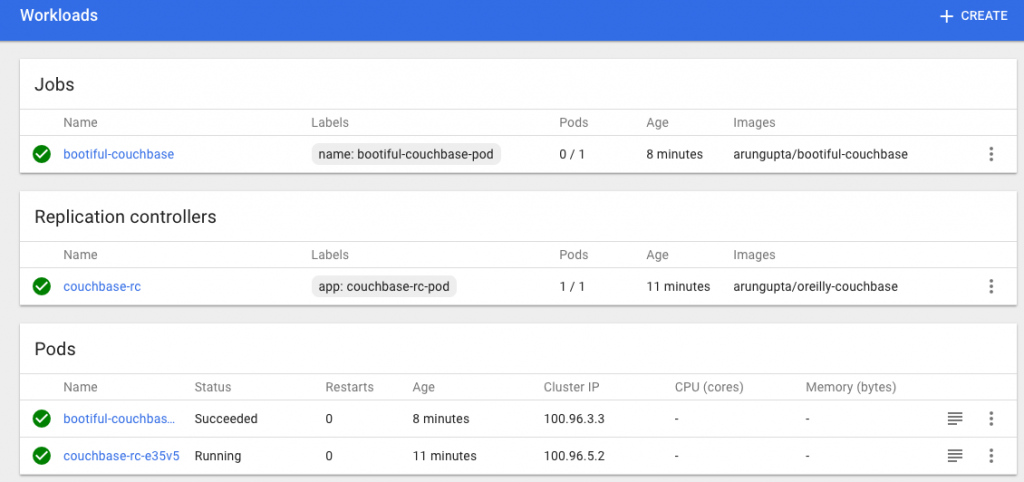

Обновленная панель мониторинга теперь выглядит следующим образом:

Удалить кластер Kubernetes

Kubernetes кластер может быть удален как:

|

001

002

003

004

005

006

007

008

009

010

011

012

013

014

015

016

017

018

019

020

021

022

023

024

025

026

027

028

029

030

031

032

033

034

035

036

037

038

039

040

041

042

043

044

045

046

047

048

049

050

051

052

053

054

055

056

057

058

059

060

061

062

063

064

065

066

067

068

069

070

071

072

073

074

075

076

077

078

079

080

081

082

083

084

085

086

087

088

089

090

091

092

093

094

095

096

097

098

099

100

101

102

103

104

105

106

107

108

109

110

111

112

113

114

115

116

117

118

119

120

121

122

123

124

125

126

127

128

129

130

131

132

133

134

135

136

137

138

139

140

141

142

143

144

145

146

147

148

149

150

151

152

153

154

155

156

157

158

159

160

161

162

163

164

165

166

167

168

169

170

171

172

173

174

175

176

177

178

179

180

181

182

183

184

185

186

187

188

189

190

191

192

193

194

|

kops-darwin-amd64 delete cluster --name=kubernetes.arungupta.me --state=s3://kops-couchbase --yesTYPE NAME IDautoscaling-config master-us-west-2a.masters.kubernetes.arungupta.me-20161101235639 master-us-west-2a.masters.kubernetes.arungupta.me-20161101235639autoscaling-config master-us-west-2b.masters.kubernetes.arungupta.me-20161101235639 master-us-west-2b.masters.kubernetes.arungupta.me-20161101235639autoscaling-config master-us-west-2c.masters.kubernetes.arungupta.me-20161101235639 master-us-west-2c.masters.kubernetes.arungupta.me-20161101235639autoscaling-config nodes.kubernetes.arungupta.me-20161101235639 nodes.kubernetes.arungupta.me-20161101235639autoscaling-group master-us-west-2a.masters.kubernetes.arungupta.me master-us-west-2a.masters.kubernetes.arungupta.meautoscaling-group master-us-west-2b.masters.kubernetes.arungupta.me master-us-west-2b.masters.kubernetes.arungupta.meautoscaling-group master-us-west-2c.masters.kubernetes.arungupta.me master-us-west-2c.masters.kubernetes.arungupta.meautoscaling-group nodes.kubernetes.arungupta.me nodes.kubernetes.arungupta.medhcp-options kubernetes.arungupta.me dopt-9b7b08ffiam-instance-profile masters.kubernetes.arungupta.me masters.kubernetes.arungupta.meiam-instance-profile nodes.kubernetes.arungupta.me nodes.kubernetes.arungupta.meiam-role masters.kubernetes.arungupta.me masters.kubernetes.arungupta.meiam-role nodes.kubernetes.arungupta.me nodes.kubernetes.arungupta.meinstance master-us-west-2a.masters.kubernetes.arungupta.me i-8798eb9finstance master-us-west-2b.masters.kubernetes.arungupta.me i-eca96ab3instance master-us-west-2c.masters.kubernetes.arungupta.me i-63fd3dbfinstance nodes.kubernetes.arungupta.me i-21a96a7einstance nodes.kubernetes.arungupta.me i-57fb3b8binstance nodes.kubernetes.arungupta.me i-5c99ea44internet-gateway kubernetes.arungupta.me igw-b624abd2keypair kubernetes.kubernetes.arungupta.me-18:90:41:6f:5f:79:6a:a8:d5:b6:b8:3f:10:d5:d3:f3 kubernetes.kubernetes.arungupta.me-18:90:41:6f:5f:79:6a:a8:d5:b6:b8:3f:10:d5:d3:f3route-table kubernetes.arungupta.me rtb-e44df183route53-record api.internal.kubernetes.arungupta.me. Z6I41VJM5VCZV/api.internal.kubernetes.arungupta.me.route53-record api.kubernetes.arungupta.me. Z6I41VJM5VCZV/api.kubernetes.arungupta.me.route53-record etcd-events-us-west-2a.internal.kubernetes.arungupta.me. Z6I41VJM5VCZV/etcd-events-us-west-2a.internal.kubernetes.arungupta.me.route53-record etcd-events-us-west-2b.internal.kubernetes.arungupta.me. Z6I41VJM5VCZV/etcd-events-us-west-2b.internal.kubernetes.arungupta.me.route53-record etcd-events-us-west-2c.internal.kubernetes.arungupta.me. Z6I41VJM5VCZV/etcd-events-us-west-2c.internal.kubernetes.arungupta.me.route53-record etcd-us-west-2a.internal.kubernetes.arungupta.me. Z6I41VJM5VCZV/etcd-us-west-2a.internal.kubernetes.arungupta.me.route53-record etcd-us-west-2b.internal.kubernetes.arungupta.me. Z6I41VJM5VCZV/etcd-us-west-2b.internal.kubernetes.arungupta.me.route53-record etcd-us-west-2c.internal.kubernetes.arungupta.me. Z6I41VJM5VCZV/etcd-us-west-2c.internal.kubernetes.arungupta.me.security-group masters.kubernetes.arungupta.me sg-3e790f47security-group nodes.kubernetes.arungupta.me sg-3f790f46subnet us-west-2a.kubernetes.arungupta.me subnet-3cdbc958subnet us-west-2b.kubernetes.arungupta.me subnet-18c3f76esubnet us-west-2c.kubernetes.arungupta.me subnet-b30f6debvolume us-west-2a.etcd-events.kubernetes.arungupta.me vol-202350a8volume us-west-2a.etcd-main.kubernetes.arungupta.me vol-0a235082volume us-west-2b.etcd-events.kubernetes.arungupta.me vol-401f5bf4volume us-west-2b.etcd-main.kubernetes.arungupta.me vol-691f5bddvolume us-west-2c.etcd-events.kubernetes.arungupta.me vol-aefe163bvolume us-west-2c.etcd-main.kubernetes.arungupta.me vol-e9fd157cvpc kubernetes.arungupta.me vpc-e5f50382 internet-gateway:igw-b624abd2 still has dependencies, will retrykeypair:kubernetes.kubernetes.arungupta.me-18:90:41:6f:5f:79:6a:a8:d5:b6:b8:3f:10:d5:d3:f3 okinstance:i-5c99ea44 okinstance:i-63fd3dbf okinstance:i-eca96ab3 okinstance:i-21a96a7e okautoscaling-group:master-us-west-2a.masters.kubernetes.arungupta.me okautoscaling-group:master-us-west-2b.masters.kubernetes.arungupta.me okautoscaling-group:master-us-west-2c.masters.kubernetes.arungupta.me okautoscaling-group:nodes.kubernetes.arungupta.me okiam-instance-profile:nodes.kubernetes.arungupta.me okiam-instance-profile:masters.kubernetes.arungupta.me okinstance:i-57fb3b8b okinstance:i-8798eb9f okroute53-record:Z6I41VJM5VCZV/etcd-events-us-west-2a.internal.kubernetes.arungupta.me. okiam-role:nodes.kubernetes.arungupta.me okiam-role:masters.kubernetes.arungupta.me okautoscaling-config:nodes.kubernetes.arungupta.me-20161101235639 okautoscaling-config:master-us-west-2b.masters.kubernetes.arungupta.me-20161101235639 oksubnet:subnet-b30f6deb still has dependencies, will retrysubnet:subnet-3cdbc958 still has dependencies, will retrysubnet:subnet-18c3f76e still has dependencies, will retryautoscaling-config:master-us-west-2a.masters.kubernetes.arungupta.me-20161101235639 okautoscaling-config:master-us-west-2c.masters.kubernetes.arungupta.me-20161101235639 okvolume:vol-0a235082 still has dependencies, will retryvolume:vol-202350a8 still has dependencies, will retryvolume:vol-401f5bf4 still has dependencies, will retryvolume:vol-e9fd157c still has dependencies, will retryvolume:vol-aefe163b still has dependencies, will retryvolume:vol-691f5bdd still has dependencies, will retrysecurity-group:sg-3f790f46 still has dependencies, will retrysecurity-group:sg-3e790f47 still has dependencies, will retryNot all resources deleted; waiting before reattempting deletion internet-gateway:igw-b624abd2 security-group:sg-3f790f46 volume:vol-aefe163b route-table:rtb-e44df183 volume:vol-401f5bf4 subnet:subnet-18c3f76e security-group:sg-3e790f47 volume:vol-691f5bdd subnet:subnet-3cdbc958 volume:vol-202350a8 volume:vol-0a235082 dhcp-options:dopt-9b7b08ff subnet:subnet-b30f6deb volume:vol-e9fd157c vpc:vpc-e5f50382internet-gateway:igw-b624abd2 still has dependencies, will retryvolume:vol-e9fd157c still has dependencies, will retrysubnet:subnet-3cdbc958 still has dependencies, will retrysubnet:subnet-18c3f76e still has dependencies, will retrysubnet:subnet-b30f6deb still has dependencies, will retryvolume:vol-0a235082 still has dependencies, will retryvolume:vol-aefe163b still has dependencies, will retryvolume:vol-691f5bdd still has dependencies, will retryvolume:vol-202350a8 still has dependencies, will retryvolume:vol-401f5bf4 still has dependencies, will retrysecurity-group:sg-3f790f46 still has dependencies, will retrysecurity-group:sg-3e790f47 still has dependencies, will retryNot all resources deleted; waiting before reattempting deletion subnet:subnet-b30f6deb volume:vol-e9fd157c vpc:vpc-e5f50382 internet-gateway:igw-b624abd2 security-group:sg-3f790f46 volume:vol-aefe163b route-table:rtb-e44df183 volume:vol-401f5bf4 subnet:subnet-18c3f76e security-group:sg-3e790f47 volume:vol-691f5bdd subnet:subnet-3cdbc958 volume:vol-202350a8 volume:vol-0a235082 dhcp-options:dopt-9b7b08ffsubnet:subnet-18c3f76e still has dependencies, will retrysubnet:subnet-b30f6deb still has dependencies, will retryinternet-gateway:igw-b624abd2 still has dependencies, will retrysubnet:subnet-3cdbc958 still has dependencies, will retryvolume:vol-691f5bdd still has dependencies, will retryvolume:vol-0a235082 still has dependencies, will retryvolume:vol-202350a8 still has dependencies, will retryvolume:vol-401f5bf4 still has dependencies, will retryvolume:vol-aefe163b still has dependencies, will retryvolume:vol-e9fd157c still has dependencies, will retrysecurity-group:sg-3e790f47 still has dependencies, will retrysecurity-group:sg-3f790f46 still has dependencies, will retryNot all resources deleted; waiting before reattempting deletion internet-gateway:igw-b624abd2 security-group:sg-3f790f46 volume:vol-aefe163b route-table:rtb-e44df183 volume:vol-401f5bf4 subnet:subnet-18c3f76e security-group:sg-3e790f47 volume:vol-691f5bdd subnet:subnet-3cdbc958 volume:vol-202350a8 volume:vol-0a235082 dhcp-options:dopt-9b7b08ff subnet:subnet-b30f6deb volume:vol-e9fd157c vpc:vpc-e5f50382subnet:subnet-b30f6deb still has dependencies, will retryvolume:vol-202350a8 still has dependencies, will retryinternet-gateway:igw-b624abd2 still has dependencies, will retrysubnet:subnet-18c3f76e still has dependencies, will retryvolume:vol-e9fd157c still has dependencies, will retryvolume:vol-aefe163b still has dependencies, will retryvolume:vol-401f5bf4 still has dependencies, will retryvolume:vol-691f5bdd still has dependencies, will retrysecurity-group:sg-3e790f47 still has dependencies, will retrysecurity-group:sg-3f790f46 still has dependencies, will retrysubnet:subnet-3cdbc958 still has dependencies, will retryvolume:vol-0a235082 still has dependencies, will retryNot all resources deleted; waiting before reattempting deletion internet-gateway:igw-b624abd2 security-group:sg-3f790f46 volume:vol-aefe163b route-table:rtb-e44df183 subnet:subnet-18c3f76e security-group:sg-3e790f47 volume:vol-691f5bdd volume:vol-401f5bf4 volume:vol-202350a8 subnet:subnet-3cdbc958 volume:vol-0a235082 dhcp-options:dopt-9b7b08ff subnet:subnet-b30f6deb volume:vol-e9fd157c vpc:vpc-e5f50382subnet:subnet-18c3f76e okvolume:vol-e9fd157c okvolume:vol-401f5bf4 okvolume:vol-0a235082 okvolume:vol-691f5bdd oksubnet:subnet-3cdbc958 okvolume:vol-aefe163b oksubnet:subnet-b30f6deb okinternet-gateway:igw-b624abd2 okvolume:vol-202350a8 oksecurity-group:sg-3f790f46 oksecurity-group:sg-3e790f47 okroute-table:rtb-e44df183 okvpc:vpc-e5f50382 okdhcp-options:dopt-9b7b08ff ok Cluster deleted |

couchbase.com/containers предоставляет более подробную информацию о том, как запустить Couchbase в различных контейнерах.

Больше информации о Couchbase:

| Ссылка: | Мультимастерный кластер Kubernetes на Amazon. Использование Kops от нашего партнера по JCG Аруна Гупты в блоге Miles to go 3.0… . |