Что такое обучение без учителя?

Обучение без учителя — это метод машинного обучения, при котором вам не нужно контролировать модель. Вместо этого вам нужно позволить модели работать самостоятельно для обнаружения информации. В основном это касается немаркированных данных.

Необучаемые алгоритмы обучения позволяют выполнять более сложные задачи обработки по сравнению с контролируемым обучением. Хотя неконтролируемое обучение может быть более непредсказуемым по сравнению с другими естественными методами обучения.

В этом уроке вы узнаете:

- Пример неконтролируемого машинного обучения

- Почему неконтролируемое обучение?

- Типы неконтролируемого обучения

- Кластеризация

- Типы кластеризации

- ассоциация

- Машинное обучение под присмотром против обучения без присмотра

- Применение неконтролируемого машинного обучения

- Недостатки неконтролируемого обучения

Пример неконтролируемого машинного обучения

Давайте возьмем случай ребенка и ее семейной собаки.

Она знает и идентифицирует эту собаку. Через несколько недель друг семьи берет с собой собаку и пытается поиграть с ребенком.

Малыш не видел эту собаку ранее. Но он признает, что многие черты (2 уха, глаза, ходьба на 4 ногах) похожи на ее собаку. Она идентифицирует новое животное как собаку. Это неконтролируемое обучение, когда вас не учат, но вы учитесь на основе данных (в данном случае данных о собаке). Если бы это было обучение под наблюдением, друг семьи сказал бы ребенку, что это собака.

Почему неконтролируемое обучение?

Вот основные причины использования неконтролируемого обучения:

- Неуправляемое машинное обучение находит в данных все виды неизвестных закономерностей.

- Неуправляемые методы помогут вам найти функции, которые могут быть полезны для категоризации.

- Это происходит в режиме реального времени, поэтому все входные данные должны быть проанализированы и помечены в присутствии учащихся.

- Получать немаркированные данные с компьютера легче, чем помечать данные, что требует ручного вмешательства.

Типы неконтролируемого обучения

Необученные проблемы обучения далее сгруппированы в проблемы кластеризации и ассоциации.

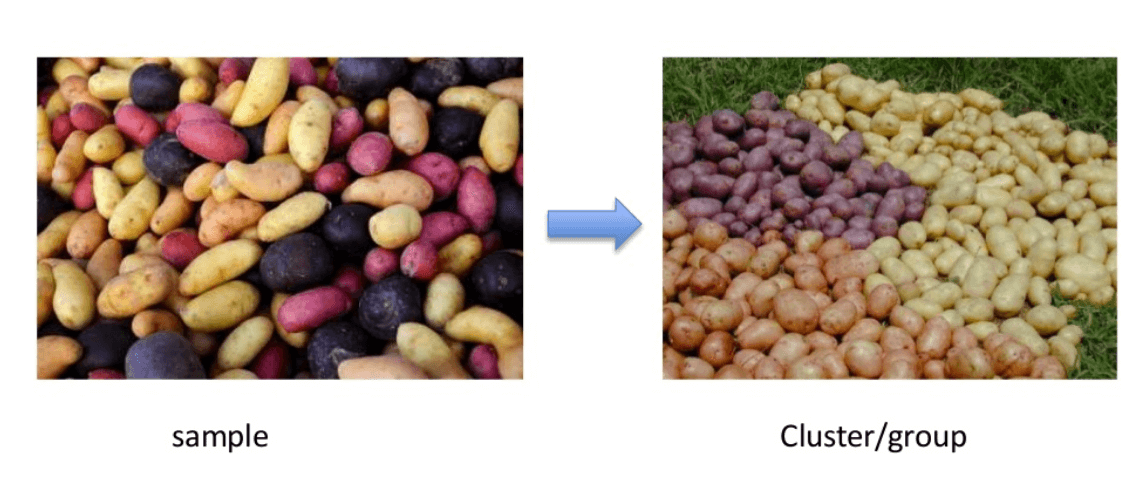

Кластеризация

Кластеризация является важной концепцией, когда речь идет об обучении без учителя. В основном это касается поиска структуры или шаблона в коллекции некатегоризованных данных. Алгоритмы кластеризации будут обрабатывать ваши данные и находить естественные кластеры (группы), если они существуют в данных. Вы также можете изменить количество кластеров, которые должны идентифицировать ваши алгоритмы. Это позволяет настроить гранулярность этих групп.

Существуют различные типы кластеризации, которые вы можете использовать:

Эксклюзив (разметка)

В этом методе кластеризации данные группируются таким образом, что одни данные могут принадлежать только одному кластеру.

Пример: К-значит

агломерационных

В этом методе кластеризации все данные являются кластером. Итеративные объединения между двумя ближайшими кластерами уменьшают количество кластеров.

Пример: иерархическая кластеризация

Перекрытие

В этой технике нечеткие множества используются для кластеризации данных. Каждая точка может принадлежать двум или более кластерам с отдельными степенями членства.

Здесь данные будут связаны с соответствующим значением членства. Пример: нечеткие С-средства

вероятностный

Этот метод использует распределение вероятностей для создания кластеров

Пример: следующие ключевые слова

- «мужская обувь».

- «женская обувь».

- «женская перчатка».

- «мужская перчатка».

можно разделить на две категории: «обувь» и «перчатка» или «мужчина» и «женщина».

Типы кластеризации

- Иерархическая кластеризация

- K-означает кластеризацию

- K-NN (k ближайших соседей)

- Анализ главных компонентов

- Разложение по единственному значению

- Независимый компонентный анализ

Иерархическая кластеризация:

Иерархическая кластеризация — это алгоритм, который строит иерархию кластеров. Он начинается со всех данных, которые назначены на собственный кластер. Здесь два близких кластера будут находиться в одном кластере. Этот алгоритм заканчивается, когда остается только один кластер.

K-означает кластеризацию

K означает, что это алгоритм итеративной кластеризации, который помогает вам найти максимальное значение для каждой итерации. Вначале выбирается желаемое количество кластеров. В этом методе кластеризации необходимо разбить точки данных на k групп. Больший k означает меньшие группы с большей гранулярностью таким же образом. Меньшее k означает большие группы с меньшей гранулярностью.

Выход алгоритма представляет собой группу «меток». Он назначает точку данных одной из k групп. В кластеризации k-средних каждая группа определяется путем создания центроида для каждой группы. Центроиды подобны сердцу скопления, которое захватывает точки, ближайшие к ним, и добавляет их к скоплению.

К-средняя кластеризация дополнительно определяет две подгруппы:

- Агломерационная кластеризация

- Дендрограмма

Агломерационная кластеризация:

Этот тип кластеризации K-средних начинается с фиксированного количества кластеров. Он распределяет все данные в точное количество кластеров. Этот метод кластеризации не требует количества кластеров K в качестве входных данных. Процесс агломерации начинается с формирования всех данных в виде одного кластера.

Этот метод использует некоторую меру расстояния, сокращая количество кластеров (по одному в каждой итерации) путем слияния. Наконец, у нас есть один большой кластер, который содержит все объекты.

Дендрограмма:

В методе кластеризации дендрограммы каждый уровень будет представлять возможный кластер. Высота дендрограммы показывает уровень сходства между двумя объединенными кластерами. Чем ближе к сути процесса, тем больше похожий кластер, который находит группу по дендрограмме, что не является естественным и в основном субъективным.

K- Ближайшие соседи

K- ближайший сосед — самый простой из всех классификаторов машинного обучения. Он отличается от других методов машинного обучения тем, что не производит модель. Это простой алгоритм, который хранит все доступные случаи и классифицирует новые экземпляры на основе показателя сходства.

Это работает очень хорошо, когда есть расстояние между примерами. Скорость обучения низкая, когда тренировочный набор большой, а вычисление дистанции нетривиально.

Анализ основных компонентов:

В случае, если вы хотите более многомерное пространство. Вам нужно выбрать базу для этого пространства и только 200 самых важных баллов этой базы. Эта база известна как основной компонент. Подмножество, которое вы выбираете, представляет собой новое пространство, которое имеет небольшой размер по сравнению с исходным пространством. Он поддерживает как можно большую сложность данных.

ассоциация

Правила ассоциации позволяют устанавливать ассоциации между объектами данных в больших базах данных. Эта неконтролируемая техника предназначена для обнаружения интересных связей между переменными в больших базах данных. Например, люди, которые покупают новый дом, чаще всего покупают новую мебель.

Другие примеры:

- Подгруппа больных раком, сгруппированных по измерениям экспрессии генов

- Группы покупателей, основанные на их истории просмотров и покупок

- Фильм группы по рейтингу зрителей

Машинное обучение под присмотром против обучения без присмотра

| параметры | Контролируемая техника машинного обучения | Техника машинного обучения без присмотра |

| Входные данные | Алгоритмы обучаются с использованием помеченных данных. | Алгоритмы используются против данных, которые не помечены |

| Вычислительная сложность | Контролируемое обучение является более простым методом. | Неуправляемое обучение является вычислительно сложным |

| точность | Высокоточный и заслуживающий доверия метод. | Менее точный и заслуживающий доверия метод. |

Применение неконтролируемого машинного обучения

Некоторые применения неконтролируемых методов машинного обучения:

- Кластеризация автоматически разбивает набор данных на группы на основе их сходства

- Обнаружение аномалий может обнаружить необычные точки данных в вашем наборе данных. Это полезно для поиска мошеннических транзакций

- Майнинг ассоциаций определяет наборы элементов, которые часто встречаются в вашем наборе данных

- Модели скрытой переменной широко используются для предварительной обработки данных. Например, уменьшение количества объектов в наборе данных или разбиение набора данных на несколько компонентов.

Недостатки неконтролируемого обучения

- Вы не можете получить точную информацию о сортировке данных, а выходные данные в виде данных, используемых в обучении без учителя, помечены и не известны.

- Меньшая точность результатов объясняется тем, что входные данные неизвестны и не помечены людьми заранее. Это означает, что машина требует сделать это сама.

- Спектральные классы не всегда соответствуют информационным классам.

- Пользователь должен потратить время на интерпретацию и маркировку классов, которые соответствуют этой классификации.

- Спектральные свойства классов также могут изменяться с течением времени, поэтому вы не можете получить ту же информацию о классе при переходе от одного изображения к другому.

Резюме

- Обучение без учителя — это метод машинного обучения, при котором вам не нужно контролировать модель.

- Машинное обучение без присмотра помогает вам находить все виды неизвестных шаблонов в данных.

- Кластеризация и ассоциация — это два типа обучения без учителя.

- Четыре типа методов кластеризации: 1) Эксклюзивный 2) Агломерационный 3) Перекрывающийся 4) Вероятностный.

- Важными типами кластеризации являются: 1) Иерархическая кластеризация 2) Кластеризация K-средних 3) K-NN 4) Анализ главных компонентов 5) Разложение по сингулярным значениям 6) Анализ независимых компонентов.

- Правила ассоциации позволяют устанавливать ассоциации между объектами данных в больших базах данных.

- В контролируемом обучении алгоритмы обучаются с использованием помеченных данных, в то время как в неконтролируемом обучении алгоритмы используются для данных, которые не помечены.

- Обнаружение аномалий может обнаружить важные точки данных в вашем наборе данных, которые полезны для обнаружения мошеннических транзакций.

- Самым большим недостатком обучения без учителя является то, что вы не можете получить точную информацию о сортировке данных.