У нас около сорока одной тысячи с лишним записей. Если мы будем использовать все данные для построения модели, у нас не останется никаких данных для тестирования. Поэтому, как правило, мы разбиваем весь набор данных на две части, скажем, 70/30 процентов. Мы используем 70% данных для построения модели, а остальные — для проверки точности прогноза нашей созданной модели. Вы можете использовать другой коэффициент разделения согласно вашему требованию.

Создание массива объектов

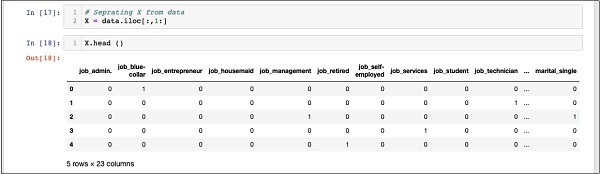

Перед тем, как разделить данные, мы разделяем данные на два массива X и Y. Массив X содержит все объекты (столбцы данных), которые мы хотим проанализировать, а массив Y представляет собой одномерный массив булевых значений, который является выходом прогноз. Чтобы понять это, давайте запустим некоторый код.

Во-первых, выполните следующую инструкцию Python для создания массива X —

In [17]: X = data.iloc[:,1:]

Чтобы проверить содержимое X, используйте head для печати нескольких начальных записей. На следующем экране показано содержимое массива X.

In [18]: X.head ()

Массив имеет несколько строк и 23 столбца.

Далее мы создадим выходной массив, содержащий значения « y ».

Создание выходного массива

Чтобы создать массив для столбца с прогнозируемым значением, используйте следующую инструкцию Python —

In [19]: Y = data.iloc[:,0]

Изучите его содержимое, позвонив главе . На экране ниже показан результат —

In [20]: Y.head() Out[20]: 0 0 1 0 2 1 3 0 4 1 Name: y, dtype: int64

Теперь разделите данные с помощью следующей команды —

In [21]: X_train, X_test, Y_train, Y_test = train_test_split(X, Y, random_state=0)

Это создаст четыре массива с именами X_train, Y_train, X_test и Y_test . Как и раньше, вы можете проверить содержимое этих массивов с помощью команды head. Мы будем использовать массивы X_train и Y_train для обучения нашей модели, а массивы X_test и Y_test — для тестирования и валидации.

Теперь мы готовы построить наш классификатор. Мы рассмотрим это в следующей главе.