Таленд — Введение

Talend является платформой интеграции программного обеспечения, которая предоставляет решения для интеграции данных, качества данных, управления данными, подготовки данных и больших данных. Спрос на профессионалов ETL со знаниями по Talend высок. Кроме того, это единственный инструмент ETL со всеми плагинами, который легко интегрируется с экосистемой больших данных.

Согласно Gartner, Talend попадает в магический квадрант лидеров для инструментов интеграции данных.

Talend предлагает различные коммерческие продукты, как указано ниже —

- Качество данных Talend

- Интеграция данных Talend

- Подготовка данных Talend

- Облако Таленд

- Таленд Большие Данные

- Платформа Talend MDM (Управление основными данными)

- Платформа сервисов данных Talend

- Менеджер метаданных Talend

- Talend Data Fabric

Talend также предлагает Open Studio, бесплатный инструмент с открытым исходным кодом, широко используемый для интеграции данных и больших данных.

Таленд — Системные требования

Ниже приведены системные требования для загрузки и работы в Talend Open Studio.

Рекомендуемая операционная система

- Microsoft Windows 10

- Ubuntu 16.04 LTS

- Apple macOS 10.13 / High Sierra

Требование к памяти

- Память — минимум 4 ГБ, рекомендуется 8 ГБ

- Место для хранения — 30 ГБ

Кроме того, вам также нужен работающий кластер Hadoop (желательно Cloudera.

Примечание. Java 8 должна быть доступна с уже установленными переменными среды.

Таленд — Установка

Чтобы загрузить Talend Open Studio для больших данных и интеграции данных, выполните следующие действия:

Шаг 1 — Перейдите на страницу: https://www.talend.com/products/big-data/big-data-open-studio/ и нажмите кнопку загрузки. Вы видите, что файл TOS_BD_xxxxxxx.zip начинает загружаться.

Шаг 2 — После завершения загрузки извлеките содержимое zip-файла, он создаст папку со всеми файлами Talend в нем.

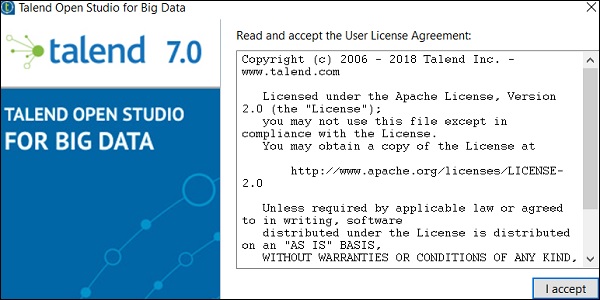

Шаг 3 — Откройте папку Talend и дважды щелкните исполняемый файл: TOS_BD-win-x86_64.exe. Примите Пользовательское лицензионное соглашение.

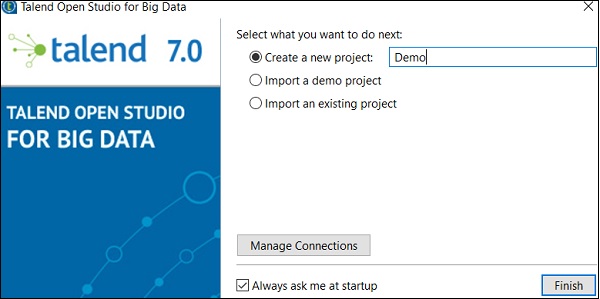

Шаг 4 — Создайте новый проект и нажмите Готово.

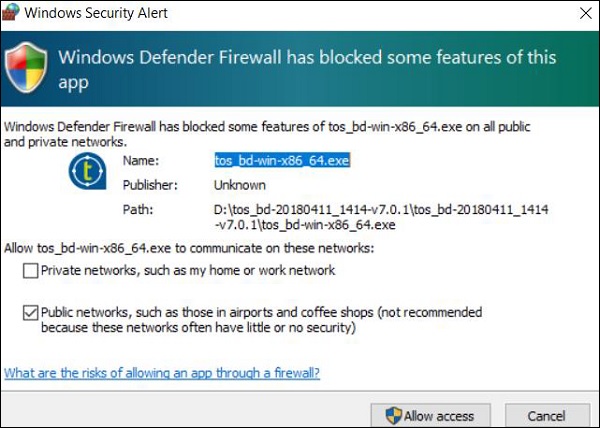

Шаг 5 — Нажмите Разрешить доступ, если вы получили предупреждение безопасности Windows.

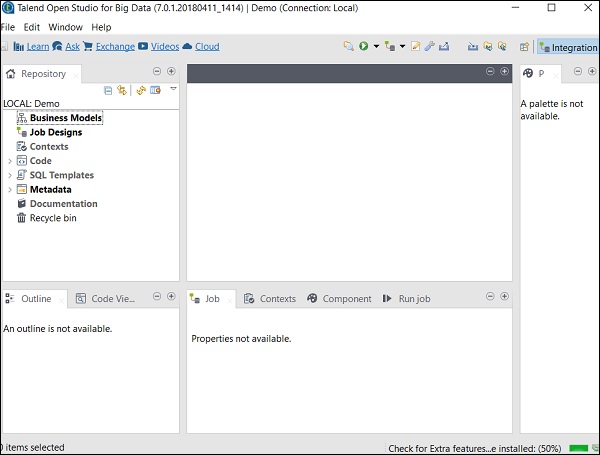

Шаг 6 — Теперь откроется страница приветствия Talend Open Studio.

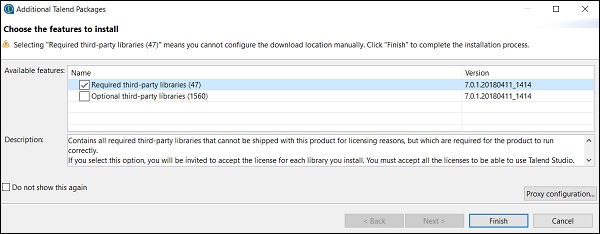

Шаг 7 — Нажмите Готово, чтобы установить необходимые сторонние библиотеки.

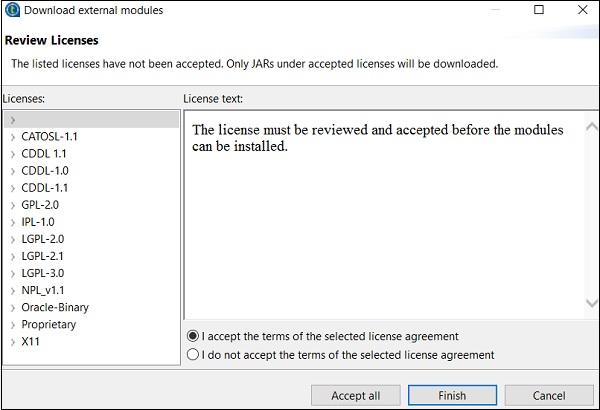

Шаг 8 — Примите условия и нажмите Готово.

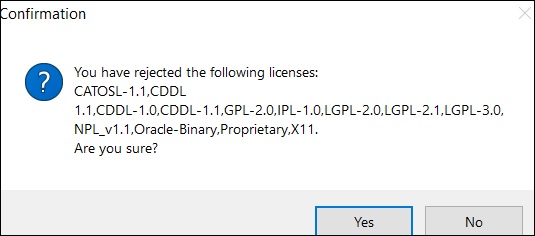

Шаг 9 — Нажмите Да.

Теперь ваша Talend Open Studio готова с необходимыми библиотеками.

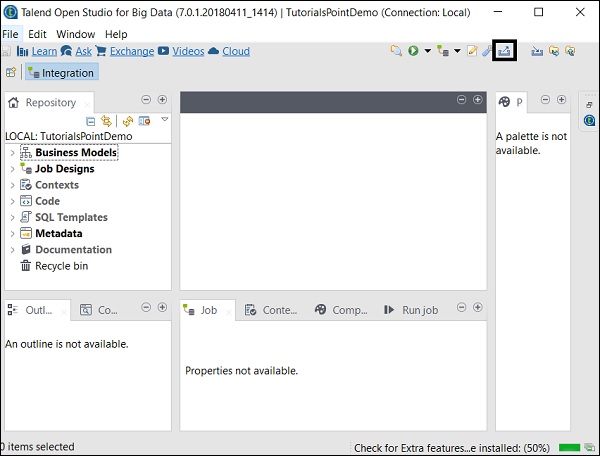

Talend Open Studio

Talend Open Studio — это бесплатный инструмент ETL с открытым исходным кодом для интеграции данных и больших данных. Это инструмент для разработчиков на основе Eclipse и дизайнер заданий. Вам просто нужно перетащить компоненты и соединить их для создания и запуска заданий ETL или ETL. Инструмент автоматически создаст Java-код для задания, и вам не нужно писать ни одной строки кода.

Существует несколько вариантов подключения к источникам данных, таким как RDBMS, Excel, экосистема больших данных SaaS, а также приложения и технологии, такие как SAP, CRM, Dropbox и многие другие.

Ниже перечислены некоторые важные преимущества, которые предлагает Talend Open Studio.

-

Предоставляет все функции, необходимые для интеграции данных и синхронизации с 900 компонентами, встроенными соединителями, автоматического преобразования заданий в код Java и многое другое.

-

Инструмент абсолютно бесплатный, следовательно, есть большая экономия средств.

-

За последние 12 лет несколько гигантских организаций приняли TOS для интеграции данных, что показывает очень высокий фактор доверия к этому инструменту.

-

Сообщество Talend для интеграции данных очень активно.

-

Talend продолжает добавлять функции к этим инструментам, а документация хорошо структурирована и очень проста в использовании.

Предоставляет все функции, необходимые для интеграции данных и синхронизации с 900 компонентами, встроенными соединителями, автоматического преобразования заданий в код Java и многое другое.

Инструмент абсолютно бесплатный, следовательно, есть большая экономия средств.

За последние 12 лет несколько гигантских организаций приняли TOS для интеграции данных, что показывает очень высокий фактор доверия к этому инструменту.

Сообщество Talend для интеграции данных очень активно.

Talend продолжает добавлять функции к этим инструментам, а документация хорошо структурирована и очень проста в использовании.

Talend — интеграция данных

Большинство организаций получают данные из разных мест и хранят их отдельно. Теперь, если организация должна принимать решения, она должна взять данные из разных источников, представить их в едином представлении и затем проанализировать их, чтобы получить результат. Этот процесс называется интеграцией данных.

Выгоды

Интеграция данных предлагает много преимуществ, как описано ниже —

-

Улучшает взаимодействие между различными командами в организации, пытающимися получить доступ к данным организации.

-

Экономит время и облегчает анализ данных, поскольку данные эффективно интегрируются.

-

Процесс автоматической интеграции данных синхронизирует данные и облегчает в режиме реального времени и периодическую отчетность, которая в противном случае занимает много времени, если делается вручную.

-

Данные, интегрированные из нескольких источников, со временем становятся зрелыми и улучшаются, что в конечном итоге способствует повышению качества данных.

Улучшает взаимодействие между различными командами в организации, пытающимися получить доступ к данным организации.

Экономит время и облегчает анализ данных, поскольку данные эффективно интегрируются.

Процесс автоматической интеграции данных синхронизирует данные и облегчает в режиме реального времени и периодическую отчетность, которая в противном случае занимает много времени, если делается вручную.

Данные, интегрированные из нескольких источников, со временем становятся зрелыми и улучшаются, что в конечном итоге способствует повышению качества данных.

Работа с проектами

В этом разделе давайте разберемся, как работать над проектами Talend —

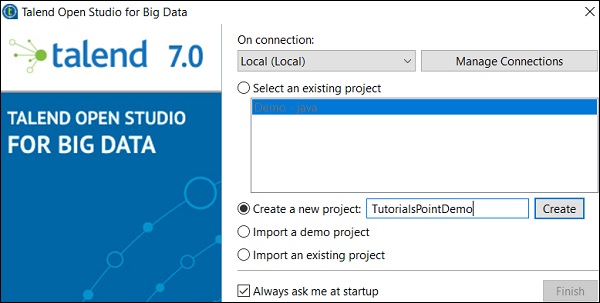

Создание проекта

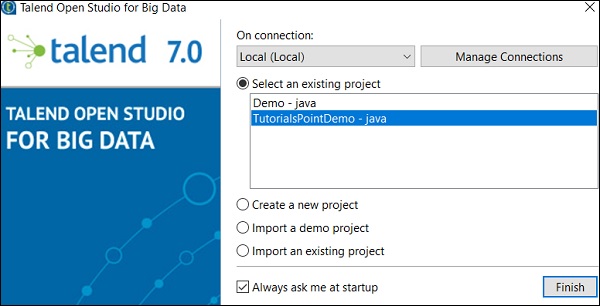

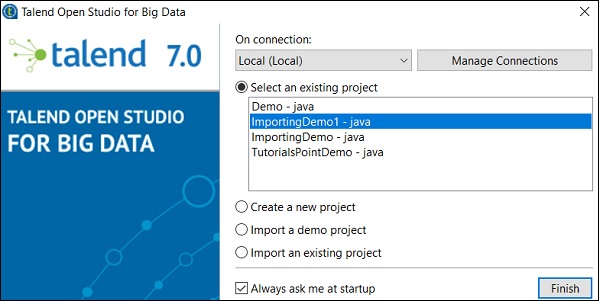

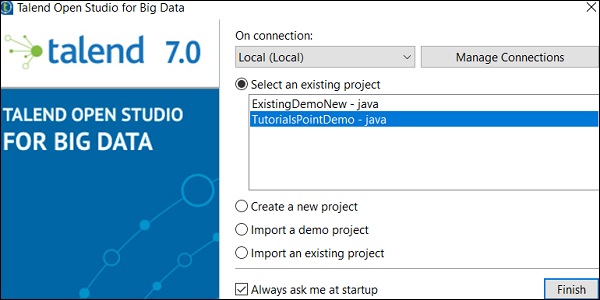

Дважды щелкните исполняемый файл TOS Big Data, откроется окно, показанное ниже.

Выберите «Создать новый проект», укажите название проекта и нажмите «Создать».

Выберите проект, который вы создали, и нажмите Готово.

Импорт проекта

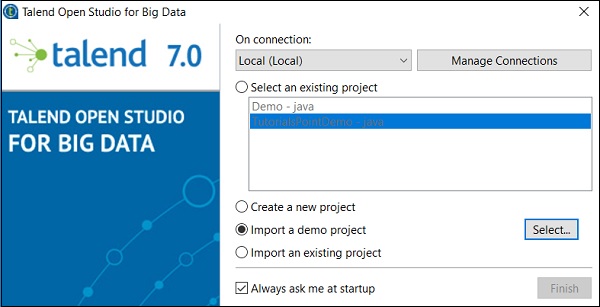

Дважды щелкните исполняемый файл TOS Big Data, вы увидите окно, показанное ниже. Выберите параметр «Импортировать демонстрационный проект» и нажмите «Выбрать».

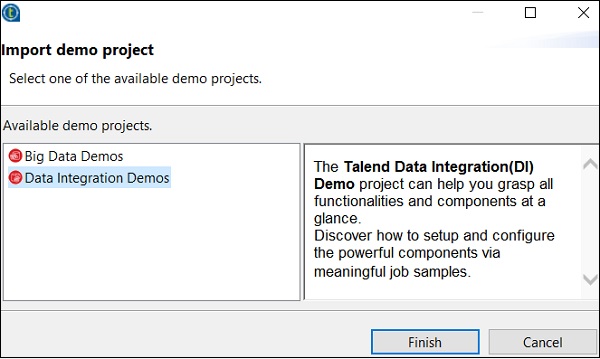

Вы можете выбрать один из вариантов, показанных ниже. Здесь мы выбираем демонстрации интеграции данных. Теперь нажмите Готово.

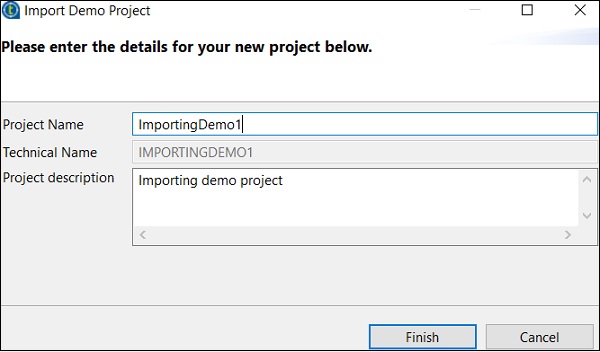

Теперь дайте название проекта и описание. Нажмите Готово.

Вы можете увидеть ваш импортированный проект в списке существующих проектов.

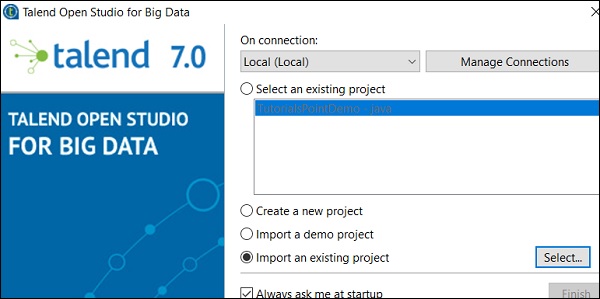

Теперь давайте разберемся, как импортировать существующий проект Talend.

Выберите «Импорт существующего проекта» и нажмите «Выбрать».

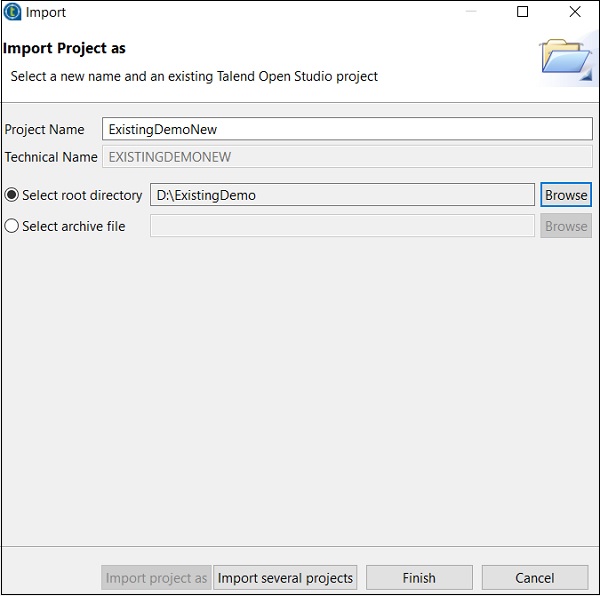

Дайте Имя проекта и выберите опцию «Выбрать корневой каталог».

Просмотрите существующий домашний каталог проекта Talend и нажмите «Готово».

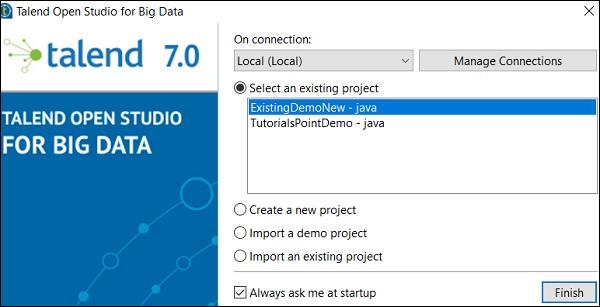

Ваш существующий проект Talend будет импортирован.

Открытие проекта

Выберите проект из существующего проекта и нажмите «Готово». Это откроет тот проект Talend.

Удаление проекта

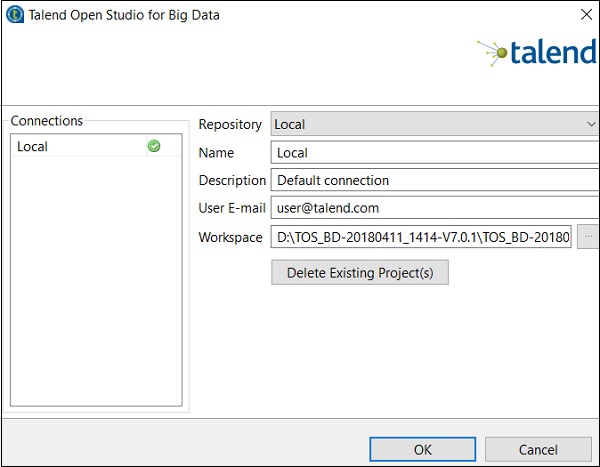

Чтобы удалить проект, нажмите «Управление подключениями».

Нажмите Удалить существующие проекты

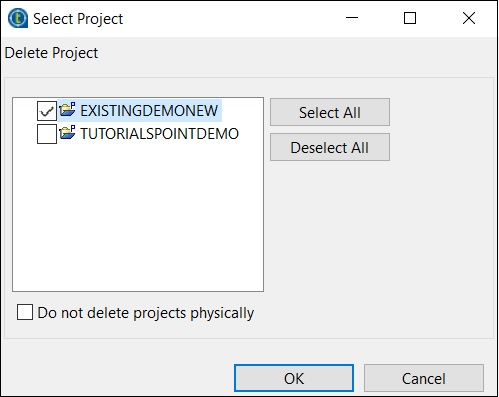

Выберите проект, который вы хотите удалить, и нажмите Ok.

Нажмите ОК еще раз.

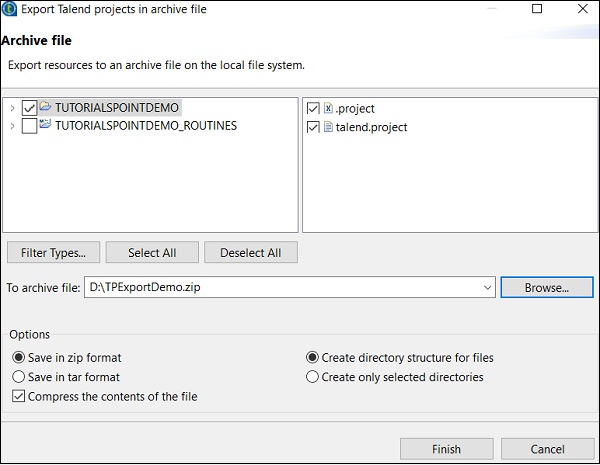

Экспорт проекта

Нажмите «Экспортировать проект».

Выберите проект, который вы хотите экспортировать, и укажите путь, куда он должен быть экспортирован. Нажмите на Готово.

Таленд — Основы модели

Бизнес-модель — это графическое представление проекта интеграции данных. Это нетехническое представление рабочего процесса бизнеса.

Зачем вам нужна бизнес-модель?

Бизнес-модель построена так, чтобы показать высшему руководству, что вы делаете, и она также помогает вашей команде понять, чего вы пытаетесь достичь. Проектирование бизнес-модели считается одной из лучших практик, которые организации применяют в начале своего проекта интеграции данных. Кроме того, помогая сократить расходы, он находит и устраняет узкие места в вашем проекте. При необходимости модель может быть изменена во время и после реализации проекта.

Создание бизнес-модели в Talend Open Studio

Talend open studio предоставляет несколько форм и соединителей для создания и дизайна бизнес-модели. Каждый модуль в бизнес-модели может иметь прикрепленную документацию.

Talend Open Studio предлагает следующие формы и параметры коннектора для создания бизнес-модели:

-

Решение — эта форма используется для помещения условия в модель.

-

Действие — эта форма используется для отображения любого преобразования, перевода или форматирования.

-

Терминал — эта форма показывает тип выходного терминала.

-

Данные — эта форма используется для отображения типа данных.

-

Документ — эта форма используется для вставки объекта документа, который можно использовать для ввода / вывода обработанных данных.

-

Ввод — эта форма используется для вставки объекта ввода, с помощью которого пользователь может передавать данные вручную.

-

Список — эта фигура содержит извлеченные данные, и ее можно определить для хранения только определенных типов данных в списке.

-

База данных — эта форма используется для хранения данных ввода / вывода.

-

Актер — эта форма символизирует людей, вовлеченных в принятие решений и технические процессы

-

Эллипс — вставляет форму эллипса.

Gear — эта фигура показывает ручные программы, которые должны быть заменены заданиями Talend.

Решение — эта форма используется для помещения условия в модель.

Действие — эта форма используется для отображения любого преобразования, перевода или форматирования.

Терминал — эта форма показывает тип выходного терминала.

Данные — эта форма используется для отображения типа данных.

Документ — эта форма используется для вставки объекта документа, который можно использовать для ввода / вывода обработанных данных.

Ввод — эта форма используется для вставки объекта ввода, с помощью которого пользователь может передавать данные вручную.

Список — эта фигура содержит извлеченные данные, и ее можно определить для хранения только определенных типов данных в списке.

База данных — эта форма используется для хранения данных ввода / вывода.

Актер — эта форма символизирует людей, вовлеченных в принятие решений и технические процессы

Эллипс — вставляет форму эллипса.

Gear — эта фигура показывает ручные программы, которые должны быть заменены заданиями Talend.

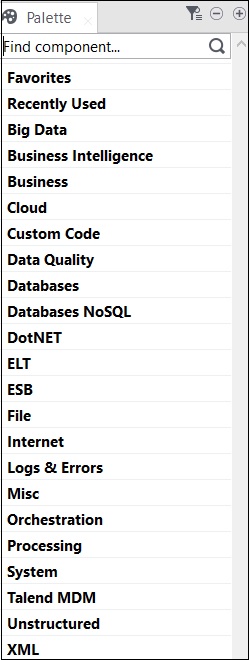

Talend — Компоненты для интеграции данных

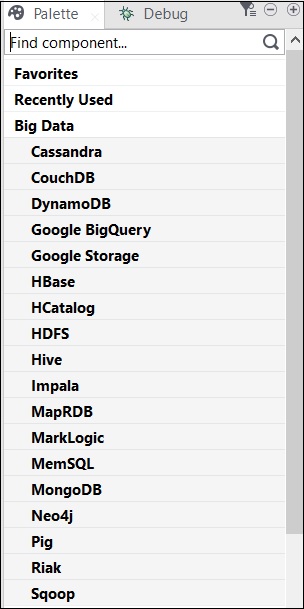

Все операции в Talend выполняются соединителями и компонентами. Talend предлагает более 800 разъемов и компонентов для выполнения нескольких операций. Эти компоненты присутствуют в палитре, и есть 21 основных категорий, к которым относятся компоненты. Вы можете выбрать коннекторы и просто перетащить их в панель дизайнера, это автоматически создаст Java-код, который будет скомпилирован при сохранении кода Talend.

Основные категории, которые содержат компоненты, показаны ниже —

Ниже приведен список широко используемых разъемов и компонентов для интеграции данных в Talend Open Studio.

-

tMysqlConnection — подключается к базе данных MySQL, определенной в компоненте.

-

tMysqlInput — запускает запрос к базе данных, чтобы прочитать базу данных и извлечь поля (таблицы, представления и т. д.) в зависимости от запроса.

-

tMysqlOutput — используется для записи, обновления, изменения данных в базе данных MySQL.

-

tFileInputDelimited — Считывает файл за строкой с разделителями, разделяет их на отдельные поля и передает их следующему компоненту.

-

tFileInputExcel — Считывает файл Excel по строкам, разделяет их на отдельные поля и передает их следующему компоненту.

-

tFileList — получает все файлы и каталоги из заданного шаблона маски файла.

-

tFileArchive — сжимает набор файлов или папок в архивный файл zip, gzip или tar.gz.

-

tRowGenerator — предоставляет редактор, в котором вы можете писать функции или выбирать выражения для генерации ваших образцов данных.

-

tMsgBox — возвращает диалоговое окно с указанным сообщением и кнопкой ОК.

-

tLogRow — отслеживает обработку данных. Он отображает данные / вывод в консоли запуска.

-

tPreJob — Определяет вспомогательные задания, которые будут запущены до того, как начнется ваше фактическое задание.

-

tMap — действует как плагин в студии Talend. Он берет данные из одного или нескольких источников, преобразует их, а затем отправляет преобразованные данные одному или нескольким получателям.

-

tJoin — объединяет 2 таблицы, выполняя внутренние и внешние соединения между основным потоком и потоком поиска.

-

tJava — позволяет использовать персонализированный код Java в программе Talend.

-

tRunJob — Управляет сложными системами заданий, выполняя одно задание Talend за другим.

tMysqlConnection — подключается к базе данных MySQL, определенной в компоненте.

tMysqlInput — запускает запрос к базе данных, чтобы прочитать базу данных и извлечь поля (таблицы, представления и т. д.) в зависимости от запроса.

tMysqlOutput — используется для записи, обновления, изменения данных в базе данных MySQL.

tFileInputDelimited — Считывает файл за строкой с разделителями, разделяет их на отдельные поля и передает их следующему компоненту.

tFileInputExcel — Считывает файл Excel по строкам, разделяет их на отдельные поля и передает их следующему компоненту.

tFileList — получает все файлы и каталоги из заданного шаблона маски файла.

tFileArchive — сжимает набор файлов или папок в архивный файл zip, gzip или tar.gz.

tRowGenerator — предоставляет редактор, в котором вы можете писать функции или выбирать выражения для генерации ваших образцов данных.

tMsgBox — возвращает диалоговое окно с указанным сообщением и кнопкой ОК.

tLogRow — отслеживает обработку данных. Он отображает данные / вывод в консоли запуска.

tPreJob — Определяет вспомогательные задания, которые будут запущены до того, как начнется ваше фактическое задание.

tMap — действует как плагин в студии Talend. Он берет данные из одного или нескольких источников, преобразует их, а затем отправляет преобразованные данные одному или нескольким получателям.

tJoin — объединяет 2 таблицы, выполняя внутренние и внешние соединения между основным потоком и потоком поиска.

tJava — позволяет использовать персонализированный код Java в программе Talend.

tRunJob — Управляет сложными системами заданий, выполняя одно задание Talend за другим.

Таленд — Работа Дизайн

Это техническая реализация / графическое представление бизнес-модели. В этом проекте один или несколько компонентов связаны друг с другом для запуска процесса интеграции данных. Таким образом, когда вы перетаскиваете компоненты на панели проектирования и затем соединяетесь с помощью соединителей, проект задания преобразует все в код и создает полную работоспособную программу, которая формирует поток данных.

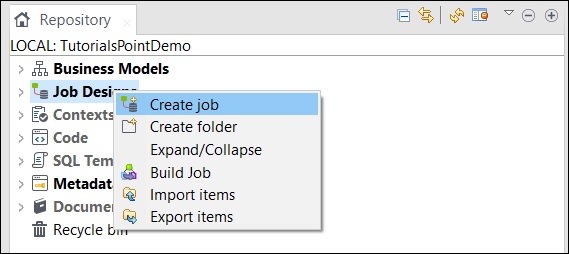

Создание работы

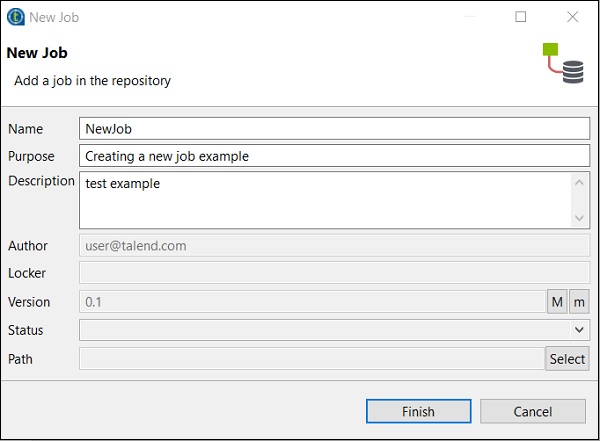

В окне репозитория щелкните правой кнопкой мыши проект задания и выберите «Создать задание».

Укажите название, цель и описание задания и нажмите «Готово».

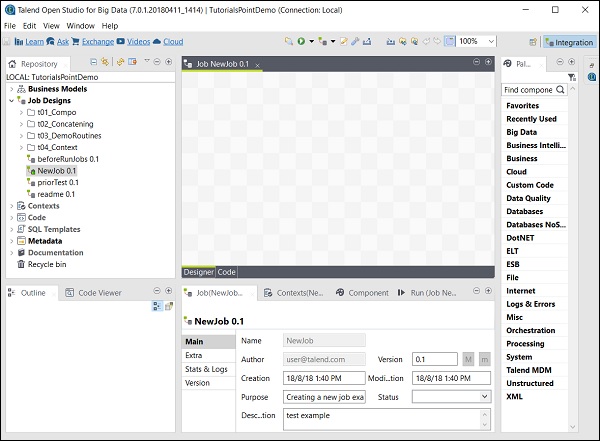

Вы можете видеть, что ваша работа была создана в Job Design.

Теперь давайте воспользуемся этим заданием для добавления компонентов, их подключения и настройки. Здесь мы возьмем файл Excel в качестве входных данных и создадим файл Excel в качестве выходных данных с теми же данными.

Добавление компонентов в работу

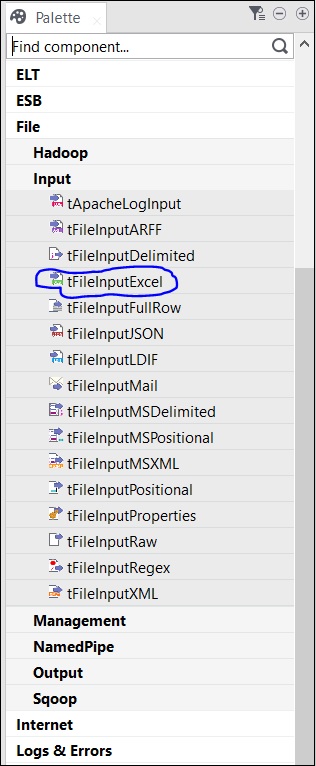

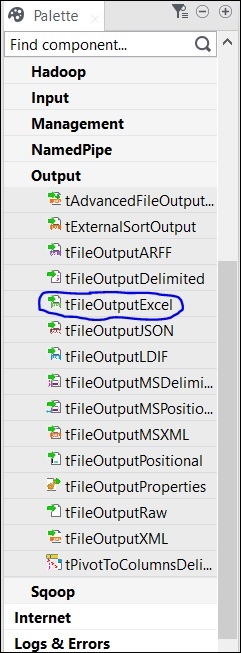

В палитре есть несколько компонентов на выбор. Существует также опция поиска, в которой вы можете ввести имя компонента, чтобы выбрать его.

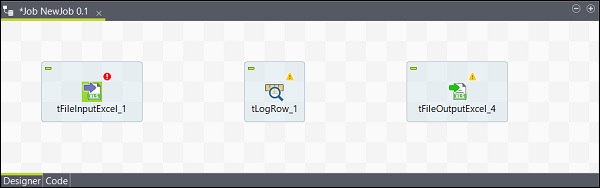

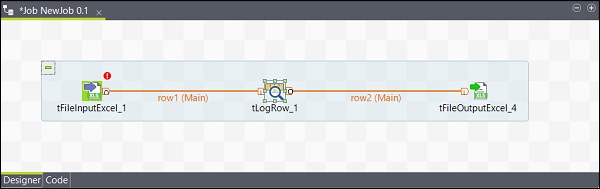

Так как здесь мы берем файл Excel в качестве входных данных, мы перетащим компонент tFileInputExcel из палитры в окно Designer.

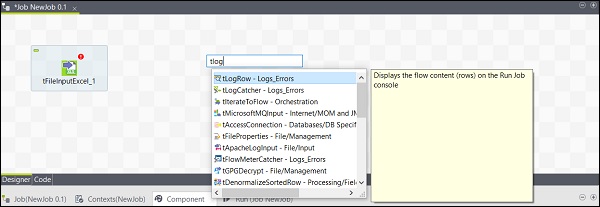

Теперь, если вы щелкнете где-нибудь в окне дизайнера, появится окно поиска. Найдите tLogRow и выберите его, чтобы отобразить в окне дизайнера.

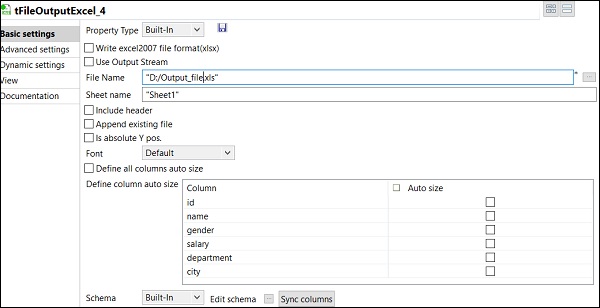

Наконец, выберите компонент tFileOutputExcel из палитры и перетащите его в окно дизайнера.

Теперь добавление компонентов завершено.

Подключение компонентов

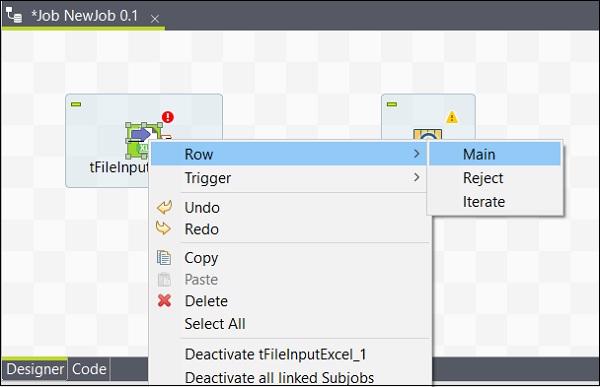

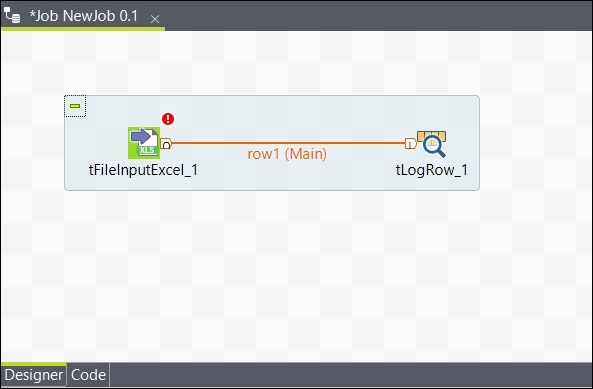

После добавления компонентов их необходимо подключить. Щелкните правой кнопкой мыши первый компонент tFileInputExcel и нарисуйте главную линию для tLogRow, как показано ниже.

Аналогично, щелкните правой кнопкой мыши tLogRow и нарисуйте главную линию на tFileOutputExcel. Теперь ваши компоненты подключены.

Конфигурирование компонентов

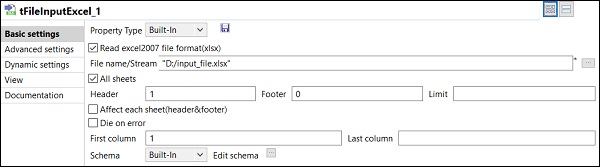

После добавления и подключения компонентов в задании их необходимо настроить. Для этого дважды щелкните первый компонент tFileInputExcel, чтобы настроить его. Укажите путь к вашему входному файлу в поле «Имя файла / поток», как показано ниже.

Если ваша первая строка в Excel имеет имена столбцов, поставьте 1 в опции Header.

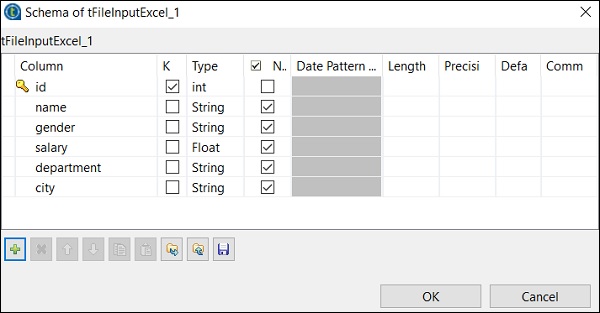

Нажмите Изменить схему и добавьте столбцы и их тип в соответствии с вашим входным файлом Excel. Нажмите Ok после добавления схемы.

Нажмите Да.

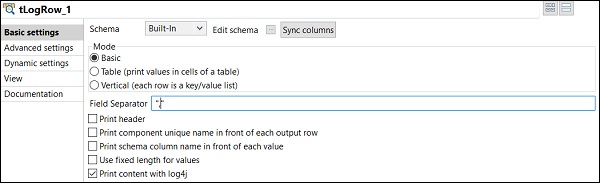

В компоненте tLogRow щелкните по столбцам синхронизации и выберите режим, в котором вы хотите сгенерировать строки из вашего ввода. Здесь мы выбрали основной режим с «,» в качестве разделителя полей.

Наконец, в компоненте tFileOutputExcel укажите путь к имени файла, в котором вы хотите хранить

ваш выходной файл Excel с именем листа. Нажмите на синхронизировать столбцы .

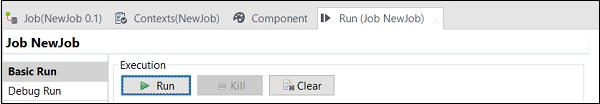

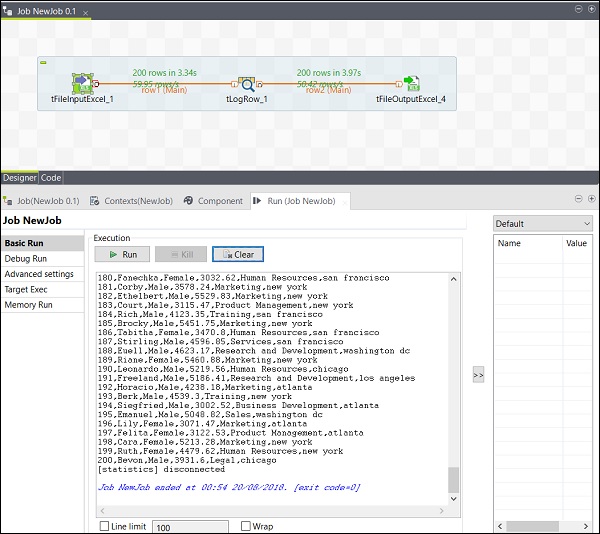

Выполнение работы

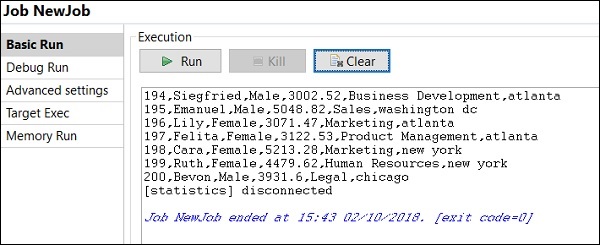

Как только вы закончите с добавлением, подключением и настройкой ваших компонентов, вы будете готовы выполнить задание Talend. Нажмите кнопку «Выполнить», чтобы начать выполнение.

Вы увидите вывод в основном режиме с разделителем «,».

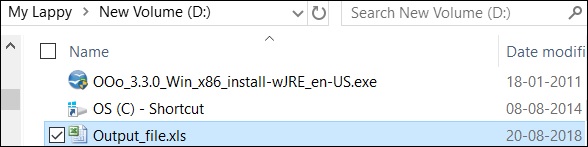

Вы также можете видеть, что ваши выходные данные сохраняются в формате Excel на указанном вами пути вывода.

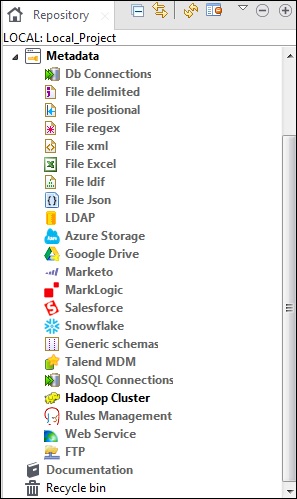

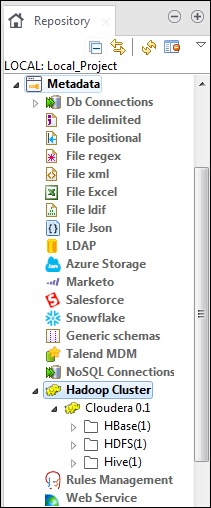

Таленд — Метаданные

Метаданные в основном означают данные о данных. Он рассказывает о том, что, когда, почему, кто, где, что и как данных. В Talend метаданные содержат всю информацию о данных, которые присутствуют в Talend studio. Параметр метаданных присутствует на панели репозитория Talend Open Studio.

Различные источники, такие как соединения с БД, различные типы файлов, LDAP, Azure, Salesforce, FTP веб-служб, кластер Hadoop и многие другие параметры представлены в разделе Метаданные Talend.

Основное использование метаданных в Talend Open Studio заключается в том, что эти источники данных можно использовать в нескольких заданиях простым перетаскиванием из метаданных на панели репозитория.

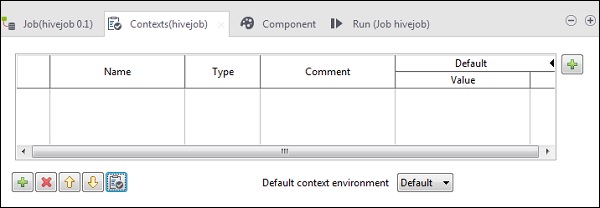

Talend — контекстные переменные

Контекстные переменные — это переменные, которые могут иметь разные значения в разных средах. Вы можете создать контекстную группу, которая может содержать несколько переменных контекста. Вам не нужно добавлять каждую переменную контекста одну за другой в работу, вы можете просто добавить группу контекста в работу.

Эти переменные используются для подготовки кода. Его средства с помощью переменных контекста позволяют перемещать код в средах разработки, тестирования или производства, он будет работать во всех средах.

В любой работе вы можете перейти на вкладку Контексты, как показано ниже, и добавить переменные контекста.

Talend — Управление работой

В этой главе давайте рассмотрим управление заданиями и соответствующими функциями, включенными в Talend.

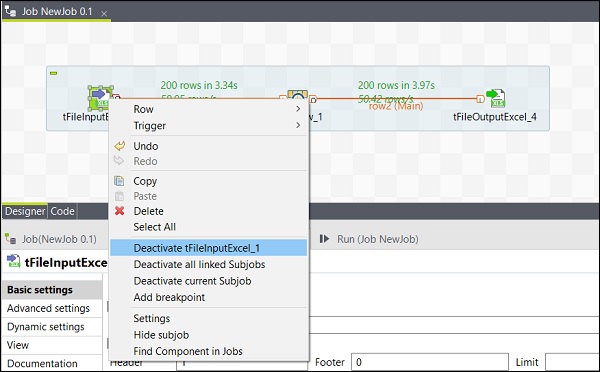

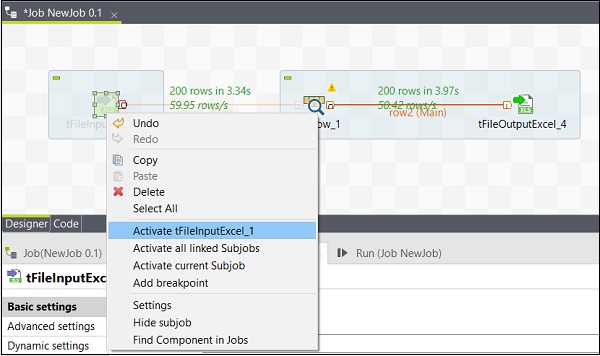

Активация / деактивация компонента

Активировать / деактивировать компонент очень просто. Вам просто нужно выбрать компонент, щелкнуть по нему правой кнопкой мыши и выбрать деактивировать или активировать этот компонент.

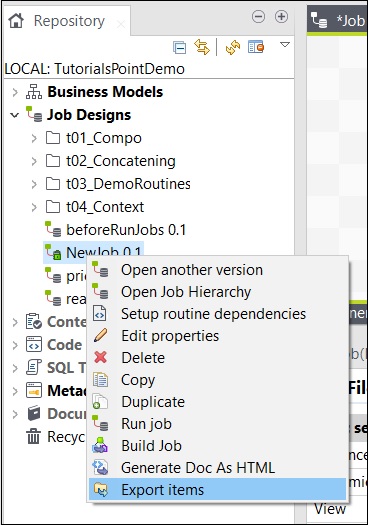

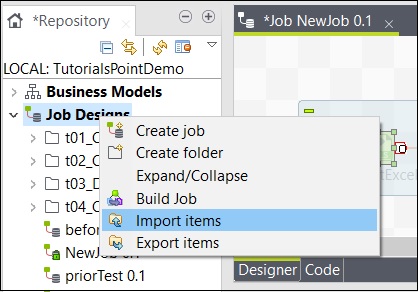

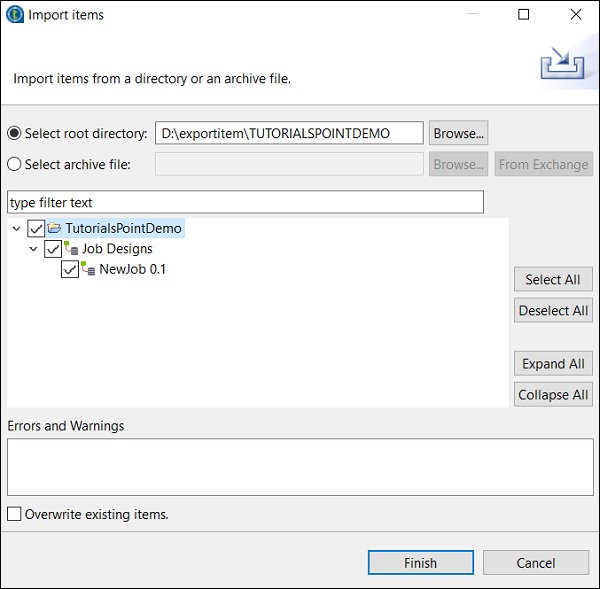

Импорт / экспорт предметов и строительных работ

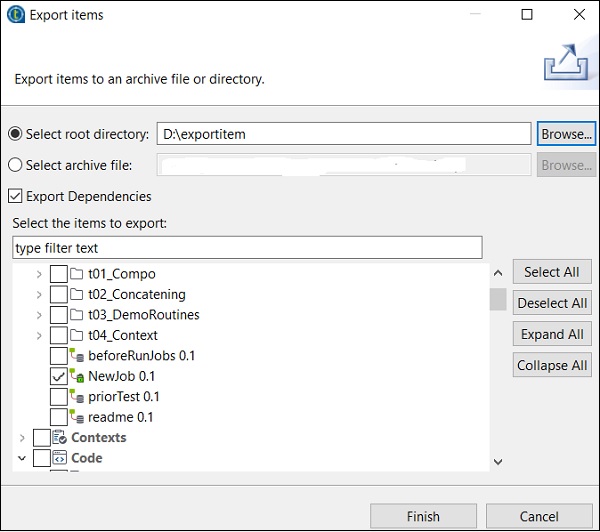

Чтобы экспортировать элемент из задания, щелкните правой кнопкой мыши на задании в дизайне заданий и выберите «Экспорт элементов».

Введите путь, по которому вы хотите экспортировать элемент, и нажмите «Готово».

Чтобы импортировать элемент из задания, щелкните правой кнопкой мыши на задании в дизайне заданий и выберите «Импорт элементов».

Найдите корневой каталог, из которого вы хотите импортировать элементы.

Установите все флажки и нажмите «Готово».

Talend — обработка выполнения работы

В этой главе давайте разберемся с обработкой выполнения задания в Talend.

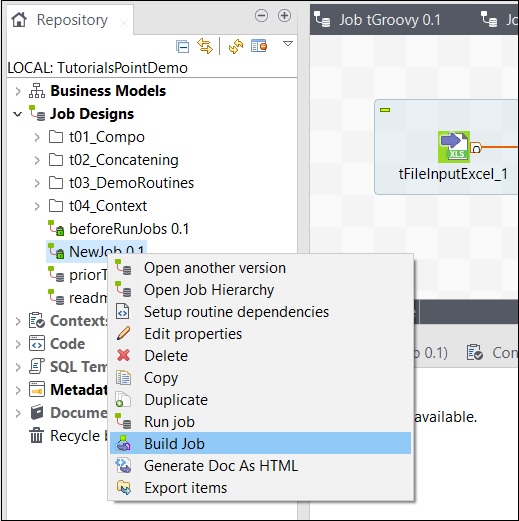

Чтобы построить задание, щелкните правой кнопкой мыши задание и выберите параметр «Создать задание».

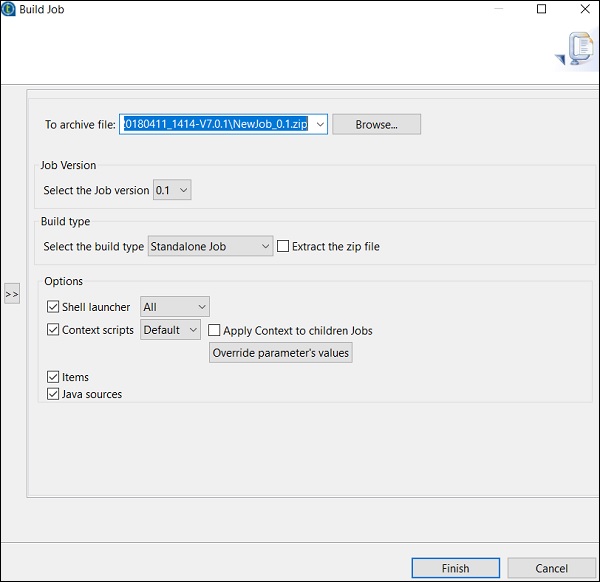

Укажите путь, по которому вы хотите заархивировать работу, выберите версию работы и тип сборки, затем нажмите «Готово».

Как запустить работу в обычном режиме

Чтобы запустить задание на обычном узле, вам нужно выбрать «Базовый запуск» и нажать кнопку «Выполнить», чтобы начать выполнение.

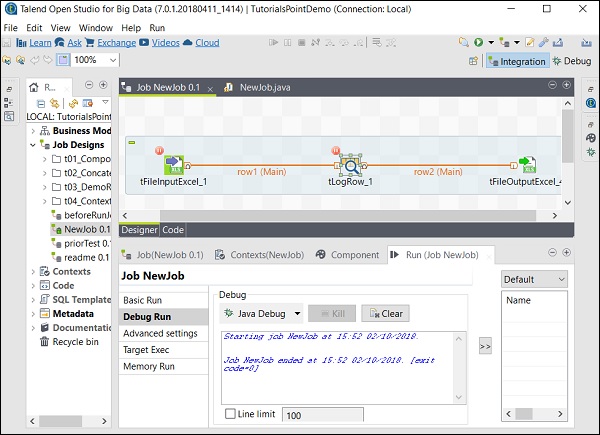

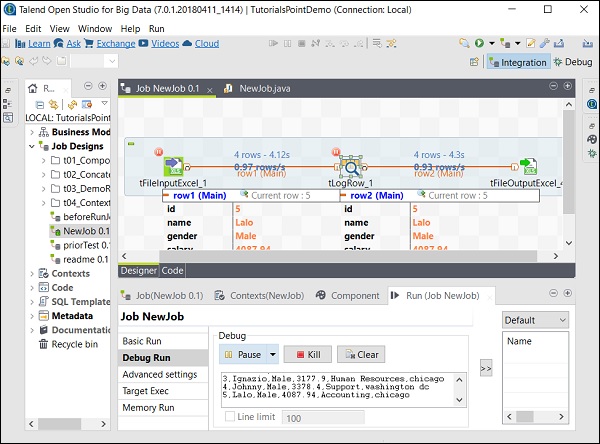

Как запустить задание в режиме отладки

Чтобы запустить задание в режиме отладки, добавьте точку останова к компонентам, которые вы хотите отладить.

Затем выберите и щелкните правой кнопкой мыши компонент, выберите опцию Добавить точку останова. Обратите внимание, что здесь мы добавили точки останова для компонентов tFileInputExcel и tLogRow. Затем перейдите в Debug Run и нажмите кнопку Java Debug.

На следующем снимке экрана видно, что задание теперь будет выполняться в режиме отладки и в соответствии с точками останова, которые мы упомянули.

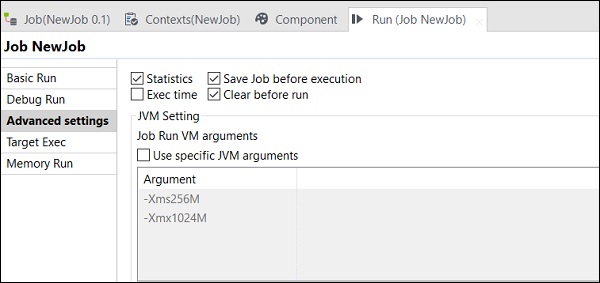

Расширенные настройки

В разделе «Дополнительные настройки» вы можете выбрать «Статистика», «Время выполнения», «Сохранить работу перед выполнением», «Очистить перед выполнением» и «Настройки JVM». Каждый из этих вариантов имеет функциональность, как описано здесь —

-

Статистика — отображает показатель производительности обработки;

-

Exec Time — время, затраченное на выполнение задания.

-

Сохранить задание перед выполнением — автоматически сохраняет задание до начала выполнения.

-

Очистить перед запуском — Удаляет все из консоли вывода.

-

Настройки JVM — Помогает нам настроить собственные аргументы Java.

Статистика — отображает показатель производительности обработки;

Exec Time — время, затраченное на выполнение задания.

Сохранить задание перед выполнением — автоматически сохраняет задание до начала выполнения.

Очистить перед запуском — Удаляет все из консоли вывода.

Настройки JVM — Помогает нам настроить собственные аргументы Java.

Таленд — Большие данные

Строка тега для Open Studio с большими данными: «Упростите ETL и ELT с помощью ведущего бесплатного ETL-инструмента с открытым исходным кодом для больших данных». В этой главе мы рассмотрим использование Talend в качестве инструмента для обработки данных в среде больших данных. ,

Вступление

Talend Open Studio — Big Data — это бесплатный инструмент с открытым исходным кодом для очень простой обработки ваших данных в среде больших данных. В Talend Open Studio имеется множество компонентов с большими данными, которые позволяют создавать и запускать задания Hadoop простым перетаскиванием нескольких компонентов Hadoop.

Кроме того, нам не нужно писать большие строки кодов MapReduce; Talend Open Studio Большие данные помогут вам сделать это с помощью компонентов, присутствующих в нем. Он автоматически генерирует код MapReduce для вас, вам просто нужно перетащить компоненты и настроить несколько параметров.

Это также дает вам возможность подключиться к нескольким дистрибутивам больших данных, таким как Cloudera, HortonWorks, MapR, Amazon EMR и даже Apache.

Компоненты Talend для больших данных

Список категорий с компонентами для выполнения задания в среде больших данных, включенных в Big Data, показан ниже —

Список соединителей и компонентов Big Data в Talend Open Studio показан ниже —

-

tHDFSConnection — используется для подключения к HDFS (распределенная файловая система Hadoop).

-

tHDFSInput — читает данные по заданному пути hdfs, помещает их в схему talend и затем передает их следующему компоненту в задании.

-

tHDFSList — извлекает все файлы и папки по указанному пути hdfs.

-

tHDFSPut — копирует файл / папку из локальной файловой системы (определяемой пользователем) в hdf по указанному пути.

-

tHDFSGet — Копирует файл / папку из hdfs в локальную файловую систему (определяется пользователем) по заданному пути.

-

tHDFSDelete — удаляет файл из HDFS

-

tHDFSExist — Проверяет, присутствует ли файл в HDFS или нет.

-

tHDFSOutput — записывает потоки данных в HDFS.

-

tCassandraConnection — открывает соединение с сервером Cassandra.

-

tCassandraRow — Запускает CQL (язык запросов Cassandra) в указанной базе данных.

-

tHBaseConnection — открывает соединение с базой данных HBase.

-

tHBaseInput — читает данные из базы данных HBase.

-

tHiveConnection — открывает соединение с базой данных Hive.

-

tHiveCreateTable — создает таблицу в базе данных кустов .

-

tHiveInput — читает данные из базы данных улья.

-

tHiveLoad — записывает данные в таблицу кустов или в указанный каталог.

-

tHiveRow — выполняет запросы HiveQL к указанной базе данных.

-

tPigLoad — загружает входные данные в выходной поток.

-

tPigMap — используется для преобразования и маршрутизации данных в процессе PIG .

-

tPigJoin — выполняет операцию объединения двух файлов на основе ключей соединения.

-

tPigCoGroup — группирует и объединяет данные, поступающие с нескольких входов.

-

tPigSort — сортирует данные на основе одного или нескольких определенных ключей сортировки.

-

tPigStoreResult — Сохраняет результат операции PIG в определенной области памяти.

-

tPigFilterRow — фильтрует указанные столбцы, чтобы разделить данные на основе заданного условия.

-

tPigDistinct — удаляет дубликаты кортежей из отношения.

-

tSqoopImport — переносит данные из реляционной базы данных, такой как MySQL, Oracle DB, в HDFS.

-

tSqoopExport — переносит данные из HDFS в реляционную базу данных, такую как MySQL, Oracle DB

tHDFSConnection — используется для подключения к HDFS (распределенная файловая система Hadoop).

tHDFSInput — читает данные по заданному пути hdfs, помещает их в схему talend и затем передает их следующему компоненту в задании.

tHDFSList — извлекает все файлы и папки по указанному пути hdfs.

tHDFSPut — копирует файл / папку из локальной файловой системы (определяемой пользователем) в hdf по указанному пути.

tHDFSGet — Копирует файл / папку из hdfs в локальную файловую систему (определяется пользователем) по заданному пути.

tHDFSDelete — удаляет файл из HDFS

tHDFSExist — Проверяет, присутствует ли файл в HDFS или нет.

tHDFSOutput — записывает потоки данных в HDFS.

tCassandraConnection — открывает соединение с сервером Cassandra.

tCassandraRow — Запускает CQL (язык запросов Cassandra) в указанной базе данных.

tHBaseConnection — открывает соединение с базой данных HBase.

tHBaseInput — читает данные из базы данных HBase.

tHiveConnection — открывает соединение с базой данных Hive.

tHiveCreateTable — создает таблицу в базе данных кустов .

tHiveInput — читает данные из базы данных улья.

tHiveLoad — записывает данные в таблицу кустов или в указанный каталог.

tHiveRow — выполняет запросы HiveQL к указанной базе данных.

tPigLoad — загружает входные данные в выходной поток.

tPigMap — используется для преобразования и маршрутизации данных в процессе PIG .

tPigJoin — выполняет операцию объединения двух файлов на основе ключей соединения.

tPigCoGroup — группирует и объединяет данные, поступающие с нескольких входов.

tPigSort — сортирует данные на основе одного или нескольких определенных ключей сортировки.

tPigStoreResult — Сохраняет результат операции PIG в определенной области памяти.

tPigFilterRow — фильтрует указанные столбцы, чтобы разделить данные на основе заданного условия.

tPigDistinct — удаляет дубликаты кортежей из отношения.

tSqoopImport — переносит данные из реляционной базы данных, такой как MySQL, Oracle DB, в HDFS.

tSqoopExport — переносит данные из HDFS в реляционную базу данных, такую как MySQL, Oracle DB

Talend — распределенная файловая система Hadoop

В этой главе мы подробно узнаем о том, как Talend работает с распределенной файловой системой Hadoop.

Настройки и предварительные условия

Прежде чем мы перейдем к Talend с HDFS, мы должны узнать о настройках и предварительных условиях, которые должны быть выполнены для этой цели.

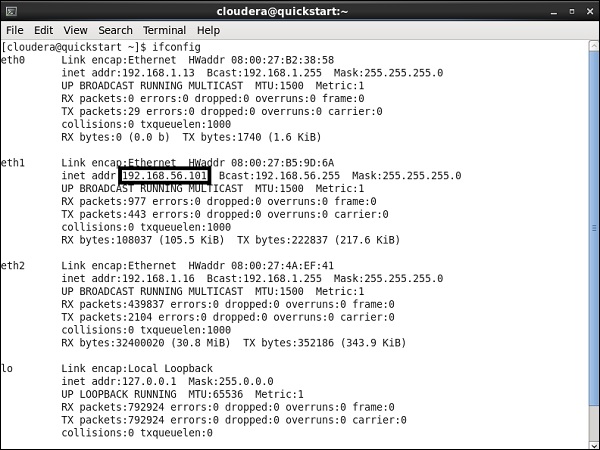

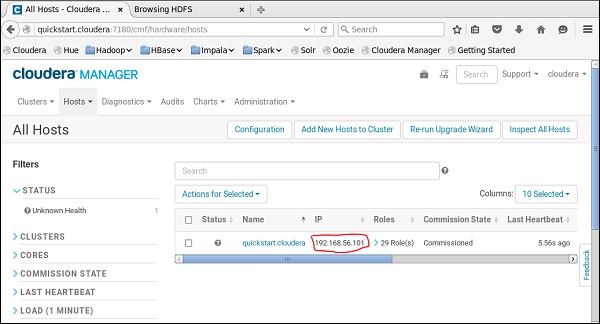

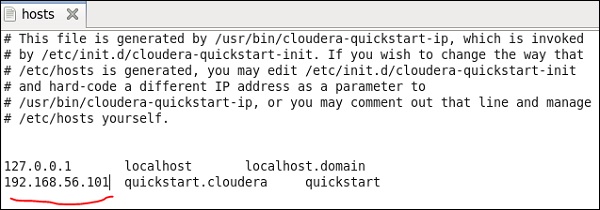

Здесь мы запускаем Cloudera quickstart 5.10 VM на виртуальной коробке. В этой виртуальной машине должна использоваться сеть только для хоста.

IP-адрес только для хоста: 192.168.56.101

У вас должен быть тот же хост, работающий на менеджере Cloudera.

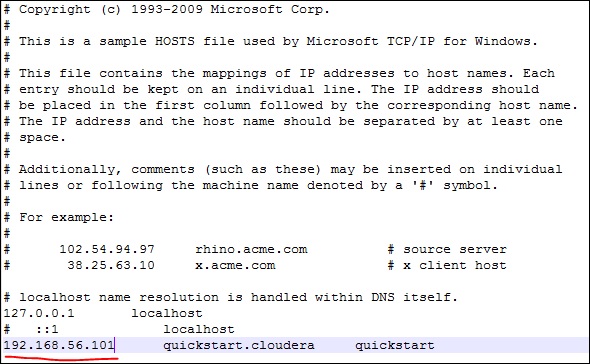

Теперь в вашей системе Windows перейдите в c: \ Windows \ System32 \ Drivers \ etc \ hosts и отредактируйте этот файл с помощью Блокнота, как показано ниже.

Аналогично, на вашей виртуальной машине cloudera quickstart отредактируйте файл / etc / hosts, как показано ниже.

sudo gedit /etc/hosts

Настройка подключения Hadoop

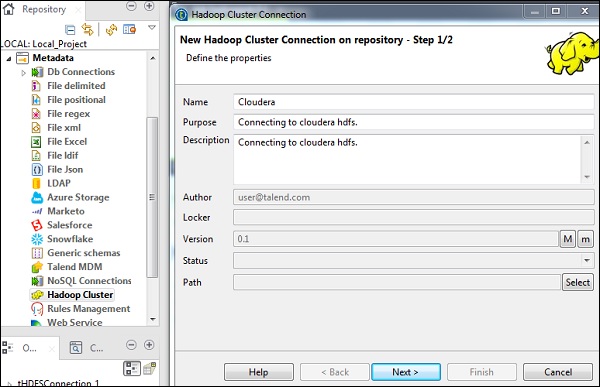

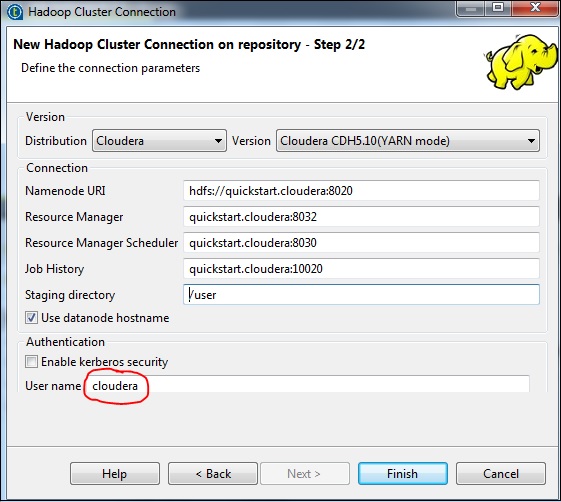

На панели хранилища перейдите в раздел Метаданные. Щелкните правой кнопкой мыши Hadoop Cluster и создайте новый кластер. Укажите имя, назначение и описание для этого кластерного соединения Hadoop.

Нажмите кнопку «Далее.

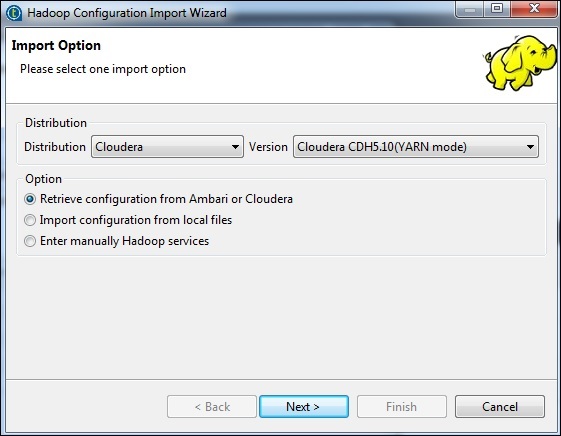

Выберите дистрибутив как cloudera и выберите версию, которую вы используете. Выберите опцию получения конфигурации и нажмите «Далее».

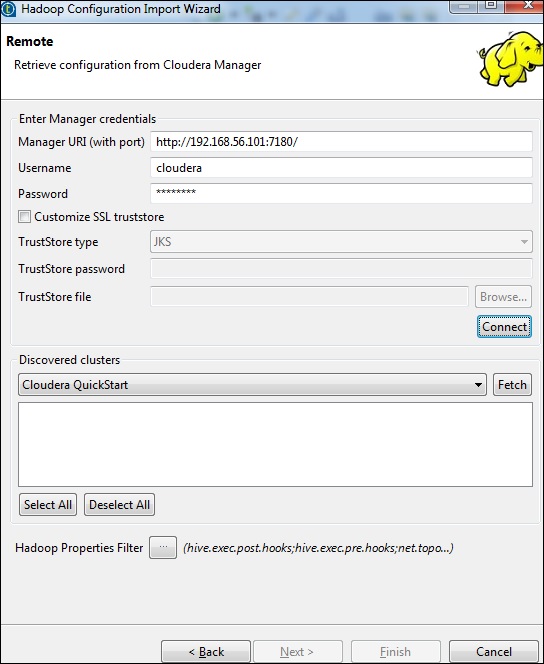

Введите учетные данные менеджера (URI с портом, именем пользователя, паролем), как показано ниже, и нажмите «Подключиться». Если данные верны, вы получите Cloudera QuickStart под обнаруженными кластерами.

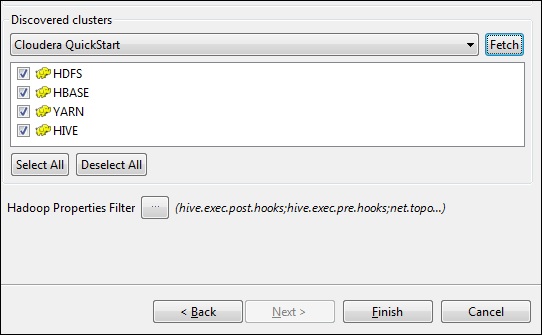

Нажмите «Получить». Это позволит получить все соединения и конфигурации для HDFS, YARN, HBASE, HIVE.

Выберите Все и нажмите Готово.

Обратите внимание, что все параметры подключения будут заполнены автоматически. Укажите cloudera в имени пользователя и нажмите Finish.

Благодаря этому вы успешно подключились к кластеру Hadoop.

Подключение к HDFS

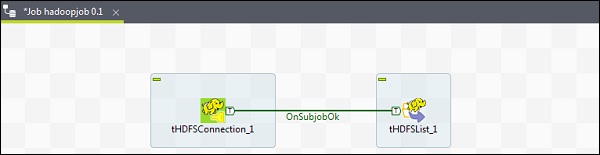

В этой работе мы перечислим все каталоги и файлы, которые присутствуют в HDFS.

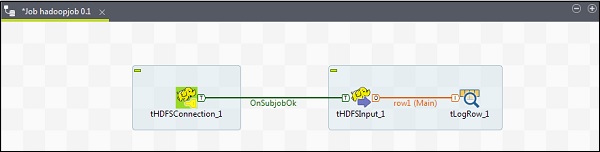

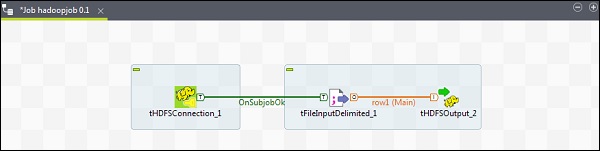

Сначала мы создадим задание, а затем добавим к нему компоненты HDFS. Щелкните правой кнопкой мыши на Job Design и создайте новую работу — hadoopjob.

Теперь добавьте 2 компонента из палитры — tHDFSConnection и tHDFSList. Щелкните правой кнопкой мыши tHDFSConnection и соедините эти 2 компонента, используя триггер OnSubJobOk.

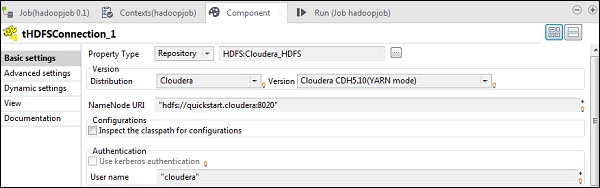

Теперь настройте оба компонента talend hdfs.

В tHDFSConnection выберите «Хранилище» в качестве типа свойства и выберите кластер Hadoop cloudera, который вы создали ранее. Он автоматически заполнит все необходимые данные, необходимые для этого компонента.

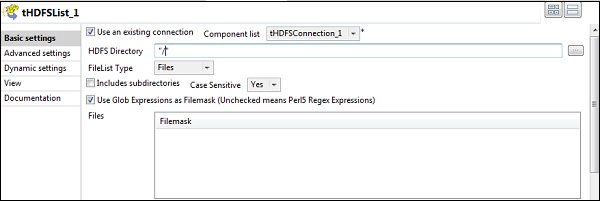

В tHDFSList выберите «Использовать существующее соединение», а в списке компонентов выберите настроенное соединение tHDFSConnection.

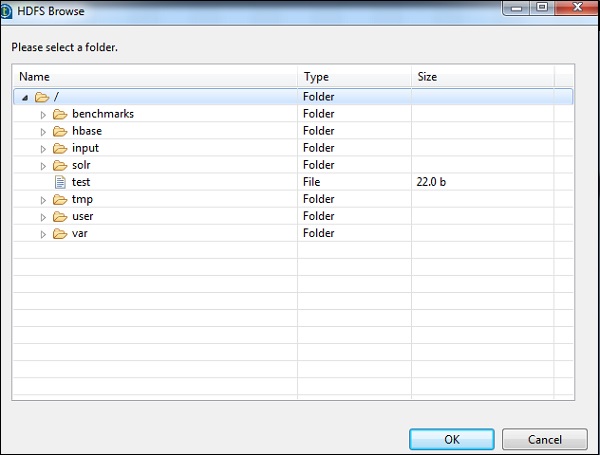

Укажите домашний путь HDFS в каталоге HDFS и нажмите кнопку обзора справа.

Если вы правильно установили соединение с вышеупомянутыми конфигурациями, вы увидите окно, показанное ниже. В нем будут перечислены все каталоги и файлы, имеющиеся на домашней HDFS.

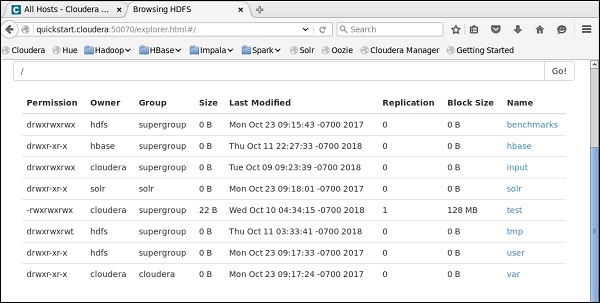

Вы можете убедиться в этом, проверив HDFS на cloudera.

Чтение файла из HDFS

В этом разделе давайте разберемся, как читать файл из HDFS в Talend. Вы можете создать новую работу для этой цели, однако здесь мы используем существующую.

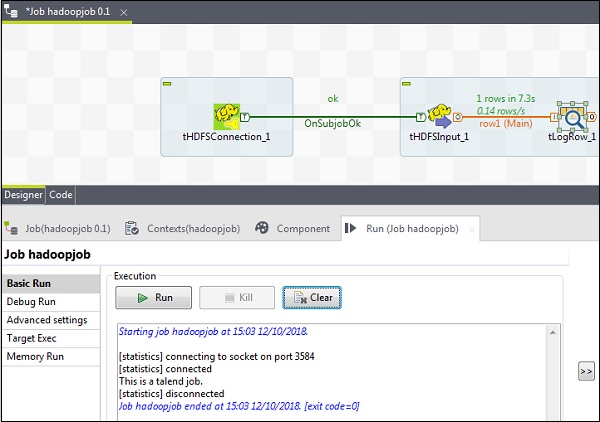

Перетащите 3 компонента — tHDFSConnection, tHDFSInput и tLogRow из палитры в окно конструктора.

Щелкните правой кнопкой мыши tHDFSConnection и подключите компонент tHDFSInput с помощью триггера OnSubJobOk.

Щелкните правой кнопкой мыши tHDFSInput и перетащите основную ссылку на tLogRow.

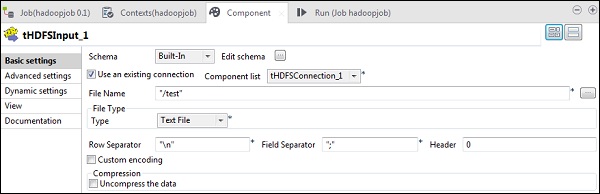

Обратите внимание, что tHDFSConnection будет иметь конфигурацию, аналогичную ранее. В tHDFSInput выберите «Использовать существующее соединение» и в списке компонентов выберите tHDFSConnection.

В поле Имя файла укажите путь к файлу HDFS, который вы хотите прочитать. Здесь мы читаем простой текстовый файл, поэтому наш тип файла — текстовый файл. Точно так же, в зависимости от вашего ввода, заполните разделитель строк, разделитель полей и данные заголовка, как указано ниже. Наконец, нажмите кнопку Изменить схему.

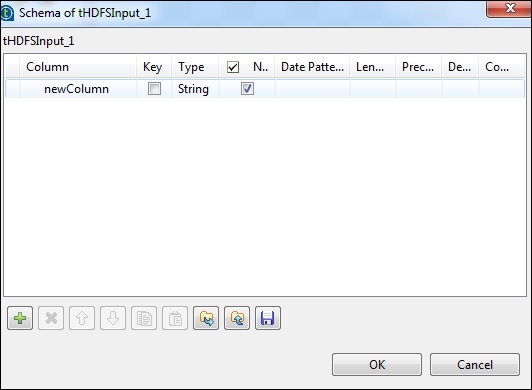

Поскольку в нашем файле просто текст, мы добавляем только один столбец типа String. Теперь нажмите Ok.

Примечание. Если вход содержит несколько столбцов разных типов, необходимо указать схему здесь соответствующим образом.

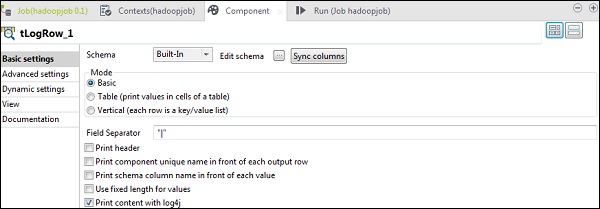

В компоненте tLogRow щелкните Синхронизировать столбцы в схеме редактирования.

Выберите режим, в котором вы хотите, чтобы ваш вывод был распечатан.

Наконец, нажмите Run, чтобы выполнить задание.

После того, как вы успешно прочитали файл HDFS, вы можете увидеть следующий результат.

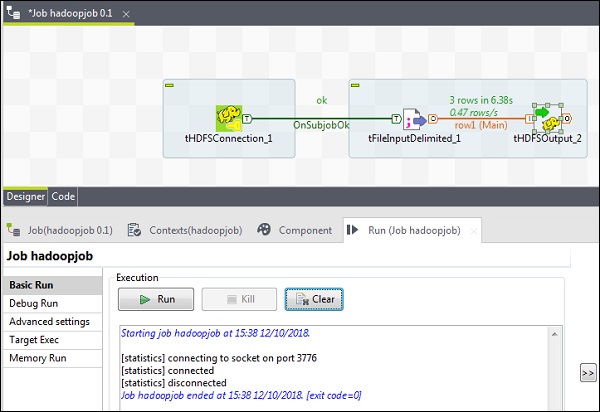

Запись файла в HDFS

Давайте посмотрим, как написать файл из HDFS в Talend. Перетащите 3 компонента — tHDFSConnection, tFileInputDelimited и tHDFSOutput из палитры в окно конструктора.

Щелкните правой кнопкой мыши tHDFSConnection и подключите компонент tFileInputDelimited с помощью триггера OnSubJobOk.

Щелкните правой кнопкой мыши tFileInputDelimited и перетащите основную ссылку в tHDFSOutput.

Обратите внимание, что tHDFSConnection будет иметь конфигурацию, аналогичную ранее.

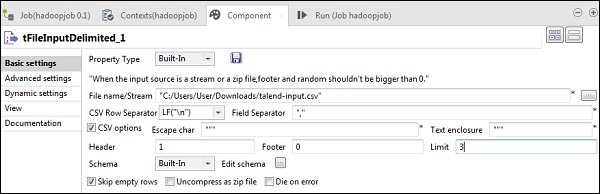

Теперь в tFileInputDelimited укажите путь к входному файлу в опции File name / Stream. Здесь мы используем CSV-файл в качестве входных данных, поэтому разделитель полей — «,».

Выберите верхний и нижний колонтитулы, лимит в соответствии с вашим входным файлом. Обратите внимание, что здесь наш заголовок равен 1, поскольку строка 1 содержит имена столбцов, а ограничение равно 3, поскольку мы записываем только первые 3 строки в HDFS.

Теперь нажмите «Изменить схему».

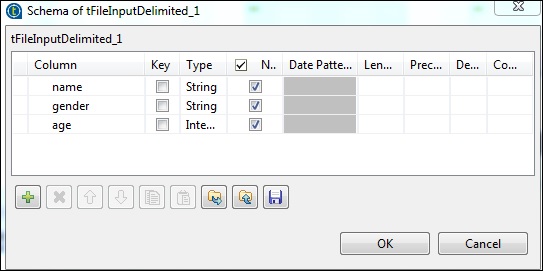

Теперь, согласно нашему входному файлу, определите схему. Наш входной файл имеет 3 столбца, как указано ниже.

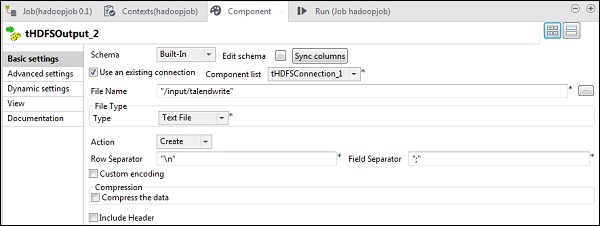

В компоненте tHDFSOutput щелкните по столбцам синхронизации. Затем выберите tHDFSConnection в Использовать существующее соединение. Также в поле «Имя файла» укажите путь HDFS, в который вы хотите записать свой файл.

Обратите внимание, что тип файла будет текстовым, действие будет «создавать», разделитель строк будет «\ n», а разделитель полей — «;»

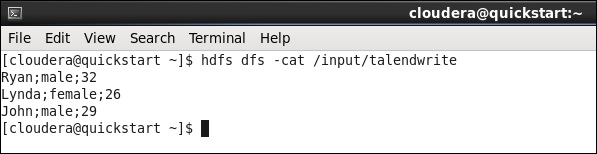

Наконец, нажмите Run, чтобы выполнить вашу работу. После успешного выполнения задания проверьте, есть ли ваш файл в HDFS.

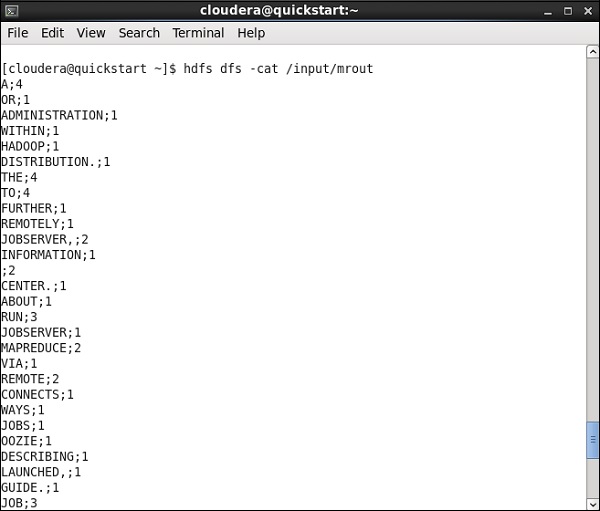

Запустите следующую команду hdfs с выходным путем, который вы упомянули в своей работе.

hdfs dfs -cat /input/talendwrite

Вы увидите следующий вывод, если вы успешно пишете на HDFS.

Таленд — Карта Уменьшить

В предыдущей главе мы увидели, как Talend работает с большими данными. В этой главе давайте разберемся, как использовать карту Reduce with Talend.

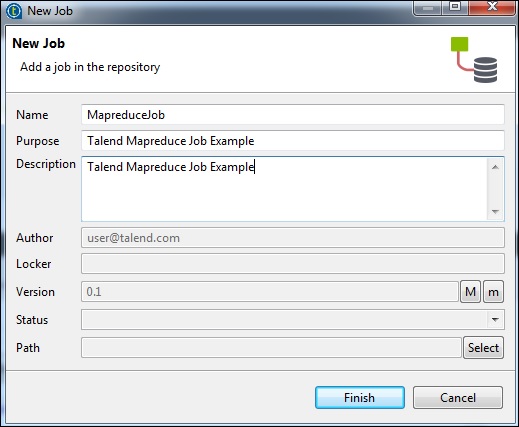

Создание задания Talend MapReduce

Давайте узнаем, как запустить задание MapReduce в Talend. Здесь мы запустим пример подсчета слов в MapReduce.

Для этого щелкните правой кнопкой мыши Job Design и создайте новую работу — MapreduceJob. Упомяните детали работы и нажмите Готово.

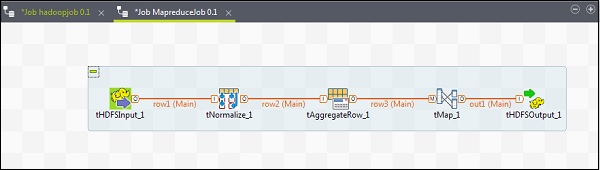

Добавление компонентов в MapReduce Job

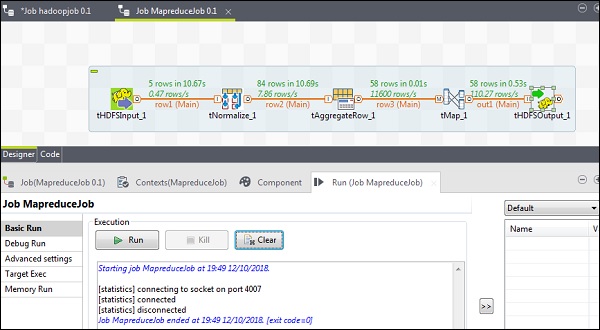

Чтобы добавить компоненты в задание MapReduce, перетащите пять компонентов Talend — tHDFSInput, tNormalize, tAggregateRow, tMap, tOutput из окна поддона в конструктор. Щелкните правой кнопкой мыши tHDFSInput и создайте основную ссылку для tNormalize.

Щелкните правой кнопкой мыши tNormalize и создайте основную ссылку на tAggregateRow. Затем щелкните правой кнопкой мыши tAggregateRow и создайте основную ссылку на tMap. Теперь щелкните правой кнопкой мыши на tMap и создайте основную ссылку на tHDFSOutput.

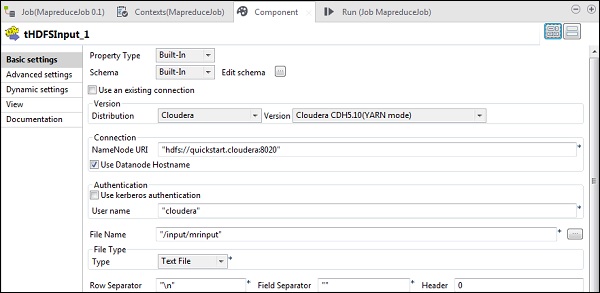

Конфигурирование компонентов и преобразований

В tHDFSInput выберите дистрибутив cloudera и его версию. Обратите внимание, что Namenode URI должен быть «hdfs: //quickstart.cloudera: 8020», а имя пользователя должно быть «cloudera». В опции имени файла укажите путь вашего входного файла к заданию MapReduce. Убедитесь, что этот входной файл присутствует в HDFS.

Теперь выберите тип файла, разделитель строк, разделитель файлов и заголовок в соответствии с вашим входным файлом.

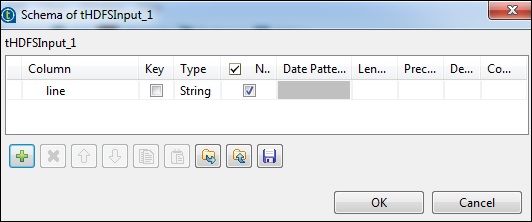

Нажмите на редактировать схему и добавьте поле «line» как строковый тип.

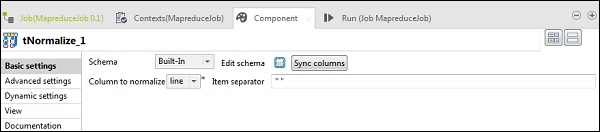

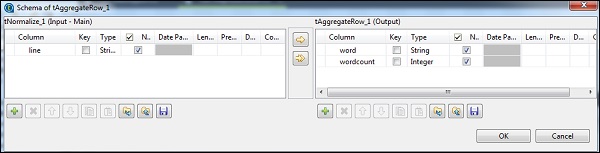

В tNomalize нормализуемым столбцом будет строка, а разделителем элементов будет пробел -> ««. Теперь нажмите «Изменить схему». У tNormalize будет строчный столбец, а у tAggregateRow будет 2 столбца word и wordcount, как показано ниже.

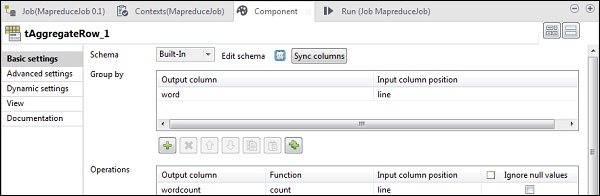

В tAggregateRow поместите слово в качестве выходного столбца в Group by option. В операциях укажите wordcount в качестве выходного столбца, функцию в качестве счетчика и позицию столбца ввода в качестве строки.

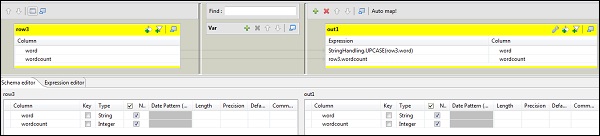

Теперь дважды щелкните компонент tMap, чтобы войти в редактор карт и сопоставить ввод с требуемым выводом. В этом примере слово отображается с word, а wordcount отображается с wordcount. В столбце выражений нажмите […], чтобы войти в построитель выражений.

Теперь выберите StringHandling из списка категорий и функцию UPCASE. Измените выражение на «StringHandling.UPCASE (row3.word)» и нажмите «ОК». Сохраните row3.wordcount в столбце выражения, соответствующем wordcount, как показано ниже.

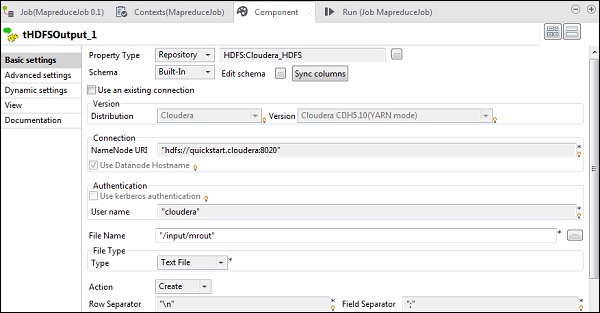

В tHDFSOutput подключитесь к кластеру Hadoop, который мы создали из типа свойства как хранилище. Обратите внимание, что поля будут заполнены автоматически. В поле Имя файла укажите выходной путь, в котором вы хотите сохранить выходные данные. Сохраните действие, разделитель строк и разделитель полей, как показано ниже.

Выполнение задания MapReduce

Как только ваша конфигурация будет успешно завершена, нажмите Run и выполните задание MapReduce.

Перейдите на путь HDFS и проверьте вывод. Обратите внимание, что все слова будут в верхнем регистре с их количеством слов.

Таленд — работа со свиньей

В этой главе мы узнаем, как работать с заданием «Свинья» в Talend.

Создание Задания Talend Pig

В этом разделе мы узнаем, как запустить задание Pig в Talend. Здесь мы обработаем данные NYSE, чтобы узнать средний объем запасов IBM.

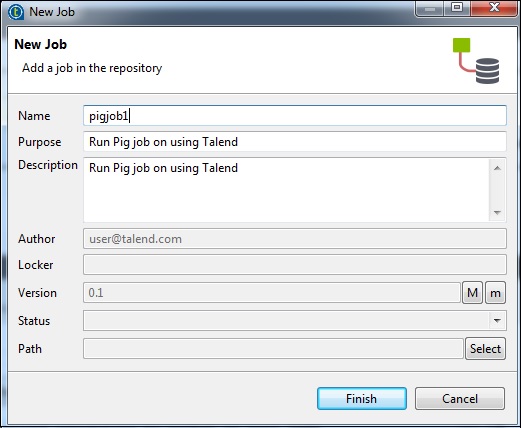

Для этого щелкните правой кнопкой мыши Job Design и создайте новую работу — pigjob. Упомяните детали работы и нажмите Готово.

Добавление компонентов в свиноводство

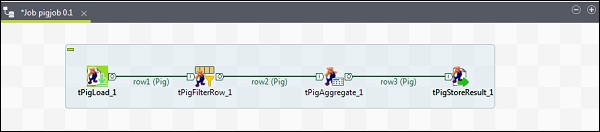

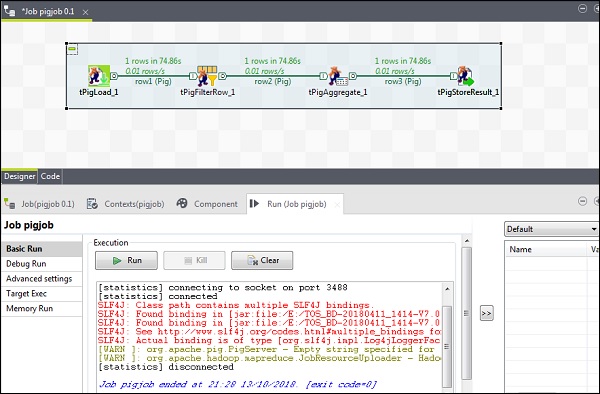

Чтобы добавить компоненты в задание Pig, перетащите четыре компонента Talend: tPigLoad, tPigFilterRow, tPigAggregate, tPigStoreResult, из окна поддона в конструктор.

Затем щелкните правой кнопкой мыши tPigLoad и создайте линию Pig Combine для tPigFilterRow. Затем щелкните правой кнопкой мыши tPigFilterRow и создайте линию Pig Combine для tPigAggregate. Щелкните правой кнопкой мыши tPigAggregate и создайте линию объединения Pig в tPigStoreResult.

Конфигурирование компонентов и преобразований

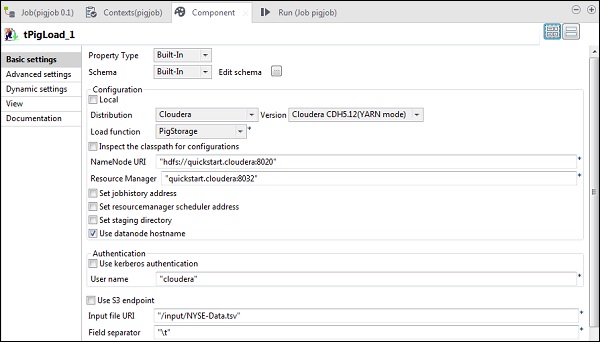

В tPigLoad упомяните дистрибутив как cloudera и версию cloudera. Обратите внимание, что Namenode URI должен быть «hdfs: //quickstart.cloudera: 8020», а менеджер ресурсов должен быть «quickstart.cloudera: 8020». Кроме того, имя пользователя должно быть «cloudera».

В URI входного файла укажите путь вашего входного файла NYSE к заданию PIG. Обратите внимание, что этот входной файл должен присутствовать в HDFS.

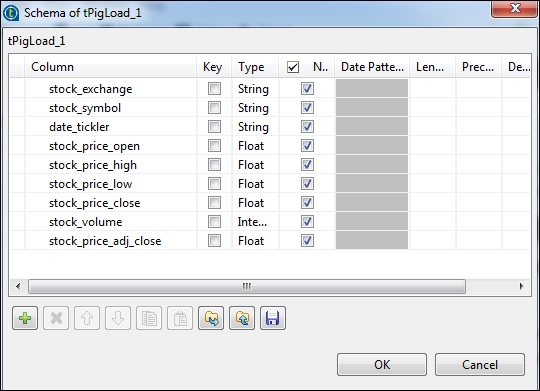

Нажмите изменить схему, добавьте столбцы и их тип, как показано ниже.

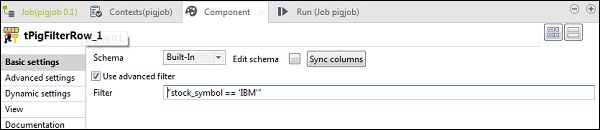

В tPigFilterRow выберите опцию «Использовать расширенный фильтр» и поместите «stock_symbol = = ‘IBM’» в опцию Фильтр.

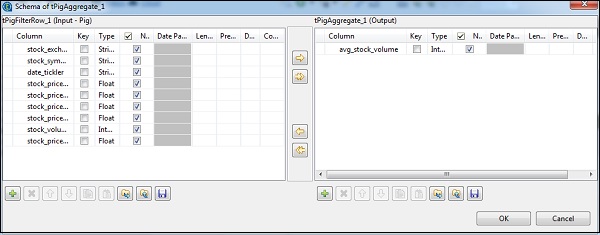

В tAggregateRow щелкните по редактировать схему и добавьте столбец avg_stock_volume в вывод, как показано ниже.

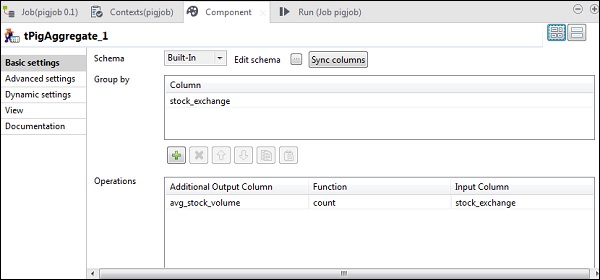

Теперь поместите столбец stock_exchange в группу по варианту. Добавьте столбец avg_stock_volume в поле «Операции» с параметром count и stock_exchange в качестве входного столбца.

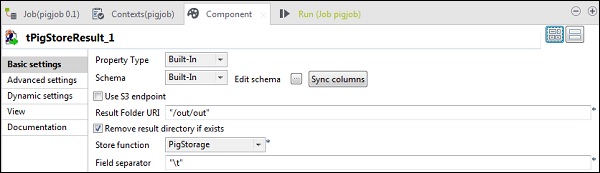

В tPigStoreResult укажите выходной путь в URI папки результатов, где вы хотите сохранить результат задания Pig. Выберите функцию хранилища как PigStorage и разделитель полей (не обязательно) как «\ t».

Выполнение Задания Свиньи

Теперь нажмите Run, чтобы выполнить задание Pig. (Игнорировать предупреждения)

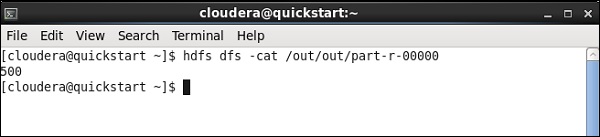

Как только работа закончится, перейдите и проверьте свои выходные данные по пути HDFS, который вы упомянули для сохранения результата работы со свиньей. Средний объем запасов IBM составляет 500.

Таленд — Улей

В этой главе мы расскажем, как работать с Hive job в Talend.

Создание задания Talend Hive

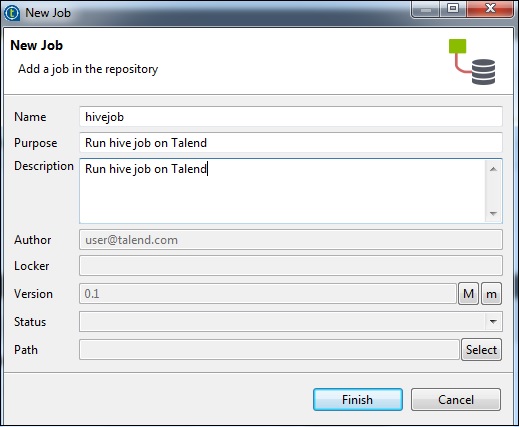

Например, мы загрузим данные NYSE в таблицу кустов и выполним базовый запрос улья. Щелкните правой кнопкой мыши на Job Design и создайте новую работу — hivejob. Упомяните детали работы и нажмите Готово.

Добавление компонентов в Hive Job

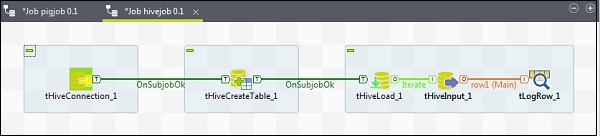

Чтобы привязать компоненты к заданию Hive, перетащите пять компонентов talend — tHiveConnection, tHiveCreateTable, tHiveLoad, tHiveInput и tLogRow из окна поддона в конструктор. Затем щелкните правой кнопкой мыши tHiveConnection и создайте триггер OnSubjobOk для tHiveCreateTable. Теперь щелкните правой кнопкой мыши tHiveCreateTable и создайте триггер OnSubjobOk для tHiveLoad. Щелкните правой кнопкой мыши tHiveLoad и создайте итерационный триггер на tHiveInput. Наконец, щелкните правой кнопкой мыши tHiveInput и создайте основную строку для tLogRow.

Конфигурирование компонентов и преобразований

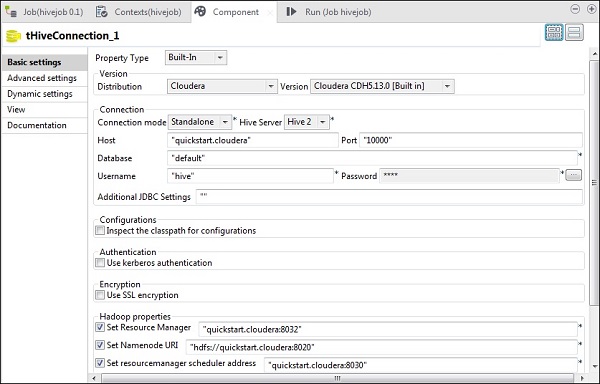

В tHiveConnection выберите дистрибутив в качестве cloudera и его версию, которую вы используете. Обратите внимание, что режим подключения будет автономным, а служба Hive будет Hive 2. Также проверьте, установлены ли следующие параметры соответственно:

- Ведущий: «quickstart.cloudera»

- Порт: «10000»

- База данных: «по умолчанию»

- Имя пользователя: «улей»

Обратите внимание, что пароль будет заполнен автоматически, вам не нужно его редактировать. Также другие свойства Hadoop будут предустановлены и установлены по умолчанию.

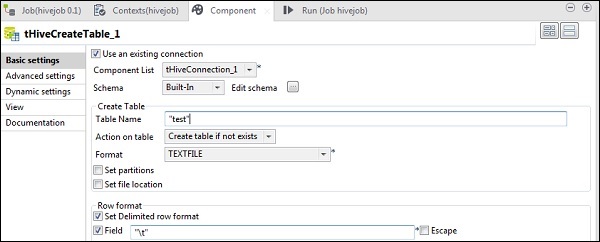

В tHiveCreateTable выберите «Использовать существующее соединение» и поместите tHiveConnection в список компонентов. Дайте Имя таблицы, которую вы хотите создать в базе данных по умолчанию. Сохраните остальные параметры, как показано ниже.

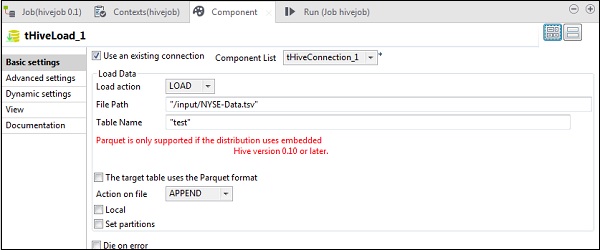

В tHiveLoad выберите «Использовать существующее соединение» и поместите tHiveConnection в список компонентов. Выберите LOAD в действии Load. В поле «Путь к файлу» укажите путь HDFS вашего входного файла NYSE. Укажите в таблице имя таблицы, в которую вы хотите загрузить данные. Сохраните остальные параметры, как показано ниже.

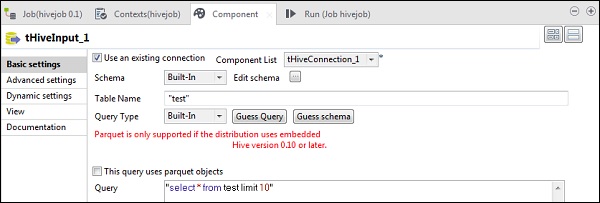

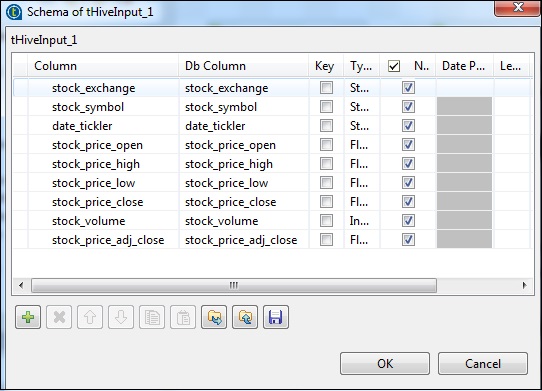

В tHiveInput выберите Использовать существующее соединение и поместите tHiveConnection в список компонентов. Нажмите «Изменить схему», добавьте столбцы и их тип, как показано на снимке схемы ниже. Теперь дайте имя таблицы, которую вы создали в tHiveCreateTable.

Поместите ваш запрос в опцию запроса, которую вы хотите запустить в таблице Hive. Здесь мы печатаем все столбцы первых 10 строк в таблице тестового куста.

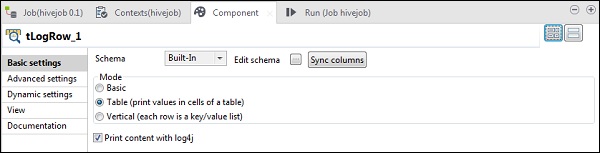

В tLogRow щелкните синхронизировать столбцы и выберите режим таблицы для отображения выходных данных.

Выполнение задания улья

Нажмите Run, чтобы начать выполнение. Если все соединение и параметры были установлены правильно, вы увидите вывод вашего запроса, как показано ниже.